一、cube.AI简介及cubeIDE集成3 F7 f. B1 e" \3 Q) I8 o

1.1 cube.AI介绍

; b+ n) p4 a# I$ v5 N2 I, e1 O# Q* |! n cube.AI准确来说是STM32Cube.AI,它是ST公司的打造的STM32Cube生态体系的扩展包X-CUBE-AI,专用于帮助开发者实现人工智能开发。确切地说,是将基于各种人工智能开发框架训练出来的算法模型,统一转换为c语言支持的源码模型,然后将c模型与STM32的硬件产品结合,实现人工智能模型可直接部署在前端或边缘端设备,实现人工智能就地计算。

9 P0 l7 e/ A+ N. ~. Y

2 u1 @; Q7 Q; S cube.AI 以插件形式支持ST相关开发平台如cubeIDE、cubeMX、keil等,整体开发过程分为三个主要部分,1)收集及治理数据,2)训练及验证模型,3)c模型生成及前端或边缘端部署,如下图所示:

% r. X; ^- {1 _5 [& I& y

! H+ q, K, p) o! N% w0 P# R

3 U7 b8 I' |9 \+ @

" `* g/ _. h9 { n; p) E( o* k 目前cube.AI支持各种深度学习框架的训练模型,如Keras和TensorFlow™ Lite,并支持可导出为ONNX标准格式的所有框架,如PyTorch™、Microsoft® Cognitive Toolkit、MATLAB®等,然后通过 cube.MX可视化配置界面导入这些深度学习框架导出的训练模型来配置及生成c模型,进而部署在STM32芯片上。; Q& U, s# j G' A/ z

3 m) U6 t2 A9 k# @

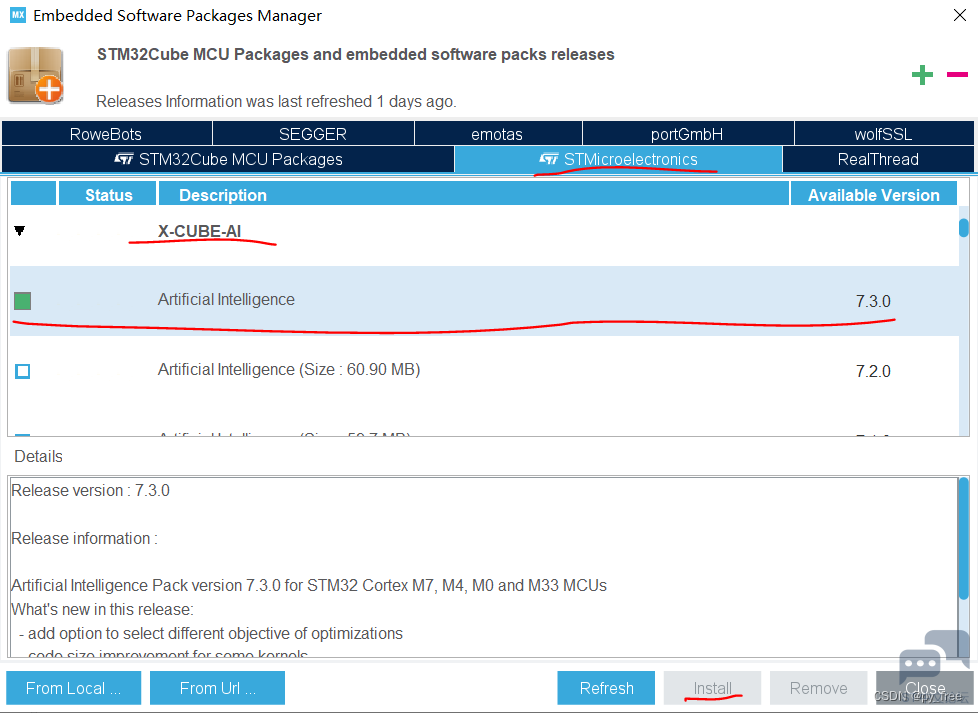

" J+ G, z) |) `4 D 1.2 cube.AI与cubeIDE集成与安装

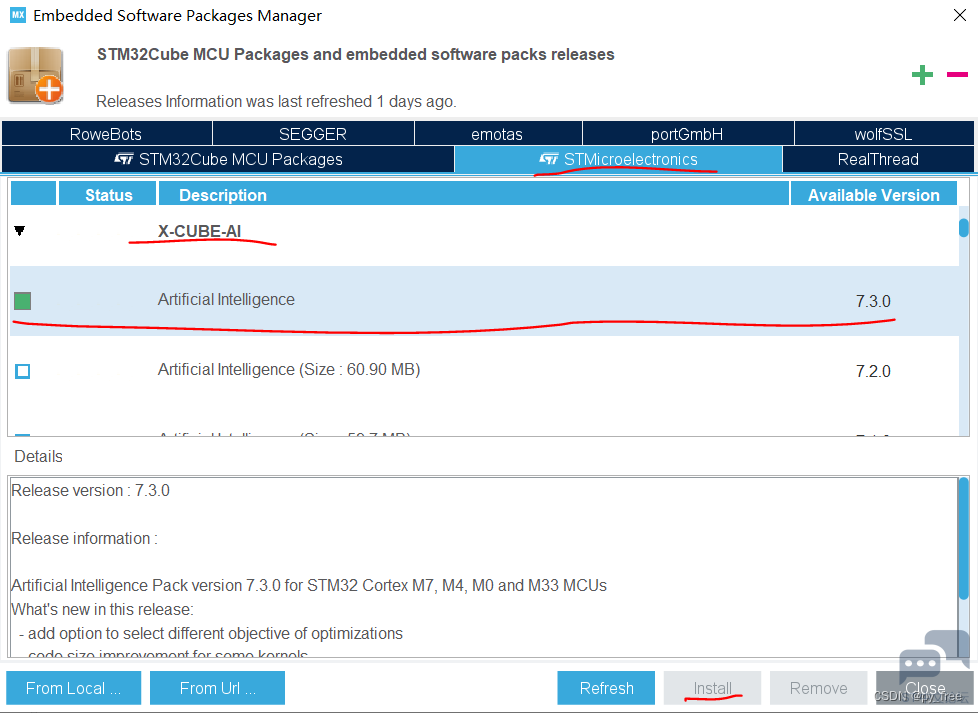

9 I/ J Q) A- O6 o 在cubeIDE的帮助菜单栏,选择嵌入式软件包管理项(Embedded Software Packages Manager)进入X-CUBE-AI扩展包安装页面。选择X-CUBE-AI需要的版本进行安装即可,如下图所示,安装完成后,该版本前面方框呈绿色标记。

: d& L2 A" [7 y6 w- g+ A X+ t: `. \' h6 B: p

+ F7 E8 W$ D0 n% s- L( ?% F0 a! l3 L3 N+ P$ e. i* M% `

4 {$ ]) u1 P: g$ N5 B 1.3 cube.AI支持硬件平台

" m3 v+ ?) Z$ [) Y* n8 d 得益于ST公司不断的优化及迭代X-CUBE-AI扩展包,神经网络模型生成c模型后得以使用更小的算力资源和几乎无损的算法精度,因此使其能部署到STM32绝大多数的芯片上,目前其支持的MCU及MPU型号如下图所示。

! n8 r) D" P% b4 t1 ~) J

3 ^- X H! X7 m% ~" U! T" A

; v& W8 O; V4 r: r( \: t( n, O c

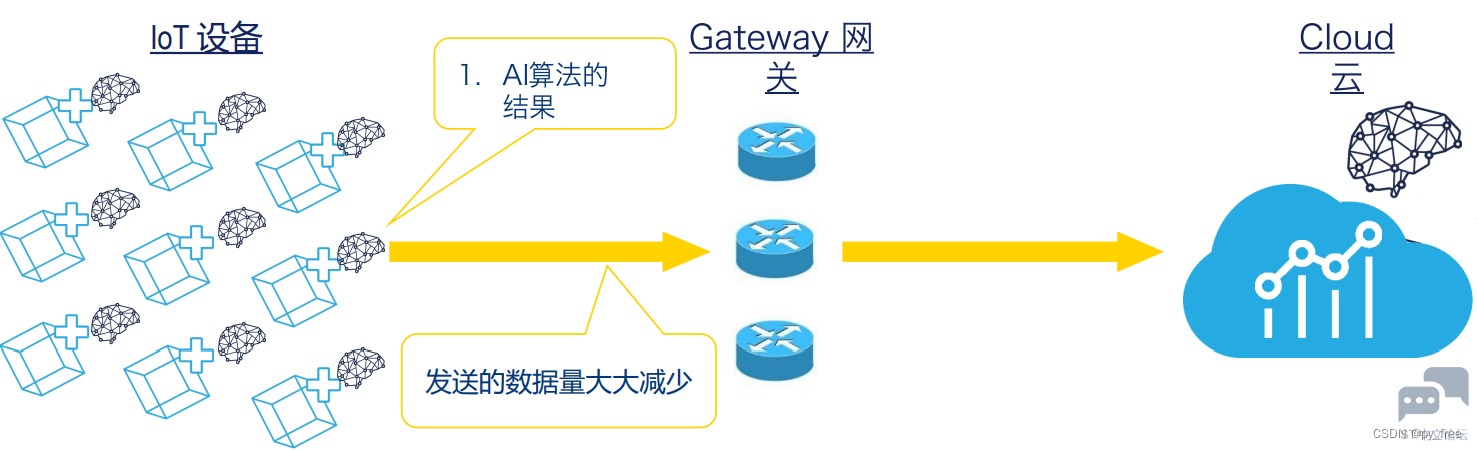

1.4 cube.AI应用的好处) V; ~7 T _- ~. I$ I2 K9 M! @

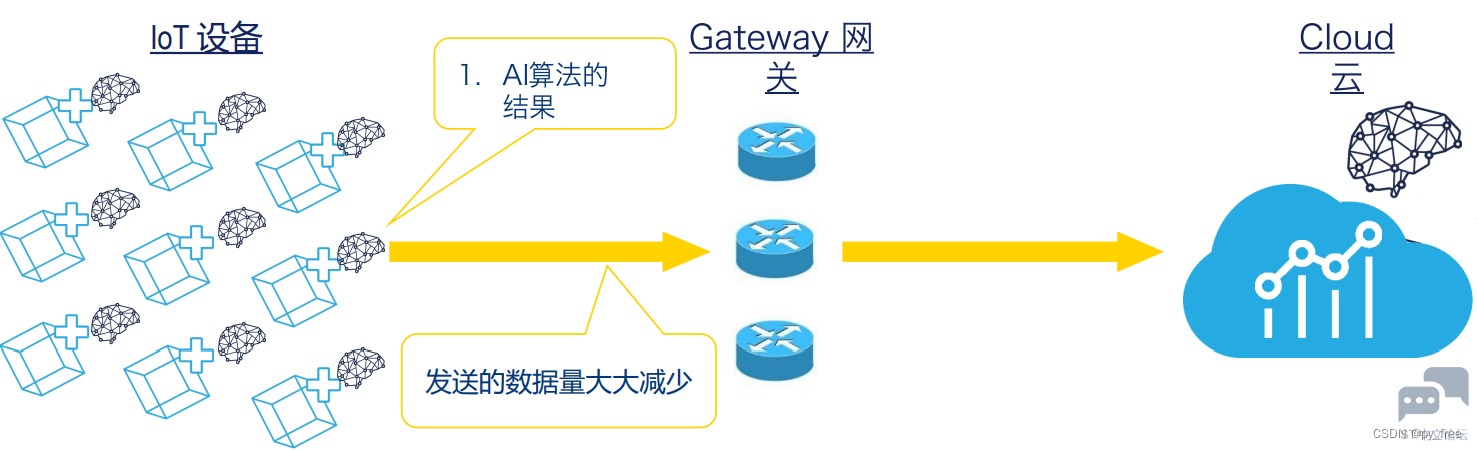

将神经网络边缘化部署后,减少延迟、节约能源、提高云利用率,并通过大限度地减少互联网上的数据交换来保护隐私,而结合X-CUBE-AI使得神经网络部署在边缘端端的便捷、灵活、低成本,微机智能成为更多产品的选择。# l0 R' @5 ~. _

9 w) L9 T7 j5 `- s6 r; a" P8 ~( R

$ V/ S; U3 S) D& s0 V$ k

$ V/ S; U3 S) D& s0 V$ k

% c G: Z( `& z& r* _8 g% B p0 y 二、FP-AI-SENSING1

3 Q- a* o1 e, h6 o) G 2.1 FP-AI-SENSING1简介

/ \* q n/ m+ r FP-AI-SENSING1是ST公司提供的STM32Cube.AI示例,可通过BLE(低功耗蓝牙)将物联网节点连接到智能手机,并使用STBLESensor应用程序,配置设备,实现数据采集,使得用于训练神经网络模型的数据更贴近实际使用场景,具有更好的训练效果和精度。

+ o# d7 s* l+ A3 h/ n- g$ i" H

( `3 X. n4 p) d4 m 在FP-AI-SENSING1案例页面,下载源码包及其数据手册。

: X' M( W! _, j7 t% Y# o- ` m% x3 P

+ r8 y( n7 b& p& {$ x3 p1 l/ g

1 L8 h9 h w2 ?7 v* A% }: p

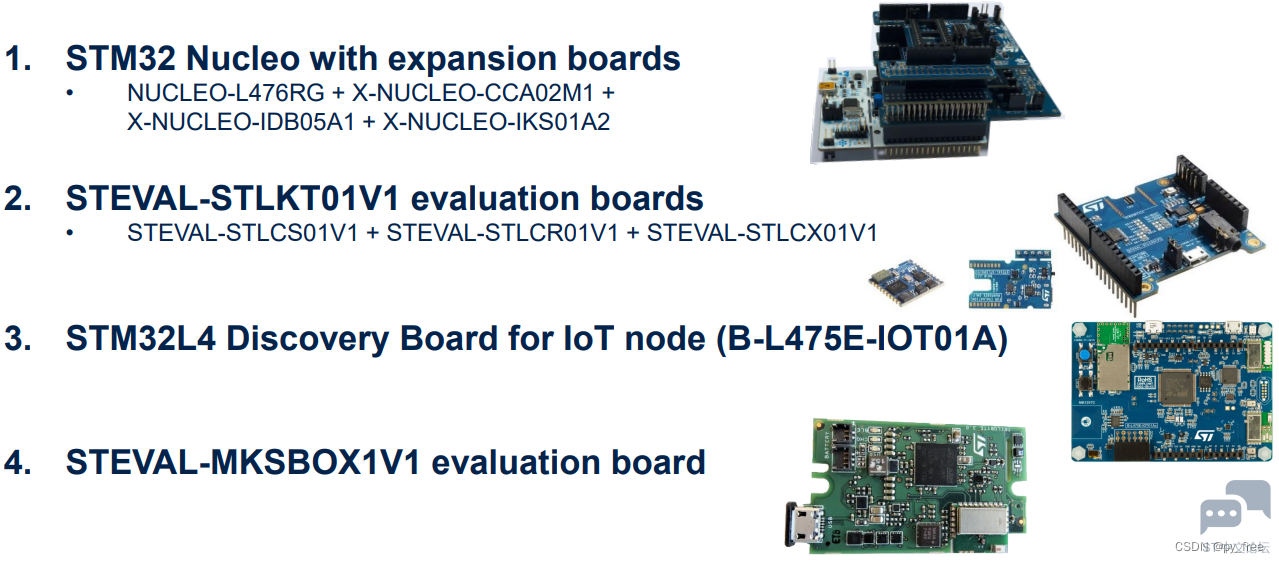

5 s B! S; J. \! L+ e* f! m1 W- I+ d3 V 2.2 FP-AI-SENSING1软件包支持硬件平台

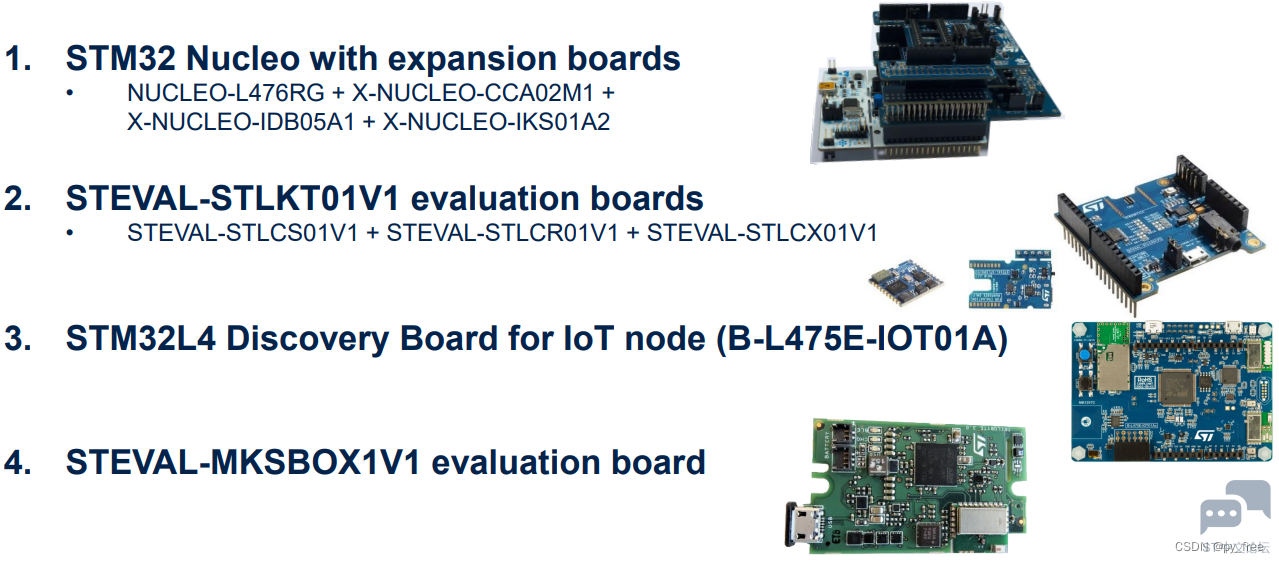

+ r+ C: ?( U, J: {# Y: \ ST公司为FP-AI-SENSING1示例运行提供了硬件平台,支持开发者快速学习了解FP-AI-SENSING1示例,从而了解Cube.AI的开发过程。6 h8 [- J# b" R5 Q+ i

! }, _* S8 ?4 H. ?/ N

. x: I+ m" ^- h+ ?! [1 K4 W, @) e, T( J# p/ S

三、FP-AI-SENSING1部署

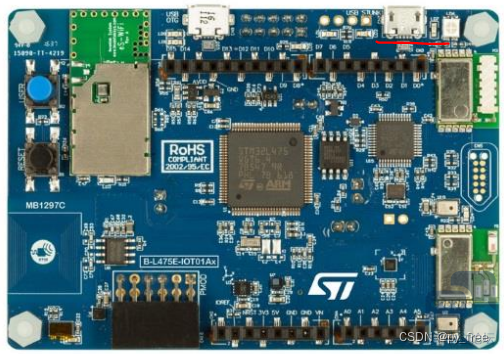

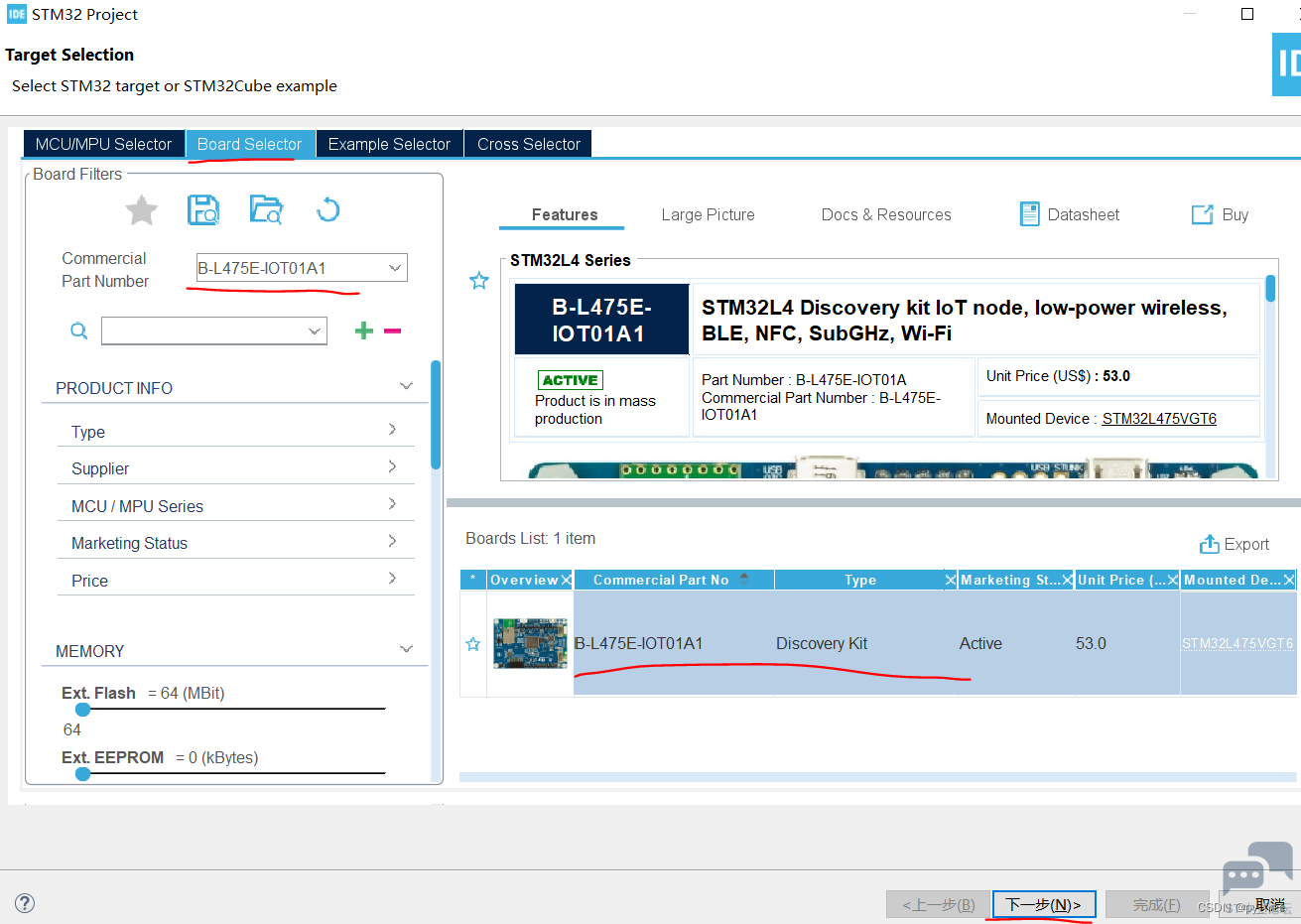

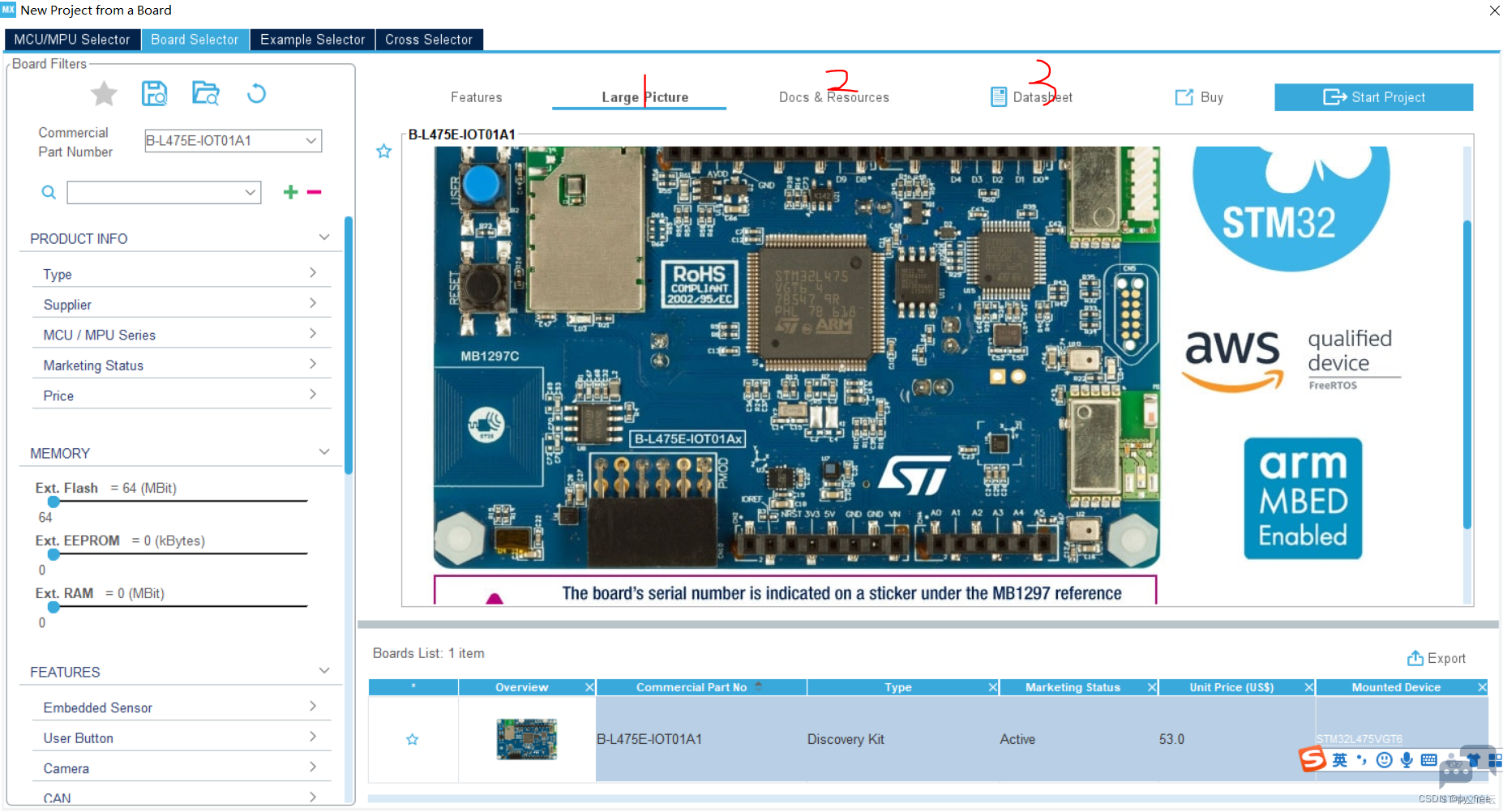

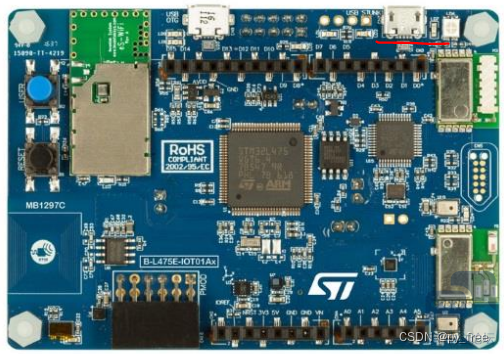

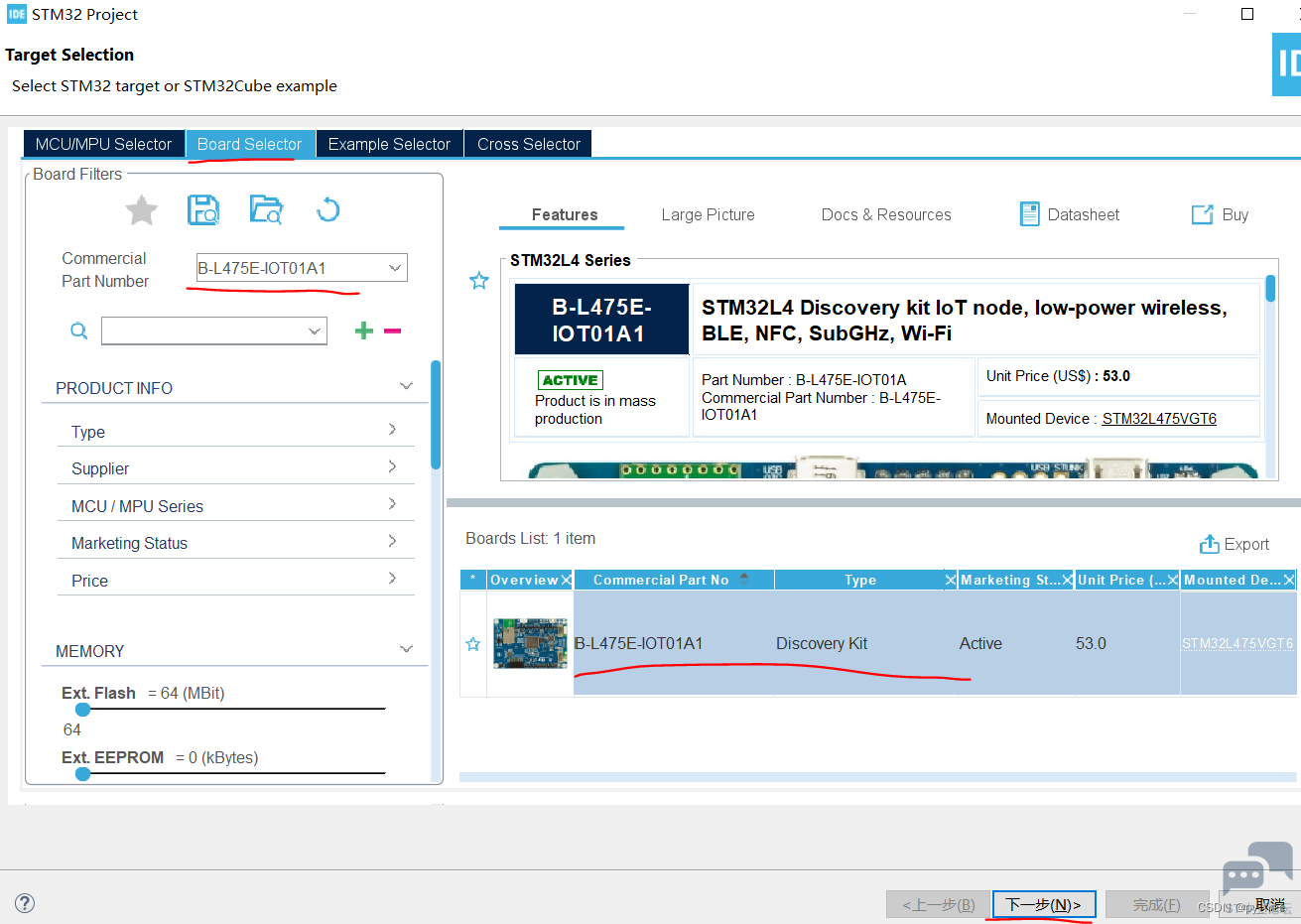

+ ^' s6 J( h' u0 c3 f4 q 3.1 B-L475E-IOT01A开发板

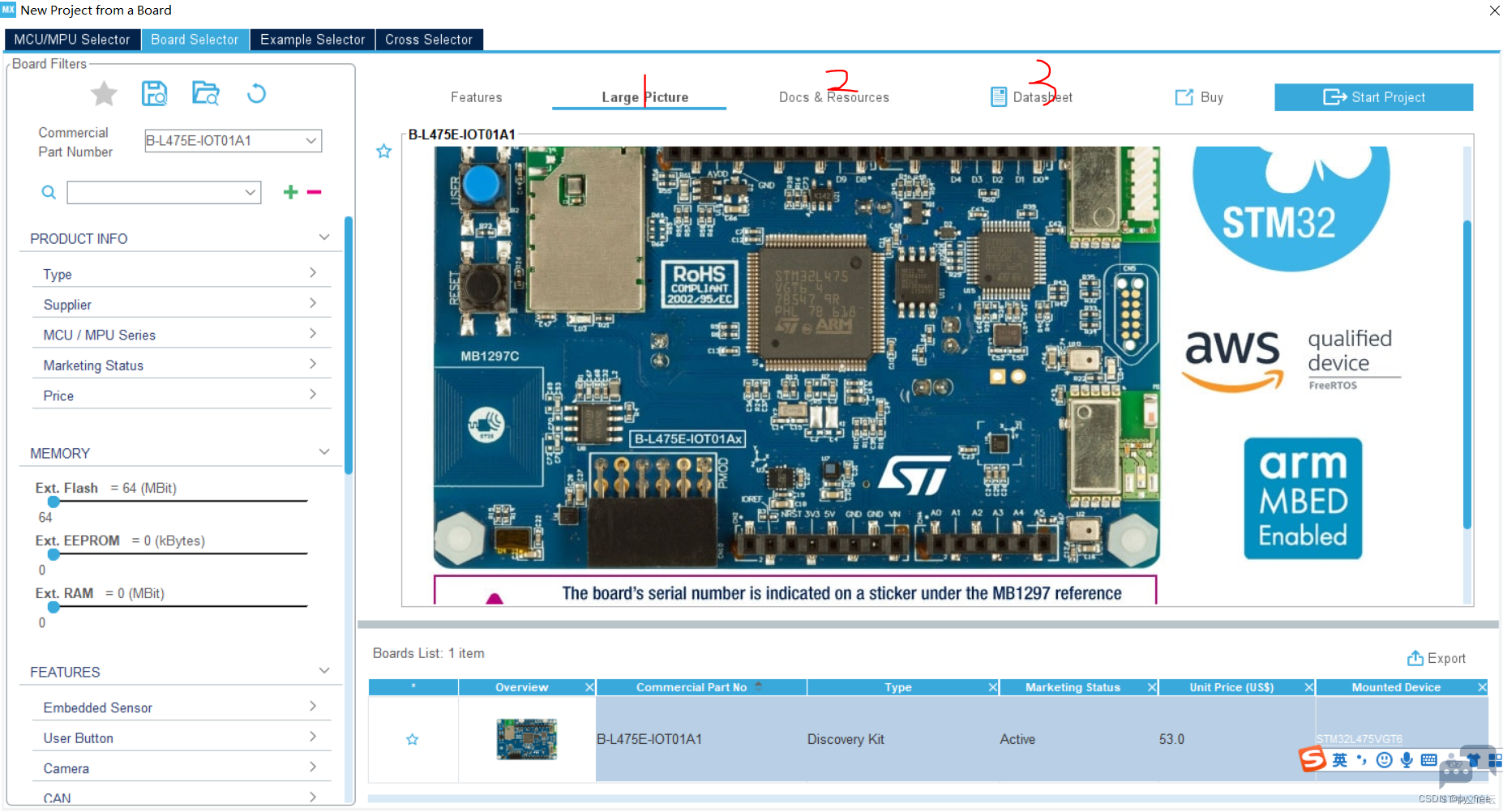

2 k# m5 s- ? r/ s+ P 本文采用ST公司的B-L475E-IOT01A开发板,打开CubeMX工具,选择Start my project from ST Board,搜索B-L475E-IOT01A,如下图所示,可以在1、2、3页面下载开发板相关的原理框图、文档及案例、说明手册。+ |1 @$ ?, C e. L6 p

( P& u; ^' v* O2 B

: v8 ^% o1 `& i! M/ n

: v8 ^% o1 `& i! M/ n

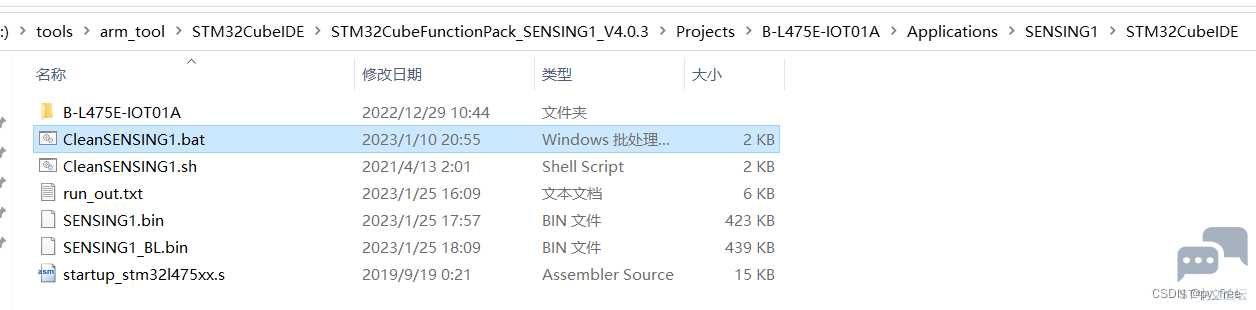

9 }' u2 Z$ E% [( N; i U, j 3.2 FP-AI-SENSING1软件包下载及配置

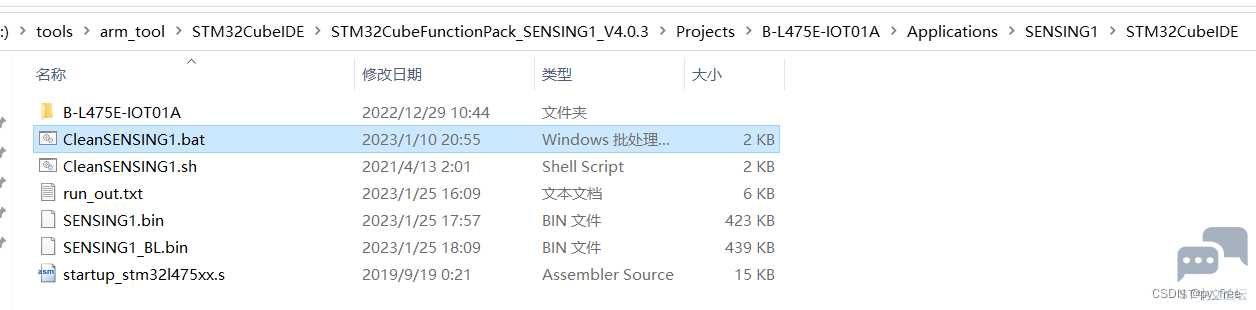

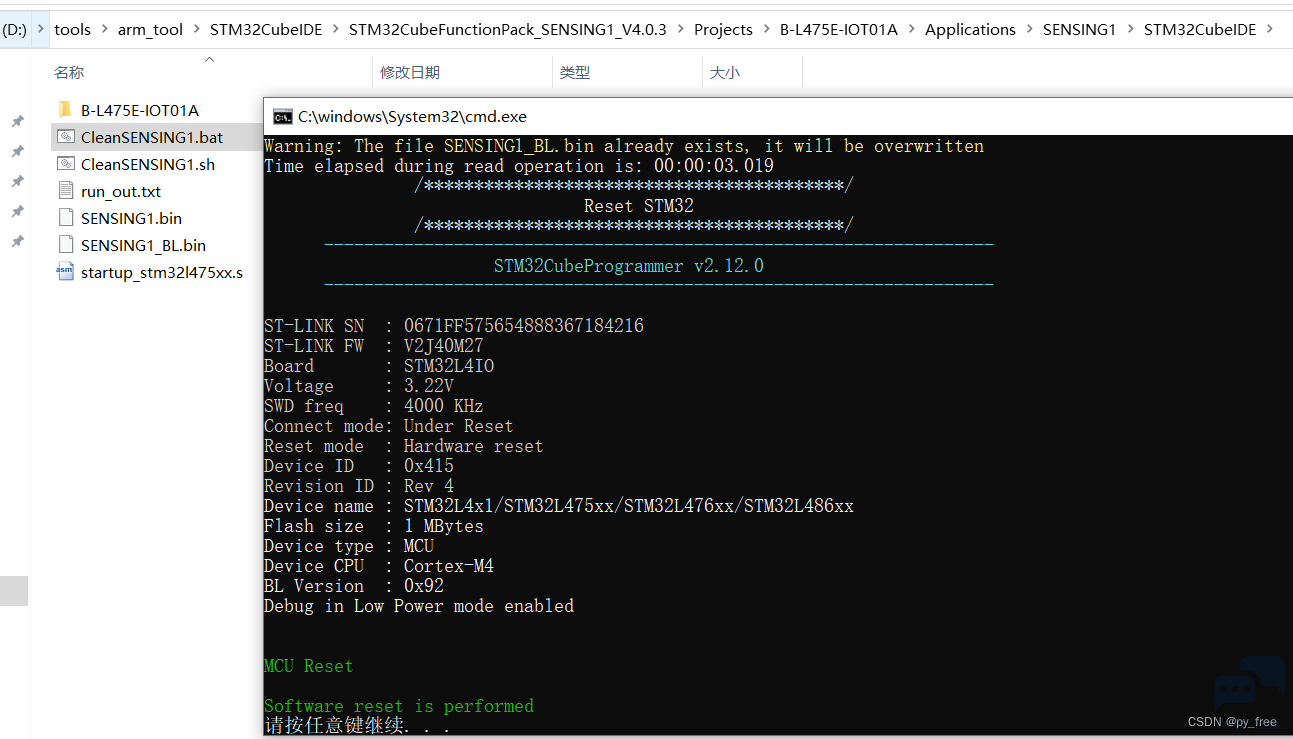

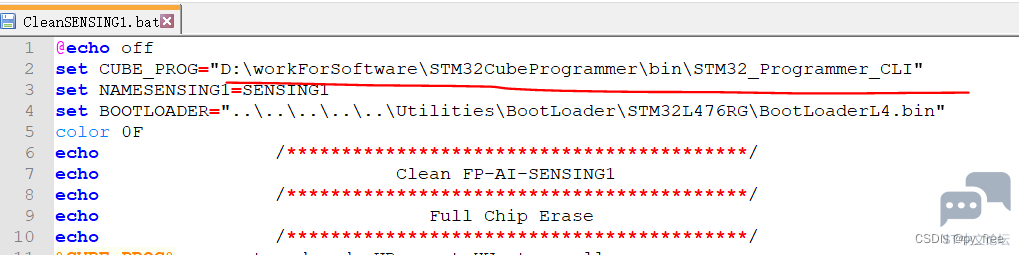

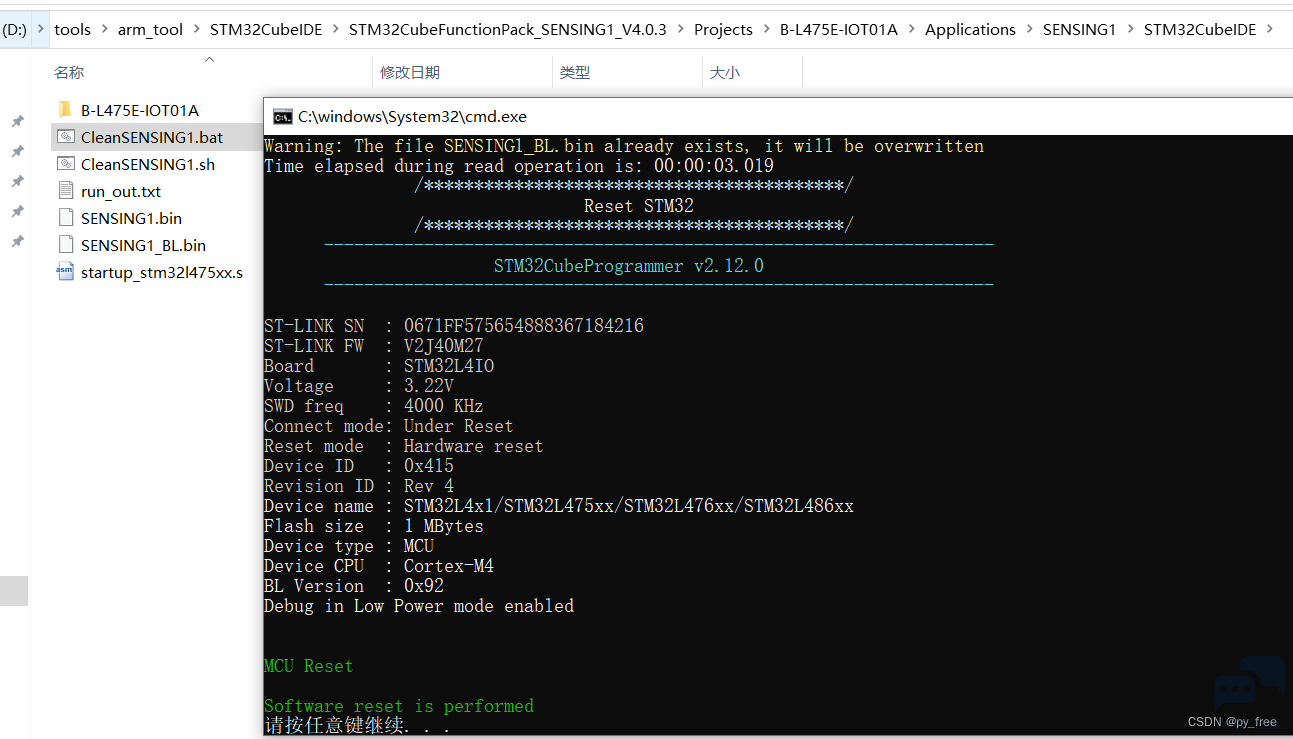

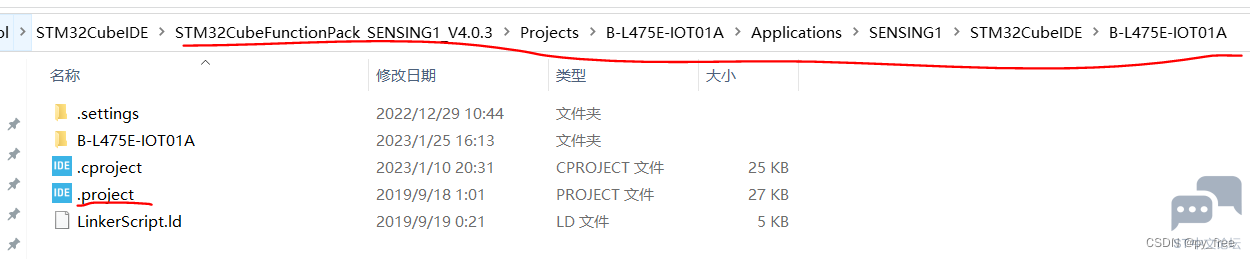

. r) f/ v+ r" y- b* E7 N 下载FP-AI-SENSING1软件包后,解压下载的源码包:en.fp-ai-sensing1.zip,进入“STM32CubeFunctionPack_SENSING1_V4.0.3\Projects\B-L475E-IOT01A\Applications\SENSING1\STM32CubeIDE”目录,用文本编辑工具打开“CleanSENSING1.bat”,(linux系统的,采用CleanSENSING1.sh文件)。

- p% l1 V, y+ Y8 {

3 @* P0 B& y( f( {% p

( \1 H. r5 ?2 z% z6 W

( \1 H. r5 ?2 z% z6 W

' Z3 m& L* |( }3 j. k1 a6 v7 a CleanSENSING1.bat运行依赖STM32cube生态的另一个开发工具:STM32CubeProgrammer,该工具可以帮助开发者读取、写入和验证设备内存等。

- \7 n) M7 U5 p! w4 n+ \4 |# Y0 x+ N( z9 i8 c

在STM32CubeProgrammer工具下载页面,下载该工具及说明手册:/ L4 n% k, {2 d9 Y. [7 r3 q5 E

# `# G/ L8 P4 B! V. L* v7 T

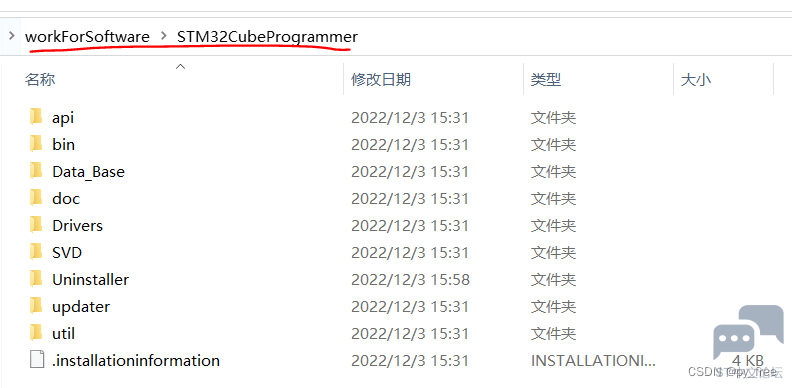

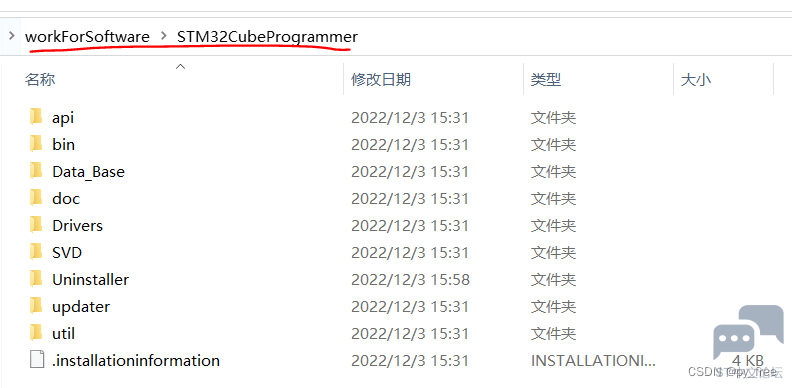

$ u" n$ d' I5 g# d. \* T8 M3 E 下载并安装STM32CubeProgrammer工具,例如本文安装目录为:D:\workForSoftware\STM32CubeProgrammer

: n. ]: R/ Z0 H9 C7 I# u7 {0 R- y1 P( o+ `) e

- J j* W% \' q6 B7 Z# E

- J j* W% \' q6 B7 Z# E

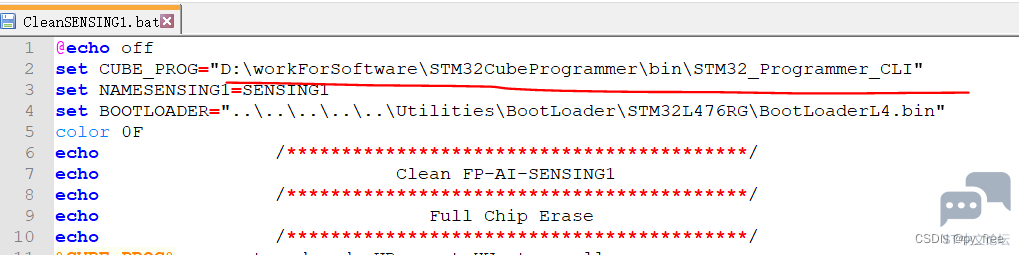

' m/ I. M9 n4 ~ 修改CleanSENSING1.bat依赖工具“STM32CubeProgrammer”的路径:

+ t: h d& }" y1 `( r& j$ l& }

8 w1 h9 A) W" u- ^$ E: A

1 U8 ~4 \6 p4 H: c6 h) p# x+ g. M& \1 Z5 E& m: g! V

3.3 固件烧录

3 J+ ~; w+ W, K6 ~5 f G0 ^ 将B-L475E-IOT01A开发板用Micro USB连接到电脑上,8 g: y, [; k( _9 `; ]& U* u$ t

9 h) V$ x# y+ |* _

- B8 p. D, _5 Q; B0 T3 \& N

, K$ L- p2 L) w% [6 p# _ 连接之后,驱动会自动安装,进入设备管理页面,确认串口编号和配置串口参数。0 S* \7 A' v2 N, j) U& h3 `' ^

- [8 P% y/ m1 n& G2 b& D

0 e. {1 j! n& h! Y

0 e. {1 j! n& h! Y

8 w& l' D. h; s7 y$ Q. h 右键CleanSENSING1.bat文件以管理员身份运行,将在开发板安装引导加载程序和更新固件。

7 I4 N9 |$ C& `8 {' T, X" a

9 c; m3 u: W& @; Q& r

: f) ? a; D0 [& j8 L% D

. F; i6 D w: M+ [3 w5 H 该脚本可以对B-L475E-IOT01A开发板实现以下操作,

. A7 B/ M: O& O: x* P2 c. R/ }•完全闪存擦除% [5 ^+ y* `( \7 y

•在右侧闪存区域加载BootLoader, Y3 x6 U8 }+ w

•在右侧闪存区域加载程序(编译后)

2 X) k) ?) k% s6 @7 Z4 |•重置电路板

1 _/ E$ i0 `0 r! g3 C& a% H

! i8 H; M5 x4 c( s* c% H8 f7 A

5 K: A, F/ i4 z6 l 3.4 FP-AI-SENSING1示例工程部署7 d3 `$ d) u$ X. y; b: {

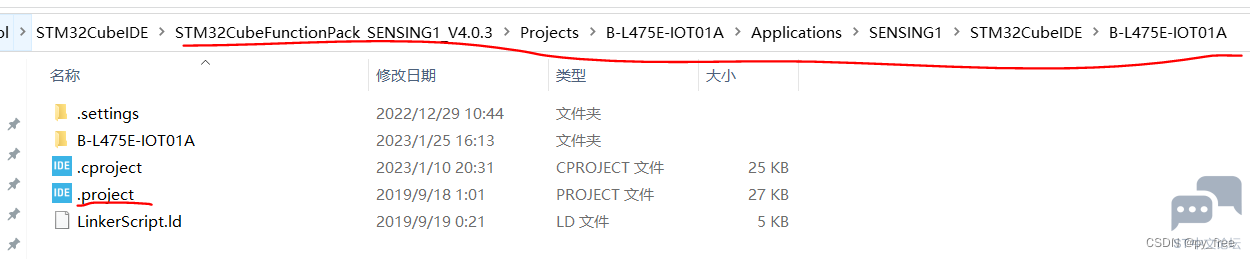

在该目录下,进入“B-L475E-IOT01A”目录,用CubeIDE打开.project,打开FP-AI-SENSING1工程。

T5 ^* m% G" R/ H7 u# @

. c+ U( g& L. u

2 L9 o7 i% r' f" J3 f

- X. |! j. s2 O9 \8 t! ^+ ] 打开该工程后如下图所示,用户可调整源码在User目录,关于本工程信息请查看readme.txt文件。

( t! a5 U0 Z! ?7 {: `( O! S2 Z+ @ v( ?$ S" B- G4 i

) y8 @7 F0 M( e# Y- N- ~2 f1 S7 A) ~

在main.c函数中找到Init_BlueNRG_Stack函数,该函数可以设置BLE(低功耗蓝牙)的服务名,

" J( ^! N# `* [- static void Init_BlueNRG_Stack(void)

1 r: \5 {* M) `, {9 K7 s3 y) b! ?# n - {

+ j9 b' `' v: |6 q7 S: }+ f$ \ - char BoardName[8];

% P) T5 W/ b( ~9 N6 G& L+ c' ? - uint16_t service_handle, dev_name_char_handle, appearance_char_handle;

4 y5 S- ?# H* L/ a0 B0 K - int ret; `' _' O2 S [+ R

- & {5 a6 ] M8 Y3 Z" l

- for(int i=0; i<7; i++) {$ Q% F4 y9 z6 W/ Z

- BoardName[i]= NodeName[i+1];6 \9 F1 m0 n4 |) @1 O( B- D6 `

- }

9 `! J. q4 U4 b3 x 该函数采用默认的BLE名称,该默认名称定义在SENSING1.h设置,例如:IAI_4035 ?# S- m7 D! x. B

5 X- Z; A) }( J- d: Q r( P

5 w* A. W! ?2 ~. e# d- J1 c8 H

5 w* A. W! ?2 ~. e# d- J1 c8 H

& M* ~" q- k, w2 Z 现在调整BLE名称为AI_Test

, [( i6 a- Q; L3 ~. M9 t4 W$ F- static void Init_BlueNRG_Stack(void). m; |4 J$ z6 \7 C4 m

- {

% }' p0 Y, i1 r& H - // char BoardName[8];( R% M8 S0 f( Z+ w# \( M: Q6 T2 \. @

- char BoardName[8] = {'A','I','_','T','e','s','t'};% g* K2 t0 G; V, H

- uint16_t service_handle, dev_name_char_handle, appearance_char_handle;

& y5 Y2 D0 x8 {( ` - int ret;$ g3 Q2 a* ]; Y

-

" b) z3 P' H8 T" y( ?6 o0 V+ H1 | - for(int i=0; i<7; i++) {

( v0 f& h7 B$ O- y- S - // BoardName[i]= NodeName[i+1];

# w4 h0 ~1 k: c5 W# t - NodeName[i+1] = BoardName[i];

1 q* C. g) l* F& A3 H- } - }

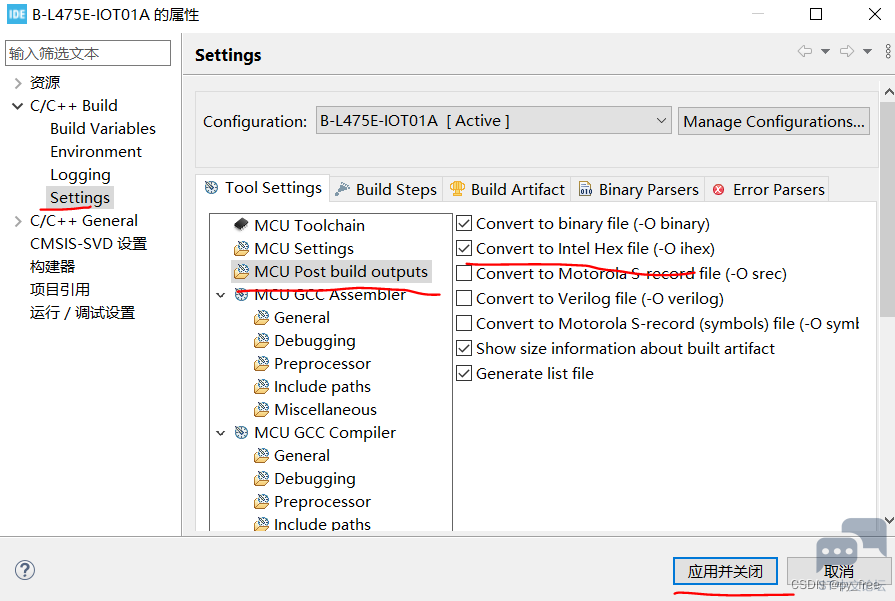

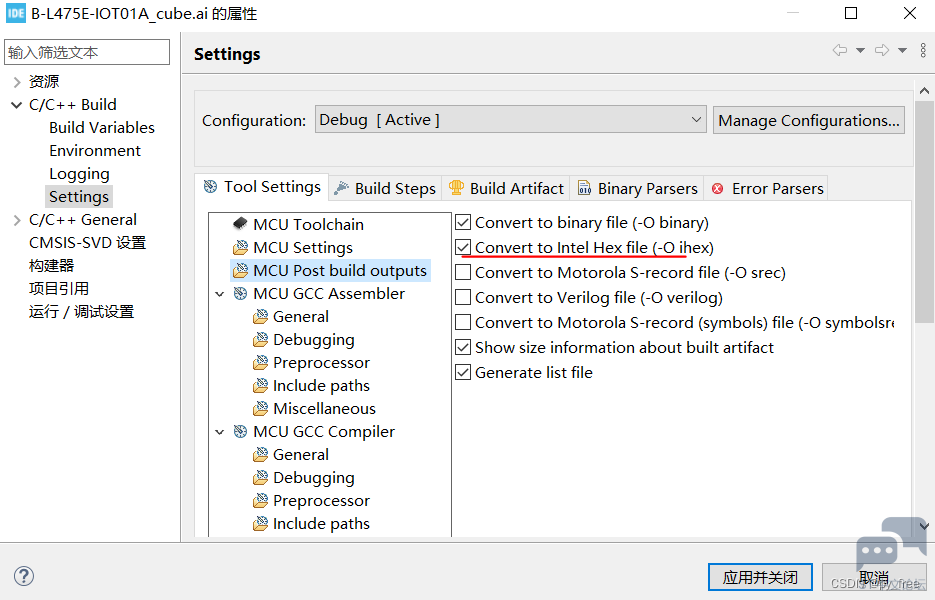

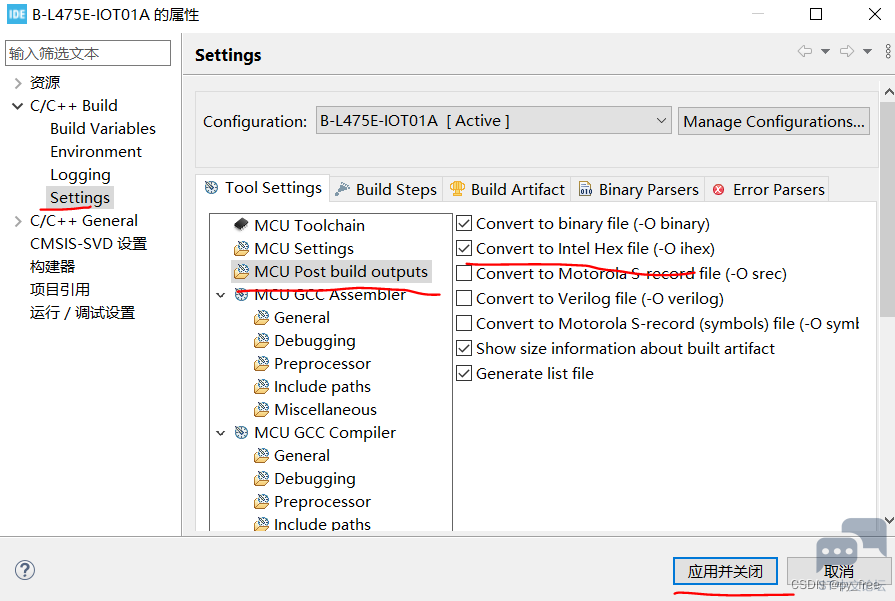

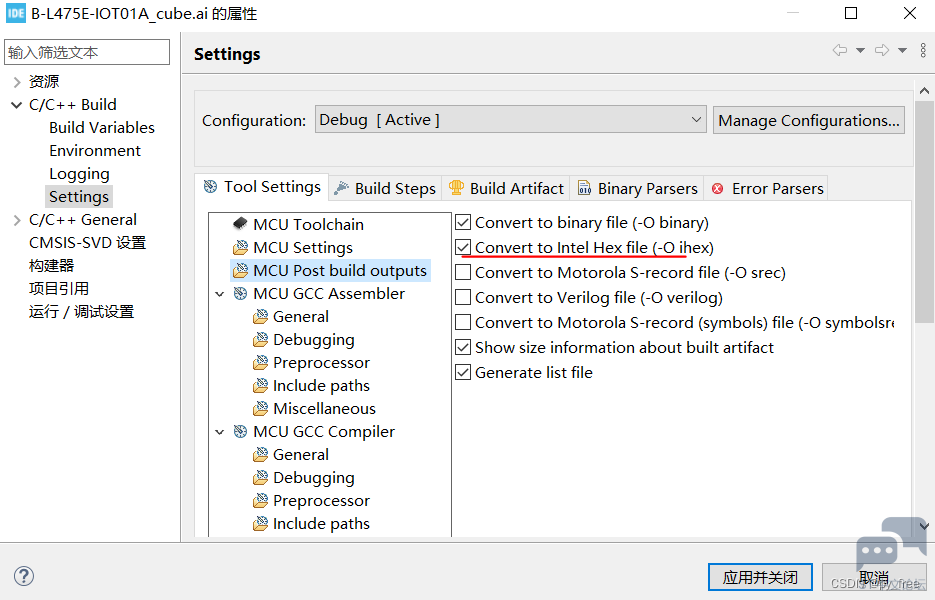

配置工程输出格式支持如下:7 k, l& ^: q7 c8 r& d

& ?5 J1 e: ]1 Q2 N, \9 ?

! `4 K. B3 }% o, l6 E$ Q- i: h/ D \9 ~" R( L2 Q

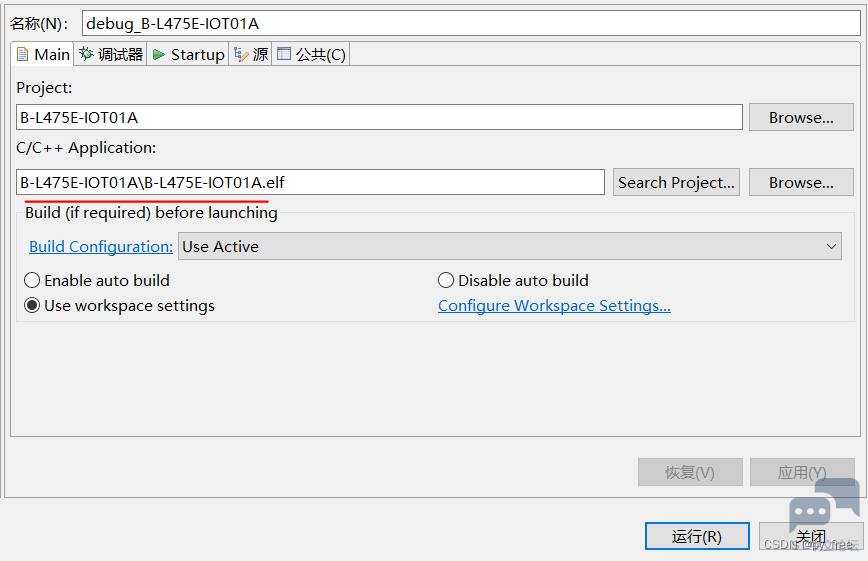

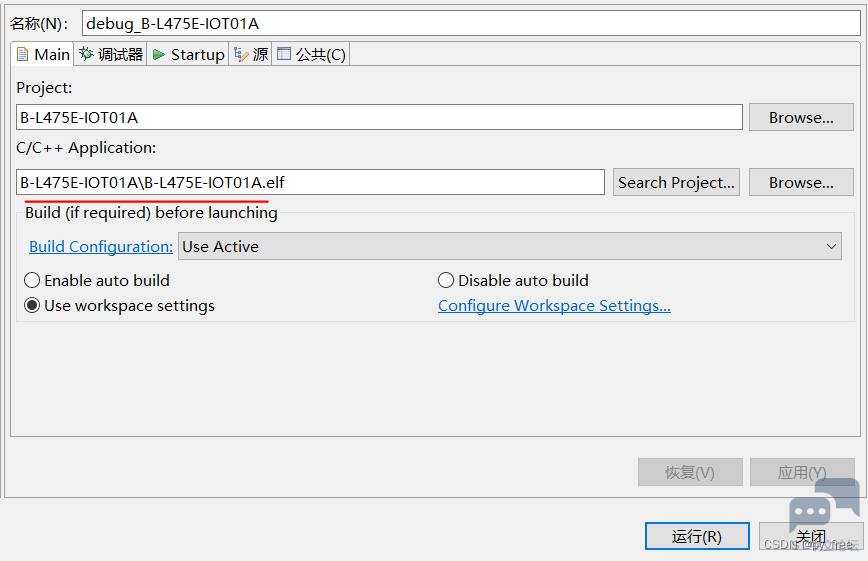

配置运行设置如下:

& ~2 f" X# E! K5 W* j

0 d8 }: K8 V& m" r ?

+ n, L% ~; ?, C) K, ]' g5 B

+ n, L% ~; ?, C) K, ]' g5 B

) k1 J6 ^% c7 }& T

然后编译及下载程序:

4 _ `( _5 b( J/ s5 b; T, B( f, I2 d$ M

1 g$ ^3 U4 |8 I% L* i3 F K

1 g$ ^3 U4 |8 I% L* i3 F K

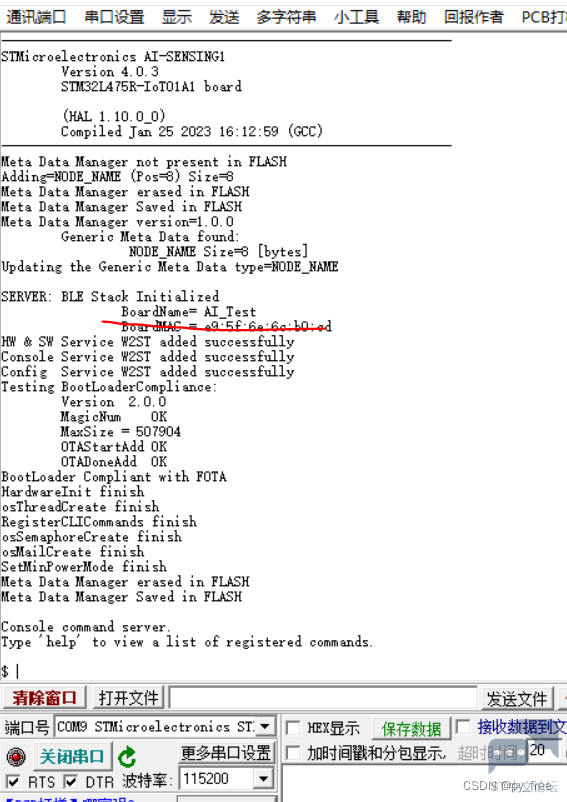

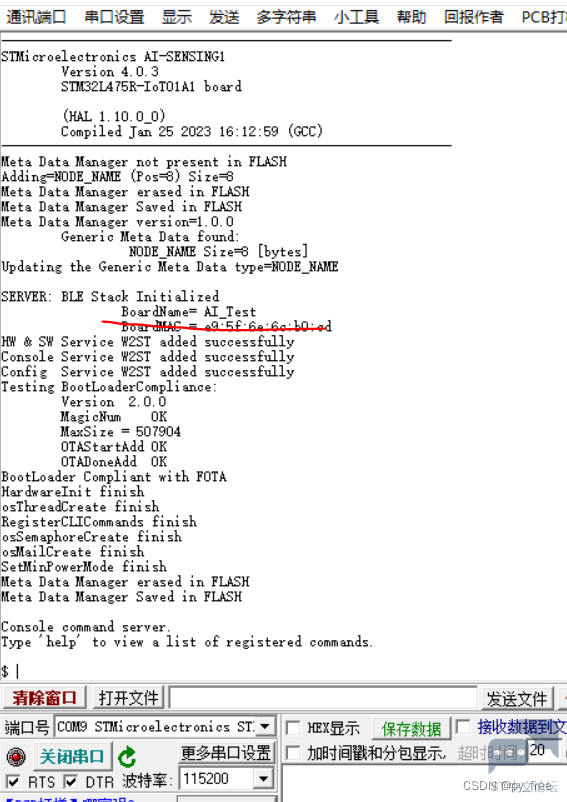

+ K# D+ [, X* V9 _ 打开串口工具,连接上对于串口,点击开发板上的重置按钮(黑色按钮),串口日志输出如下,日志显示BLE模块启动成功:9 G" F( d0 C9 W( }# E" Y

% }) s# F2 J' [5 I# ]1 b" B

+ C$ R2 Q- I! i% W1 v& ~* y# e! k) E; a0 |" L3 ^8 a

0 n" |& | t5 J7 N4 E

四、数据采集

& R, |' B4 B: A 4.1 STBLE-Sensor软件下载安装

( d3 ~ `8 C5 w' e+ k. e& q/ i 确保手机支持低功耗蓝牙通信,进入ST的BLE传感器应用下载页面,! A4 q; U8 N; @0 }7 ]2 \2 G

3 I) ^2 _) b3 k3 a+ F4 e

下载对应的手机应用程序:

) l* D+ [7 [- j+ G7 G$ S/ V' o8 w$ I/ R. l3 H7 @

7 J* r# q b' ~; o7 f

, {" k7 }2 {7 \4 r

3 U9 J; L7 V% S. k2 R* j3 d6 R 4.2 STBLESensor配置数据采集2 M$ Z! u& g( k8 e

本文用的是华为手机及android系统,安装完成APP后启动进入界面(当前版本是4.14),点击搜索,得到AI_Test蓝牙服务名。

7 @ N( d. {# h

' _/ m( c2 p% j Z! n

7 d! s3 c9 n9 V/ a7 f5 ?6 Y. c6 |6 V# h

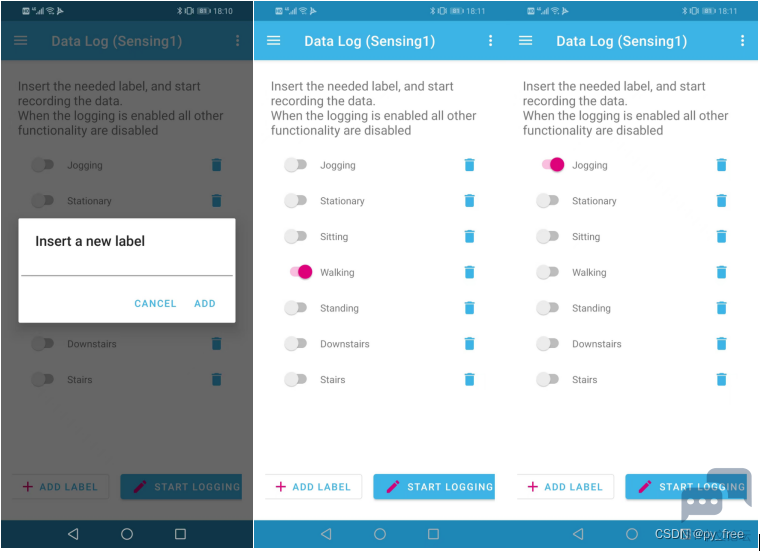

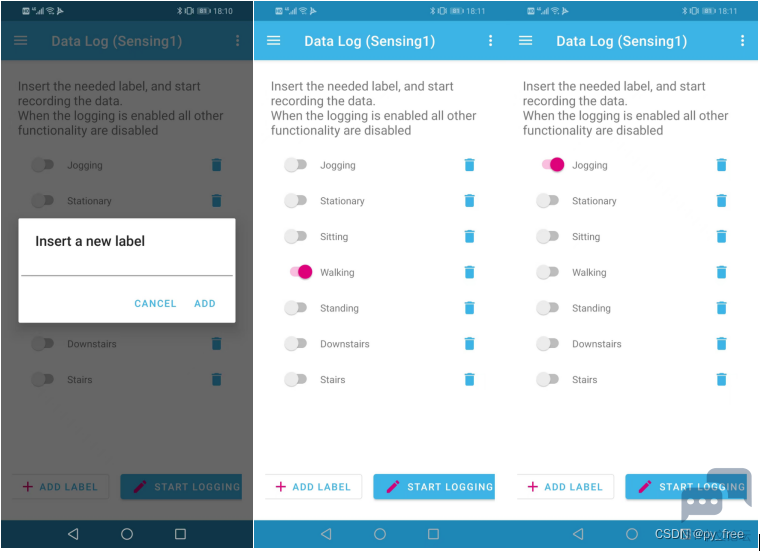

选择AI_Test蓝牙服务后,进入页面,(android)在左上角菜单下拉菜单选择,Data Log(sensing1),进入数据采集页面,选择Accelerometer(三轴加速度计),并设置参数为1.0Hz、26Hz、1.0X。

& q- E8 |$ U7 c0 B; P! g

. e, p, e* O! Z) v% ~6 _- V; Q

6 ^; ~$ P7 O/ t$ M9 r" x# Y' h, z

2 c) ~" y- @. m2 O) }, O

在数据记录操作页面,先新建标签,例如Jogging(慢跑),Walking(走了),Stationary(静立)等等。5 R; ^5 O9 d3 D. i$ ^3 B

1)开启数据采集记录时:先打开标签,再点击START LOGGING按钮开启

: h# s' g; ?8 q' m$ ~# R6 W 2)关闭数据采集记录时,先点击START LOGGING按钮关闭,再关闭标签。( q# R# h; U2 A. D q& U% \

8 M$ w5 p1 ?7 D# n

% y1 {1 H' e3 E/ E

% y1 {1 H' e3 E/ E

. X" P9 b+ x' m+ B/ e0 i! e$ K

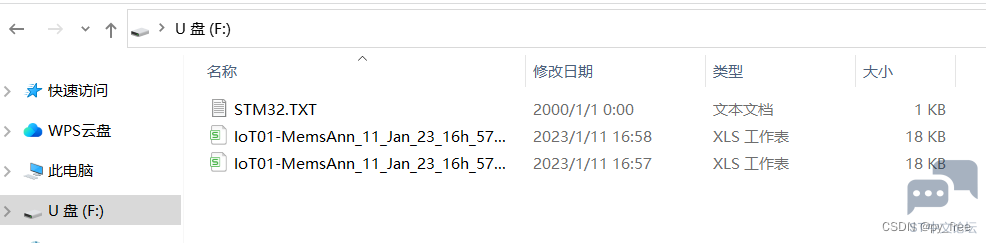

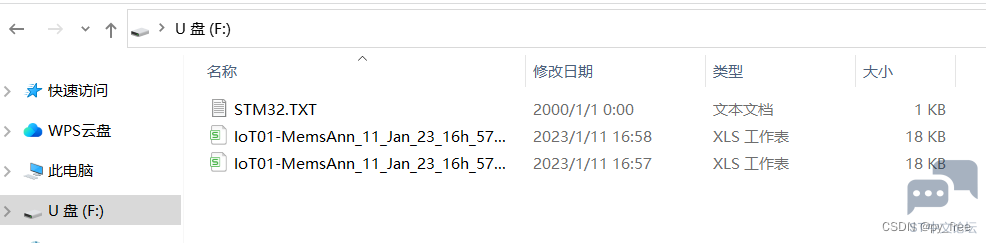

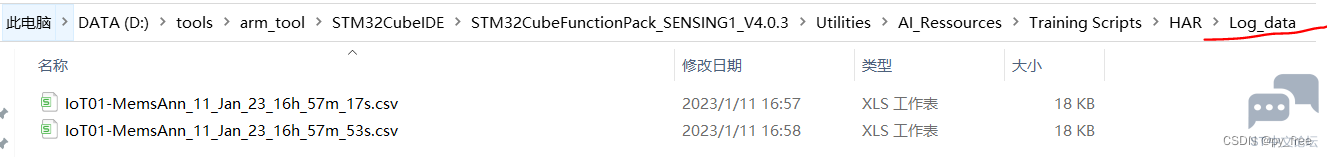

例如,本文按上述操作记录了Walking、Jogging两次数据记录,将生成两个.csv文件。. ^4 p2 Y1 ?6 h% c

, w4 t. \* Y7 R. X" w+ K, t& F. M1 z

五、数据治理及模型训练

4 m9 e }' I' a 5.1 从开发板取出采集记录数据文件

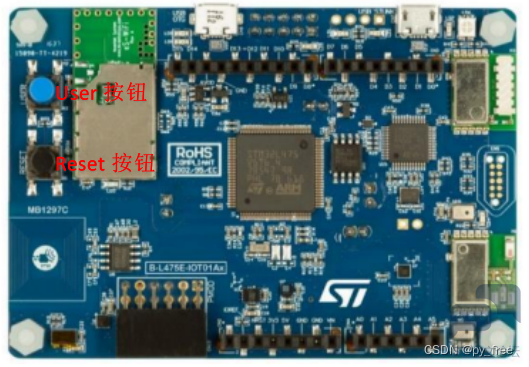

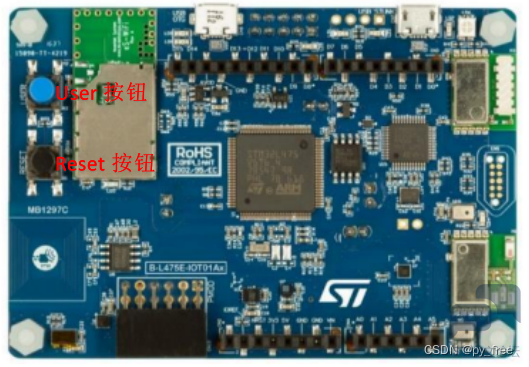

- Y2 P0 {1 I4 G3 j 断掉开发板与电脑的USB连接,在开发板背面将在1-2跳线帽拔掉,插入5-6跳线,然后USB连接从ST-LINK连接转到USB-OTG接口接线,如下图(1->2)。

. P; N' f) u S5 x; F0 U" v" c& z) u

) W e, E! E8 {! K) c& S1 [% E, d4 O

) W e, E! E8 {! K) c& S1 [% E, d4 O

+ y& D' d7 d X9 U, A$ ?3 r

开发板重新上电后,保持按下user按钮(蓝色),同时按下reset按钮(黑色),然后先松开reset按钮,在松开user按钮,激活USB-OTG。

% A, Y3 [7 r1 H$ i7 p

( O! o T4 m P1 H& P* P

$ `; e0 j3 J5 Z% J2 N3 B5 r

$ `; e0 j3 J5 Z% J2 N3 B5 r

7 M6 k* t9 S% z% `8 b

USB-OTG激活后,开发板将作为一个U盘显示在电脑上,里面有刚才数据采集保存的CSV文件。

' s& t! ] K- P3 W" \4 H1 t+ E& X" U4 M% @8 o

4 A0 k8 `7 k- v2 H

+ j: Q C- I- \+ y& K

2 E4 n* ^/ ~4 ? 在“STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR”目录创建一个文件目录Log_data,将该文件拷贝到该目录下:

1 Q& e; x. e' F8 \, Y7 v

! N9 c j; n( p1 A

( T( `7 l( }( U3 X; L+ ^

( T( `7 l( }( U3 X; L+ ^

1 I" U" Q& W7 a; B, d" C

+ r( h2 b* q* M

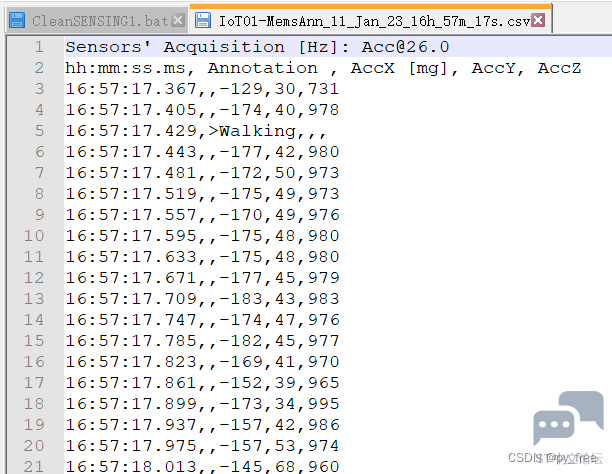

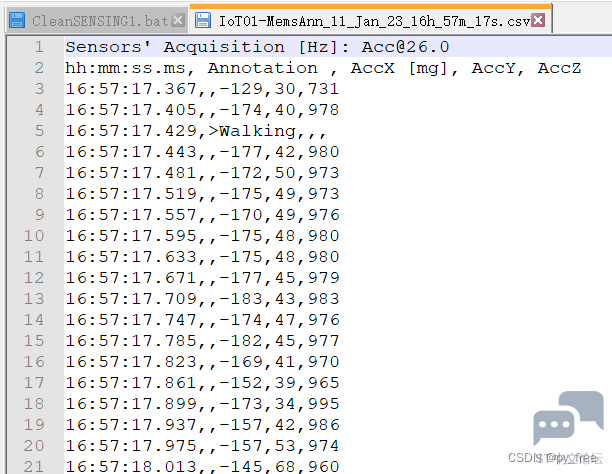

4 |& w/ l6 {2 N; |& t 该CSV记录数据格式如下,时间、行为、三个传感数值:4 \% E0 C5 ~; j0 ?- l

8 x8 o7 f! T' e# f% k

+ M4 _* A3 Y$ a/ t* {: O) O9 D3 |$ U' c. Z9 i

9 R) X' m" h% O8 S3 u. \ 5.2 神经网络模型训练

7 M' s' d4 s! D$ l% h “Training Scripts\HAR ”是官方提供的一个人类行为姿态识别训练项目,默认是采用,采用Keras前端+tensorflow后端实现。先安装tensorflow、Keras等支持。1 x# j) f- V# x

' T; ~: x! A8 Y6 q* U( c/ {

本文安装如下:

+ o- s8 I7 N: i/ s- #已安装python3.6; h# S& ` n) \' g7 q' e

- pip3 install tensorflow==1.14 -i

' I# L+ \- E/ m* i/ I3 E" `! \ - - e5 o! D* @& L

- ERROR: tensorboard 1.14.0 has requirement setuptools>=41.0.0, but you'll have setuptools 28.8.0 which is incompatible./ Y8 c8 u/ _1 i: \7 m

- python3 -m pip install --upgrade pip -i

9 Y9 U% i$ Z. r3 G" k - pip3 install keras==2.2.4 -i

根据HAR 项目的readme.txt通过pip install -r requirements.txt命令安装requirements.txt文件制定的相关模块,但本文是采用常用命令逐个安装各个模块的“pip3 install 模块名==版本 -i 源”( C2 k4 I8 B! {/ k9 p( x0 I: I7 J

- numpy==1.16.4" J% W; i7 u. L y2 u# `

- argparse" f- w+ Z9 ^/ Y' I

- os

- B2 f. d) C2 ?! J. e' ~, ] - logging

8 b0 {- S4 C5 v1 l3 H$ m5 u1 r) M - warnings# y# {3 x' |) W+ b7 U

- datetime

$ S* B* J$ @- E4 q7 T0 K - pandas==0.25.1

# k" }2 y1 S+ X3 E - scipy==1.3.1

0 S0 r- R$ L# _3 M/ B( }3 r: B - matplotlib==3.1.1

5 i# `; ^8 `8 n - mpl_toolkits

( ]: x( e$ P) W2 y6 ^1 T7 X6 n5 `" E - sklearn-learn==0.21.3

) a* C1 F0 X) r" v - keras==2.2.4

; b N' Q! Q: O3 V, V - tensorflow==1.14.0

) w! Q. Q) B: ?) V# t - tqdm==4.36.1

) U, A$ f- x6 {$ Y - keras-tqdm==2.0.1

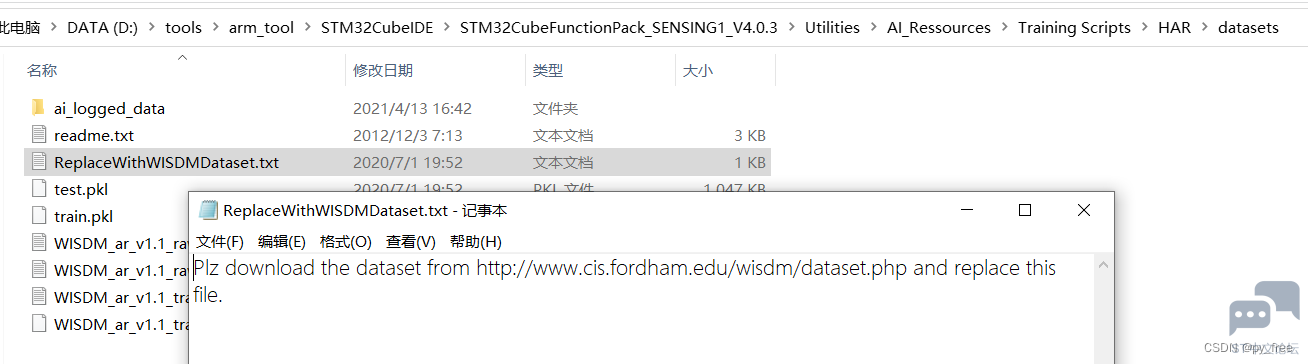

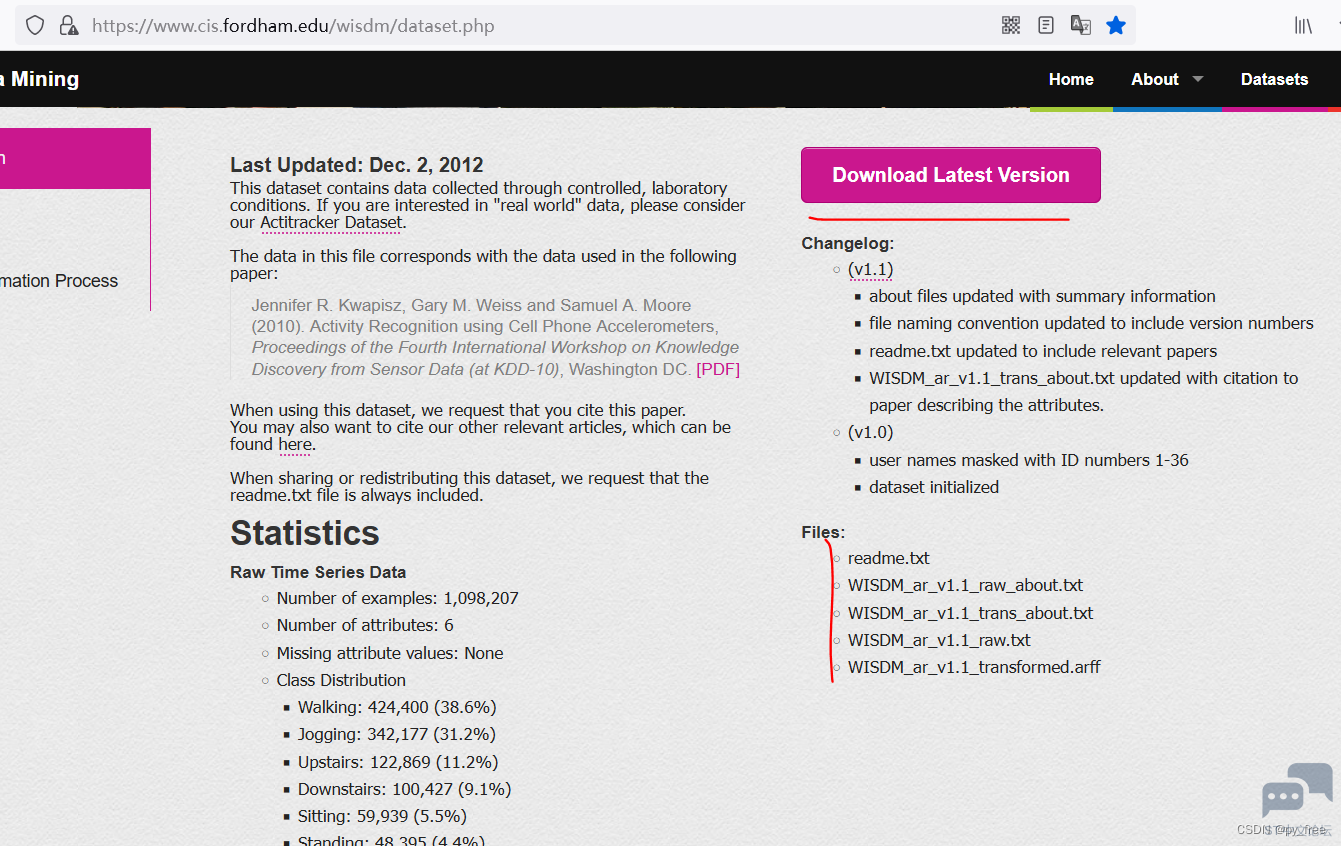

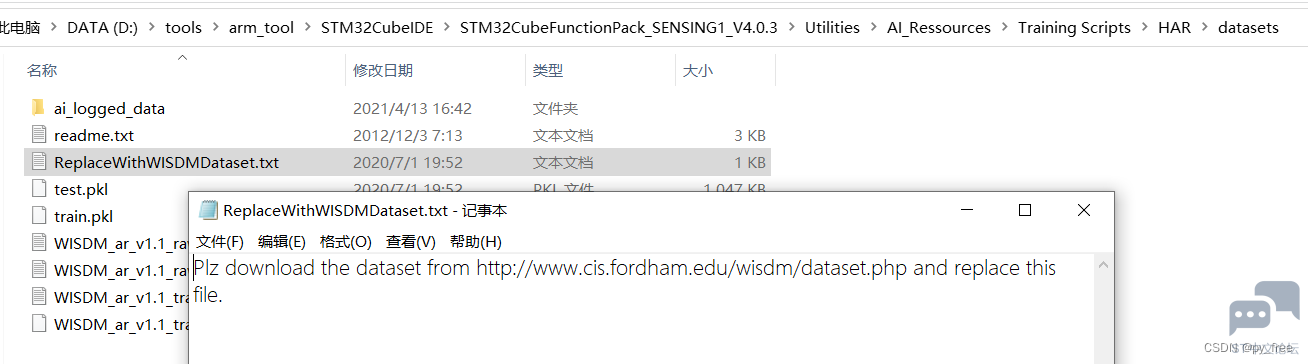

, S- z/ _) l/ H( v2 J 完成安装后,进入datasets目录,打开ReplaceWithWISDMDataset.txt文件,根据其提供的网址去下载

9 s! w/ ^, J; P" }1 Z" R- z$ l( p+ C% N3 p

" p4 [ H1 m/ O! V" i0 k

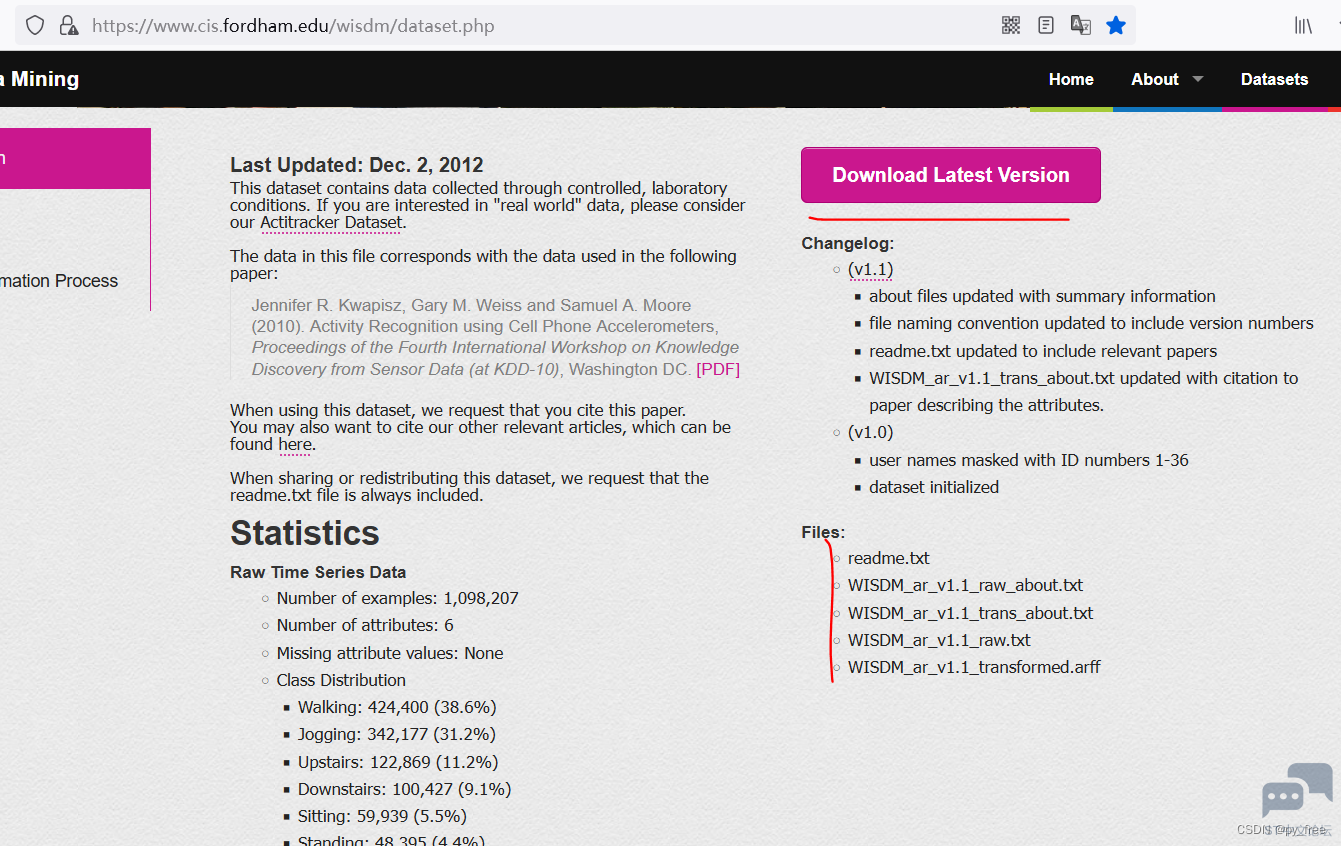

) u2 o, O( U7 M# ~& C 下载WISDM实验室的数据集支持。* A ]4 j" V- x3 a h+ h% d" k- s+ o4 x% @

' {: n$ E! w8 a$ ~# l

) H: k t! X- q2 z( d p( Q. S1 |

) H: k t! X- q2 z( d p( Q. S1 |

7 g, O" H9 e* ]+ F' I8 V. l

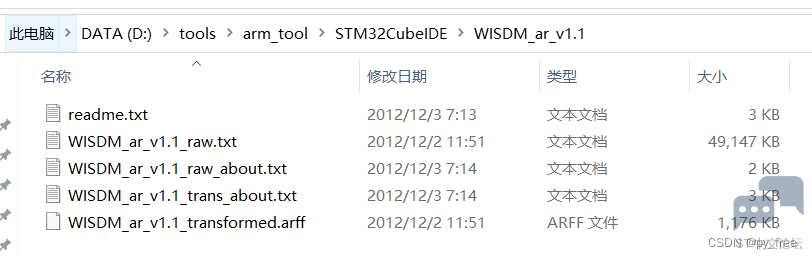

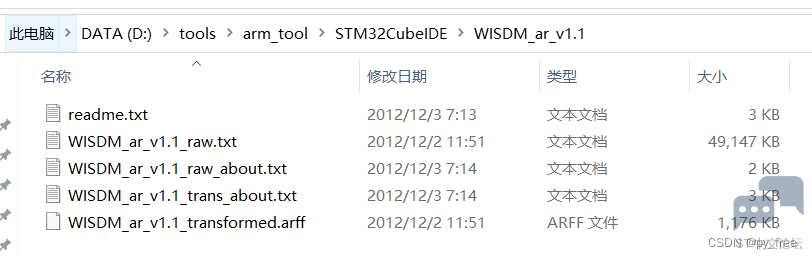

下载文件如下,将这些文件拷贝到datasets目录下覆盖。

% b X9 `4 Z3 @

$ a' O7 C+ ?* q7 f8 n- m8 v) b

6 y6 g& J. R/ G, ?1 E2 u+ T$ g# H4 {

6 y6 g& J. R/ G, ?1 E2 u+ T$ g# H4 {

3 ~) g5 V5 E+ k6 }! k

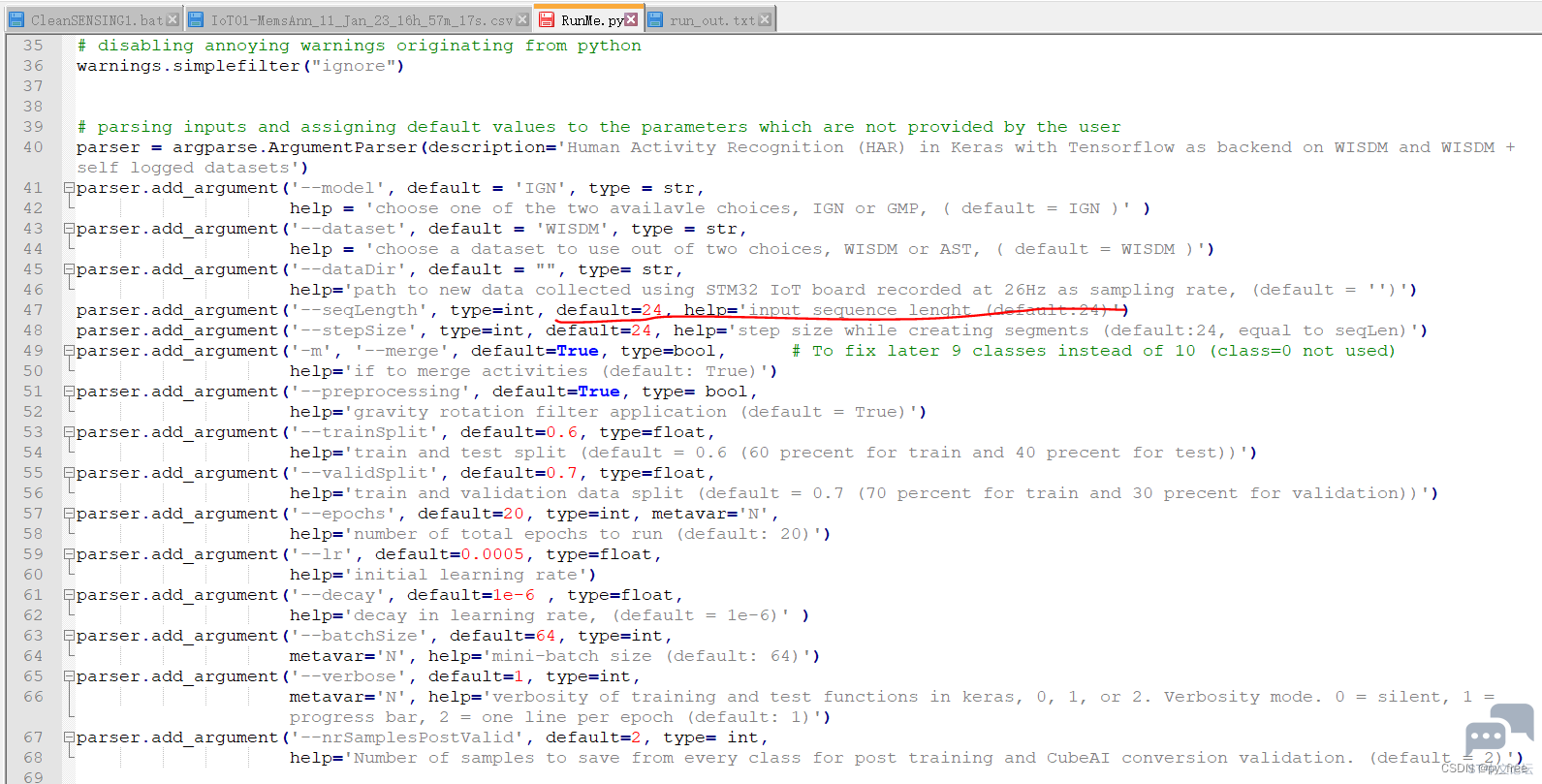

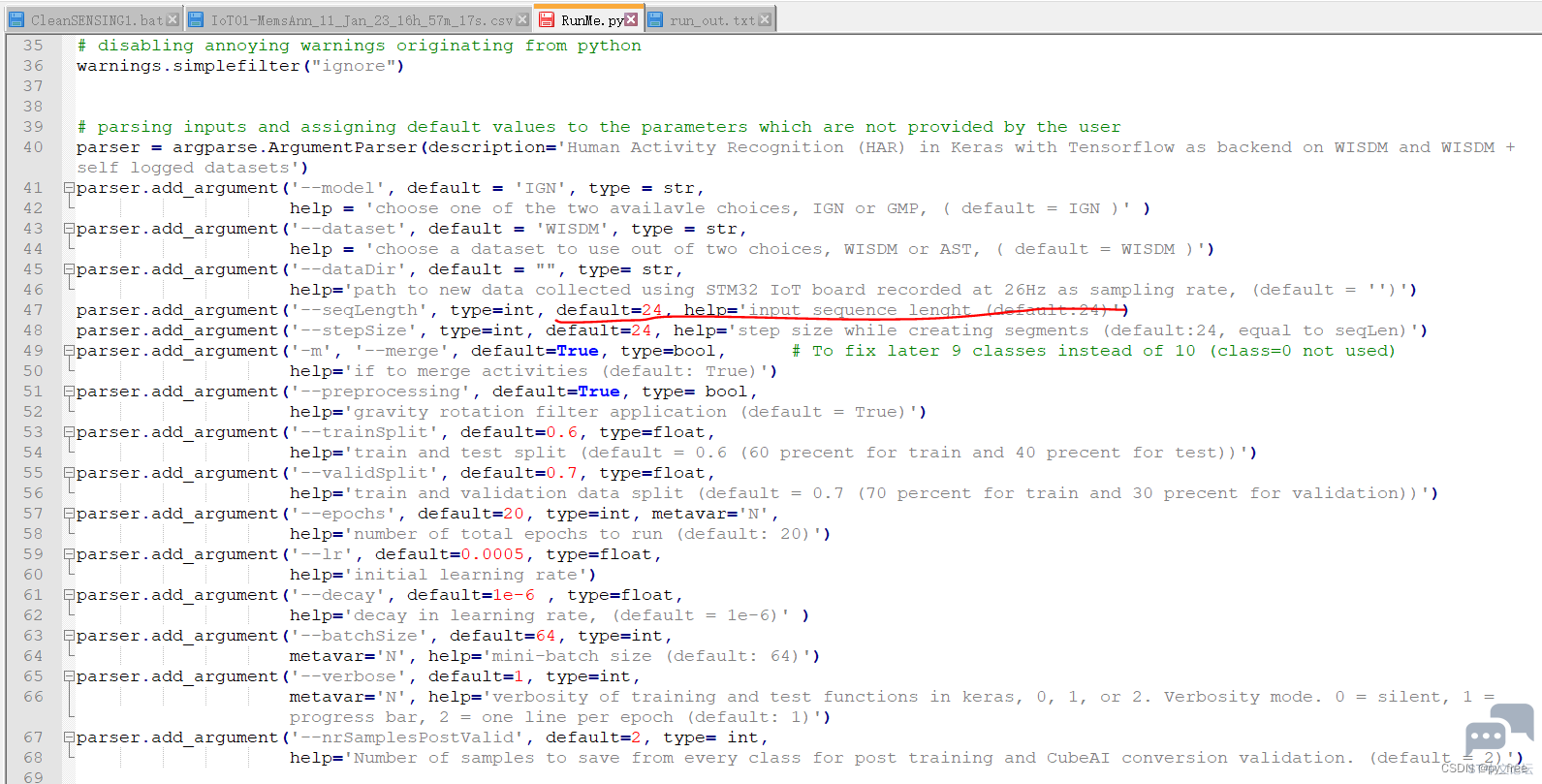

打开RunMe.py文件,可以看到关于各个运行参数的设置:3 ~2 [" s2 ? d

1 f, C3 k0 D9 ?/ f

8 ~8 o- b9 w) z8 O; z8 u

/ F" \+ r* A/ x1 [* p# N 运行python3 .\RunMe.py -h命令,查看运行参数含义,其中:--dataset使用的是前面下载的WISDM实验室的数据集来训练模型,而--dataDir是指定采用自行采集的数据集训练模型:2 h, i5 b! z& L) q

- PS D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR> python3 .\RunMe.py -h+ _6 b6 N5 L" I$ [7 q5 ^8 V" M! Q

- Using TensorFlow backend.

) N$ a9 {& h' E2 |1 h# Q4 L/ S - usage: RunMe.py [-h] [--model MODEL] [--dataset DATASET] [--dataDir DATADIR]7 `0 ~2 H( c4 s8 _( ~4 U0 z

- [--seqLength SEQLENGTH] [--stepSize STEPSIZE] [-m MERGE]6 q/ I5 N( P Z* B7 {" h

- [--preprocessing PREPROCESSING] [--trainSplit TRAINSPLIT]

6 U& f" h. q0 G - [--validSplit VALIDSPLIT] [--epochs N] [--lr LR]) V" A- c0 D5 g, R7 e! P+ y

- [--decay DECAY] [--batchSize N] [--verbose N]6 v: z4 ^6 A. W) f4 n

- [--nrSamplesPostValid NRSAMPLESPOSTVALID]* F3 F4 ^# x8 W1 k$ d1 K/ Z" j

-

. h9 Y+ R) }* [' d5 T$ F; ? - Human Activity Recognition (HAR) in Keras with Tensorflow as backend on WISDM" D2 W5 _3 M6 M' O- M

- and WISDM + self logged datasets

7 O: u4 f( b; L; V - & ~3 h$ i/ B, k/ k H- n/ v

- optional arguments:

& d9 X9 p& F5 _* g6 Z2 W; ^ - -h, --help show this help message and exit

$ l3 X7 c, }9 O - --model MODEL choose one of the two availavle choices, IGN or GMP, (

8 M: w5 B+ _) J1 _% z# E X - default = IGN )# \8 ?8 i6 Q# H2 v! O o, ?

- --dataset DATASET choose a dataset to use out of two choices, WISDM or

5 H; F) B! |: ]; g) u# V T% L - AST, ( default = WISDM )* g0 ]2 l3 _: J$ Z+ Z9 k

- --dataDir DATADIR path to new data collected using STM32 IoT board9 W5 }% |* L, K& j

- recorded at 26Hz as sampling rate, (default = )' [& m& z5 `: F# {

- --seqLength SEQLENGTH

6 Q3 j' x% ^# P" {6 ~ ]9 N# l# ^ - input sequence lenght (default:24)# b0 X' P: x5 ]% x2 h9 u

- --stepSize STEPSIZE step size while creating segments (default:24, equal

9 V" Y: w8 E; M! g$ W - to seqLen)

+ w9 r; c2 G" F6 o! X8 Z' b - -m MERGE, --merge MERGE# H% w: W, ?+ n/ u9 p

- if to merge activities (default: True)7 O& N Q! Y# ]8 s1 R7 t

- --preprocessing PREPROCESSING. C0 z1 L# B' l" {7 G) W* Y4 q, ?

- gravity rotation filter application (default = True)6 g: z3 i, l7 C% K, V8 z3 E

- --trainSplit TRAINSPLIT3 u' Z- T4 R, D4 E: V6 |2 |

- train and test split (default = 0.6 (60 precent for

7 I2 R6 J7 q. H8 ]0 o; N - train and 40 precent for test))

, s9 I- p6 y L9 J; d! T) `+ ^4 l1 F - --validSplit VALIDSPLIT% S4 s$ f8 s$ e' l- o

- train and validation data split (default = 0.7 (70- t6 ], F2 L/ E( Y

- percent for train and 30 precent for validation))

9 [" G5 r( G9 ?$ W - --epochs N number of total epochs to run (default: 20)" d; v; I8 A8 B) o* C

- --lr LR initial learning rate

8 C' Z" N3 j% ~/ Z U - --decay DECAY decay in learning rate, (default = 1e-6)

^8 O; {. p8 ~& M; |/ n& e - --batchSize N mini-batch size (default: 64): C6 V" o. G9 C

- --verbose N verbosity of training and test functions in keras, 0,

& F# p9 O* ]4 X( R% M - 1, or 2. Verbosity mode. 0 = silent, 1 = progress bar,2 P3 |# j5 T, i) u, c0 X+ k o

- 2 = one line per epoch (default: 1)( u& _0 ?, A! ~" t; {( B+ j

- --nrSamplesPostValid NRSAMPLESPOSTVALID- U5 [/ H$ K6 F6 n* [: `

- Number of samples to save from every class for post

+ N( o3 P5 |/ P- M" U! o* W2 _8 R' F* G - training and CubeAI conversion validation. (default =. t+ c: _# u- z

- 2)' s3 o- C% V2 f

- PS D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR>

6 U0 y! _8 l/ u 在RunMe.py文件后面加入下面语句:" K* {% b5 K& H: A; P

- #保存Cube.AI支持的数据集格式,用于后续验证测试使用

8 _) F1 B* c. G* X" K: b# F - testx_f=resultDirName+"testx.npy"7 A9 J8 V0 Q# P; Y0 S4 F

- testy_f=resultDirName+"testy.npy"! J% C! g( E( a9 B

- $ s$ h& U0 l* r/ T- C* r

- np.save(testx_f,TestX)0 p5 S% v. T( u* T' k8 ?0 p9 f

- np.save(testy_f,TestY)

打开命令工具,输入命令python3 .\RunMe.py --dataDir=Log_data ,可以根据实际需要进行参数设置,本文先采用默认参数训练模型,输出日志如下,这显然是一个分类问题,分类为Jogging 、Stationary 、Stairs 、Walking,有卷积层、池化层、2全连接层、压平层、Dropout层等。

6 P3 c6 [/ Y% `# V* X- {- PS D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR> python3 .\RunMe.py --dataDir=Log_data

, K. y# `+ s4 D# X+ e/ U - Using TensorFlow backend.- d G5 E- Q+ r' U; h, I1 L

- Running HAR on WISDM dataset, with following variables* [9 v' f I, J; {! }

- merge = True5 H0 b2 K0 ~0 o: ?+ r; U4 |

- modelName = IGN,

" [$ s2 c5 i6 O/ D - segmentLength = 24) p( _; G1 j) V# v

- stepSize = 24

) g8 E; A/ j/ W$ g5 L9 o - preprocessing = True# m. f/ o0 D" k0 D( l8 F

- trainTestSplit = 0.6

" {( J" q1 O) Y1 ?7 u - trainValidationSplit = 0.7

; m. I' a$ ^; P, L6 [- f - nEpochs = 20% b. V* W* j# s( C/ S* F! d- X, l

- learningRate = 0.0005, i' e3 u7 r2 Q7 T f0 i9 w! Z2 K/ R7 i

- decay =1e-06/ o' ~" r' E' a% c5 Q

- batchSize = 644 `; }) B5 W3 h

- verbosity = 1 J6 z/ R, M: I" H

- dataDir = Log_data

; ^* }( w, D( J! z3 x2 N - nrSamplesPostValid = 29 U& w( ^/ B% K0 V- t

- Segmenting Train data+ X. J& G! @: I, r# K; E) Q

- Segments built : 100%|███████████████████████████████████████████████████| 27456/27456 [00:28<00:00, 953.24 segments/s]

$ f& O6 D5 F. G - Segmenting Test data* Z% }+ u# i* j

- Segments built : 100%|██████████████████████████████████████████████████| 18304/18304 [00:14<00:00, 1282.96 segments/s]1 n5 n$ n% t% X) ?

- Segmentation finished!

( }: m- o( N+ v. z - preparing data file from all the files in directory Log_data5 L C, Q2 j9 w ~3 y! k

- parsing data from IoT01-MemsAnn_11_Jan_23_16h_57m_17s.csv) W! Z$ ?5 u7 k. C

- parsing data from IoT01-MemsAnn_11_Jan_23_16h_57m_53s.csv# V r: O. p r* o

- Segmenting the AI logged Train data

- p, [$ z+ F3 X4 O; f* K' N - Segments built : 100%|████████████████████████████████████████████████████████| 25/25 [00:00<00:00, 3133.35 segments/s]& Z. }. R, \' `- V0 s8 J$ x

- Segmenting the AI logged Test data8 l1 I q& T. s! j

- Segments built : 100%|████████████████████████████████████████████████████████| 17/17 [00:00<00:00, 2852.35 segments/s]3 S$ B1 M* B3 C$ c

- Segmentation finished!3 D9 }" ?3 i, d& C. g0 z

- _________________________________________________________________- W+ m6 K* y( Q0 y* x# b9 O5 [* c' ?

- Layer (type) Output Shape Param #

g5 N* L# E$ J- c2 I$ o - =================================================================" o; k5 `' S7 P) l/ \5 V

- conv2d_1 (Conv2D) (None, 9, 3, 24) 408

$ l1 W6 J* [- f. K0 U" O2 B - _________________________________________________________________

9 O6 o# N! c: _4 |3 O1 r% k - max_pooling2d_1 (MaxPooling2 (None, 3, 3, 24) 0

, X; A$ Q. ?+ \' f- X. M - _________________________________________________________________% \: Q, w9 l5 `- b

- flatten_1 (Flatten) (None, 216) 0

/ n/ ?4 J# q8 P2 w' j' N - _________________________________________________________________0 j: L4 G' M8 M, F2 F6 \* D( }# z

- dense_1 (Dense) (None, 12) 2604/ I7 E% l7 j8 f6 F6 i7 ^+ h

- _________________________________________________________________6 C# ]& y+ V8 [$ I* H" }9 R# V

- dropout_1 (Dropout) (None, 12) 0

/ {0 z3 p; O3 A3 f; x - _________________________________________________________________7 M5 ]3 T+ N5 @) y

- dense_2 (Dense) (None, 4) 52

7 i; Q0 s8 ~) @: [ - ================================================================= g7 x3 A4 m* W/ k2 q6 }6 k

- Total params: 3,064

: [- Q* V4 [( D9 u$ u4 L9 E8 G - Trainable params: 3,064

9 w7 W5 k) N' t. h - Non-trainable params: 0

2 E. C' W$ ?8 E1 } - _________________________________________________________________

/ S& v7 L; i( t% @- h( H3 {: ]7 D" s - Train on 19263 samples, validate on 8216 samples

# {; i" C; n0 X3 T1 I! @8 j9 R- ` - Epoch 1/20: g7 K7 A0 g' W, q" b K$ V* [8 C

- 2023-01-24 14:41:03.484083: I tensorflow/core/platform/cpu_feature_guard.cc:142] Your CPU supports instructions that this TensorFlow binary was not compiled to use: AVX2

$ ~2 I# g' b W' u& W% T - 19263/19263 [==============================] - 3s 167us/step - loss: 1.1442 - acc: 0.5430 - val_loss: 0.6674 - val_acc: 0.7372

5 h2 t k0 c' |' l - Epoch 2/20& P. V$ b t4 L8 F4 q o# \1 b" D- b

- 19263/19263 [==============================] - 1s 40us/step - loss: 0.7173 - acc: 0.7089 - val_loss: 0.5126 - val_acc: 0.7928

. |# j4 T8 H+ S - Epoch 3/20: C5 C, q/ b* _

- 19263/19263 [==============================] - 1s 40us/step - loss: 0.5954 - acc: 0.7522 - val_loss: 0.4470 - val_acc: 0.8051+ K9 ~6 [+ L" o/ Z' D

- Epoch 4/20

1 o* s( K; D8 @# Y& g - 19263/19263 [==============================] - 1s 39us/step - loss: 0.5288 - acc: 0.7810 - val_loss: 0.4174 - val_acc: 0.8335$ l% y- q0 Q, K3 Q* C s3 a( b, ]

- Epoch 5/20; P' o" {- _& h, k/ v# }

- 19263/19263 [==============================] - 1s 36us/step - loss: 0.4925 - acc: 0.7994 - val_loss: 0.3897 - val_acc: 0.8477/ W* U" B" i6 o3 P

- Epoch 6/20! P. I- `5 i- D

- 19263/19263 [==============================] - 1s 35us/step - loss: 0.4647 - acc: 0.8173 - val_loss: 0.3607 - val_acc: 0.8647

, o- ]! F* R4 y t( F. E) f - Epoch 7/200 U" r6 P( ]) K9 u7 ~3 e2 T1 J! N% Y

- 19263/19263 [==============================] - 1s 37us/step - loss: 0.4404 - acc: 0.8301 - val_loss: 0.3493 - val_acc: 0.87771 L* x$ }7 {& i, Y2 [! v+ }( `: r- Q

- Epoch 8/20

) i0 E5 T7 a" X - 19263/19263 [==============================] - 1s 38us/step - loss: 0.4200 - acc: 0.8419 - val_loss: 0.3271 - val_acc: 0.8827

- z* F/ c- C; a9 x4 m( O9 G8 v$ t - Epoch 9/20+ R* P8 u* m8 C* M+ s8 } N

- 19263/19263 [==============================] - 1s 38us/step - loss: 0.3992 - acc: 0.8537 - val_loss: 0.3163 - val_acc: 0.8890: ~ p) g2 k- B3 H3 Z9 r

- Epoch 10/20

; A' |2 J1 |; ^: E P, ?( r! ]- A - 19263/19263 [==============================] - 1s 40us/step - loss: 0.3878 - acc: 0.8576 - val_loss: 0.3039 - val_acc: 0.8991

9 l) M% G. a2 y5 @( J( \ - Epoch 11/20

9 n6 h) ]2 f, F; B2 J g: \ - 19263/19263 [==============================] - 1s 40us/step - loss: 0.3799 - acc: 0.8667 - val_loss: 0.2983 - val_acc: 0.8985) s1 q. F' H9 ~7 G7 B: L; ]

- Epoch 12/20

1 T5 `3 B& Q% [ - 19263/19263 [==============================] - 1s 40us/step - loss: 0.3662 - acc: 0.8736 - val_loss: 0.2922 - val_acc: 0.9007

& z5 ?. f3 d3 ^1 R: \ O - Epoch 13/20

9 a" n9 c0 O2 @" D% H8 @ - 19263/19263 [==============================] - 1s 36us/step - loss: 0.3613 - acc: 0.8760 - val_loss: 0.2837 - val_acc: 0.9051/ p0 m1 M& y4 O' S, w0 g

- Epoch 14/20' i( a; u$ c: N$ h+ z) A: P

- 19263/19263 [==============================] - 1s 40us/step - loss: 0.3574 - acc: 0.8775 - val_loss: 0.2910 - val_acc: 0.89853 G) d; |) _0 I u! q

- Epoch 15/20

% y! A- L. F$ F7 I% }4 k - 19263/19263 [==============================] - 1s 39us/step - loss: 0.3513 - acc: 0.8796 - val_loss: 0.2814 - val_acc: 0.9080+ _4 `! P- ]7 R( O5 h5 M6 J

- Epoch 16/208 E4 u. \3 [( E& X0 r

- 19263/19263 [==============================] - 1s 38us/step - loss: 0.3482 - acc: 0.8816 - val_loss: 0.2737 - val_acc: 0.9116, S, K& |: G. T8 r X6 e

- Epoch 17/20" M }" Q; I4 a2 ~! }2 C' D

- 19263/19263 [==============================] - 1s 35us/step - loss: 0.3362 - acc: 0.8875 - val_loss: 0.2742 - val_acc: 0.9114" D- W* F: q( f

- Epoch 18/207 x) J' x o7 L) `' x, r8 P8 Y9 U

- 19263/19263 [==============================] - 1s 38us/step - loss: 0.3325 - acc: 0.8892 - val_loss: 0.2661 - val_acc: 0.9137: F8 Z1 c. k4 e

- Epoch 19/202 ?: x( x8 M) D0 ^* o! R# Y

- 19263/19263 [==============================] - 1s 40us/step - loss: 0.3257 - acc: 0.8927 - val_loss: 0.2621 - val_acc: 0.9161$ v3 ] L, V$ m

- Epoch 20/202 P: y; D, |6 F8 U* C' e* |+ O

- 19263/19263 [==============================] - 1s 37us/step - loss: 0.3249 - acc: 0.8918 - val_loss: 0.2613 - val_acc: 0.9188

1 l9 }: h1 W& L! t* U9 g* V) Z) q - 12806/12806 [==============================] - 0s 25us/step

' `: e( X* Z/ p+ H - Accuracy for each class is given below.

1 Z2 c0 _& s- e1 M* y1 n& { - Jogging : 97.28 %

0 a8 u8 Z% f9 G - Stationary : 98.77 % u3 a! ^ i, _& C

- Stairs : 66.33 %

8 |% X& w/ o9 C4 V# K$ N- Q) A - Walking : 87.49 %* z' u0 y3 x) M

- PS D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR>

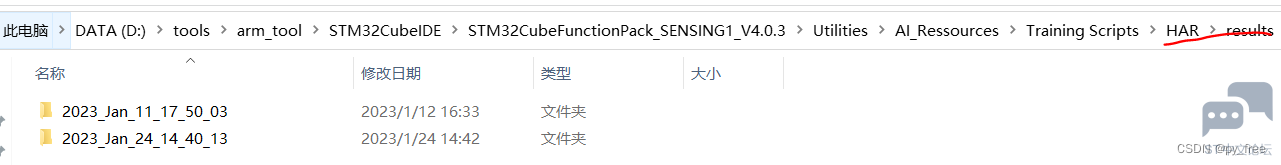

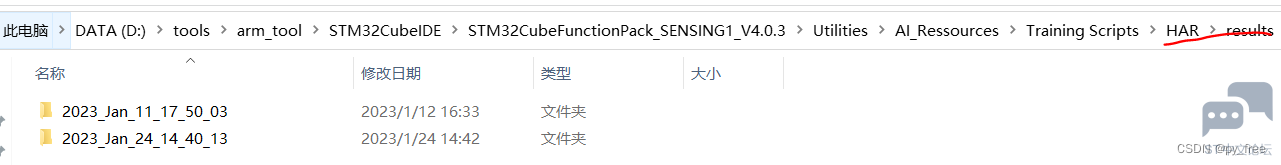

) f# m9 e! G0 Y% @8 Z 训练模型及相关输出信息在results目录下,每次训练输出依据时间生成一个独立目录,由于是keras训练模型,因此输出训练模型是一个名为*.h5格式文件,例如har_IGN.h5:1 i& Y4 _3 g$ c) @ z' I* B

2 r, g% D% x0 M/ N. b6 O- k, `9 y( R) W: w

6 z3 G- m7 Y9 u9 l1 o5 o

7 G" x; \/ s h7 y# n4 ~0 X' `2 W8 y

! I5 s2 X* t$ @! D9 |% `. d5 d. V/ g

! I5 s2 X* t$ @! D9 |% `. d5 d. V/ g

+ Z$ D6 T' d# N( @* F7 R8 A

六、 cube.AI将训练模型转换为c语言模型

9 c7 t9 f2 ?; M$ B. E5 C4 k& ^ 6.1 创建cube.AI支持的STM32工程

7 D6 K: p% I9 J+ o2 d6 e 在CubeIDE中新建一个STM32项目,在cubeMX中选择以开发板形式创建

# L6 M9 T: @4 ]2 s" S$ k

Z2 w* O7 M4 I" i

! y; u- |8 @% l' v& U

! y; u- |8 @% l' v& U

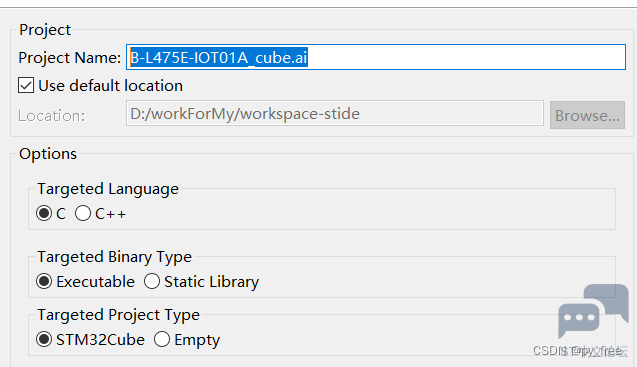

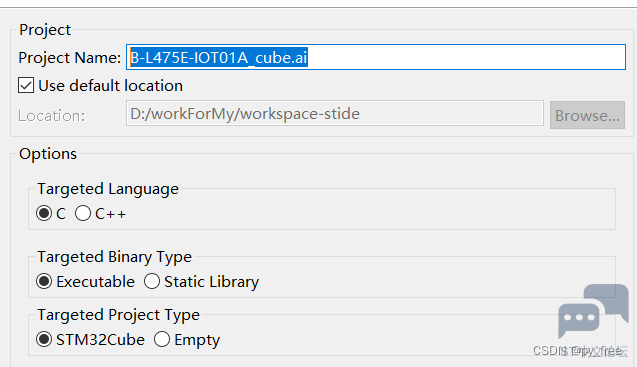

9 b* m5 B7 T3 t/ ~* [ 创建一个B-L475E-IOT01A_cube.ai工程名的STM32工程,如下图。

( A) b3 N5 x2 |8 ?

1 x2 T% y' Y, J1 U9 ^

7 }- L/ J# I/ n2 o9 `. E6 b5 _/ @

7 }- L/ J# I/ n2 o9 `. E6 b5 _/ @

1 ^) O) e: v) P+ O& j

完成创建后,双击.ioc文件打开cube.MX配置界面。( J3 V& H0 p5 @; T! `% O& ~

2 b: E# {( u9 U$ f8 W* n

/ r6 H$ J( ~' T; E- C# s; C P% W7 I; _* B. G9 e7 H% D0 h2 j

8 g! ]0 v' _7 p& f

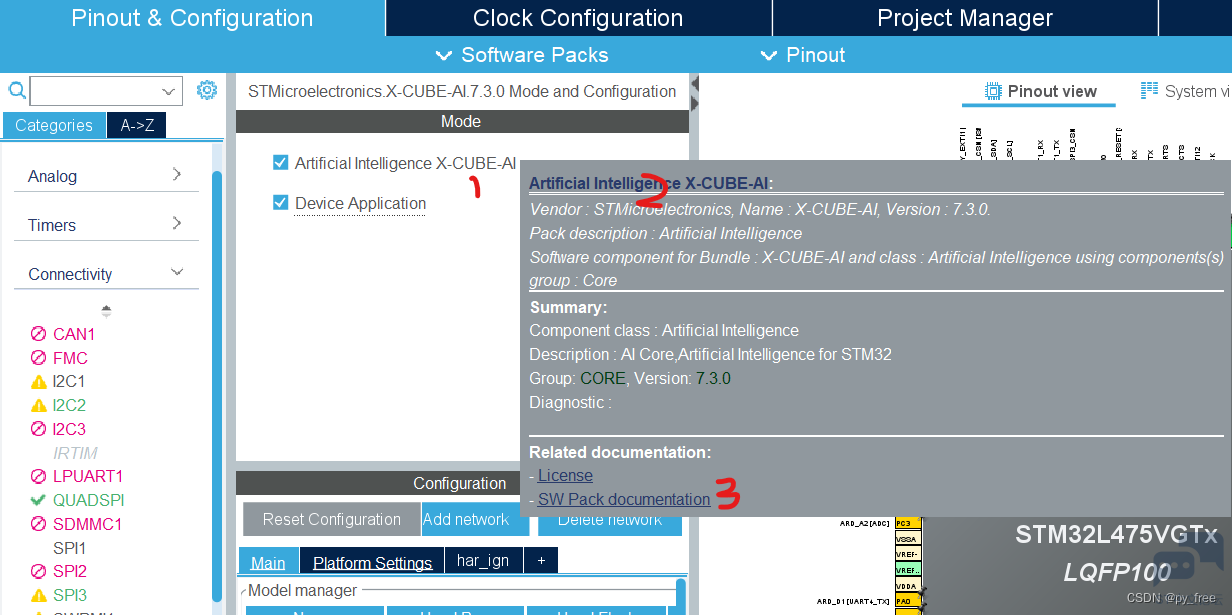

6.2 cube.AI神经网络配置- m6 J! S7 H" `, ?

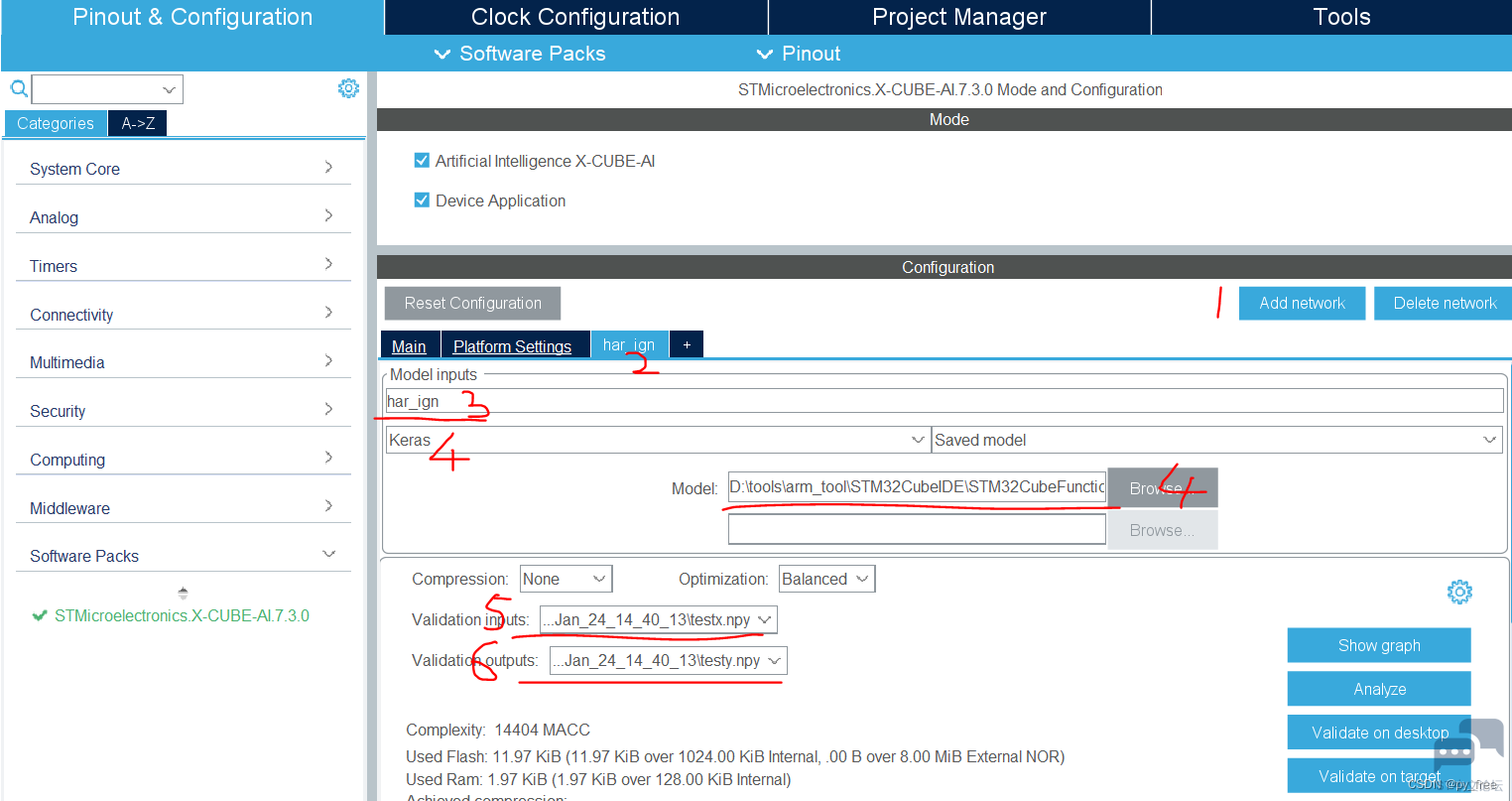

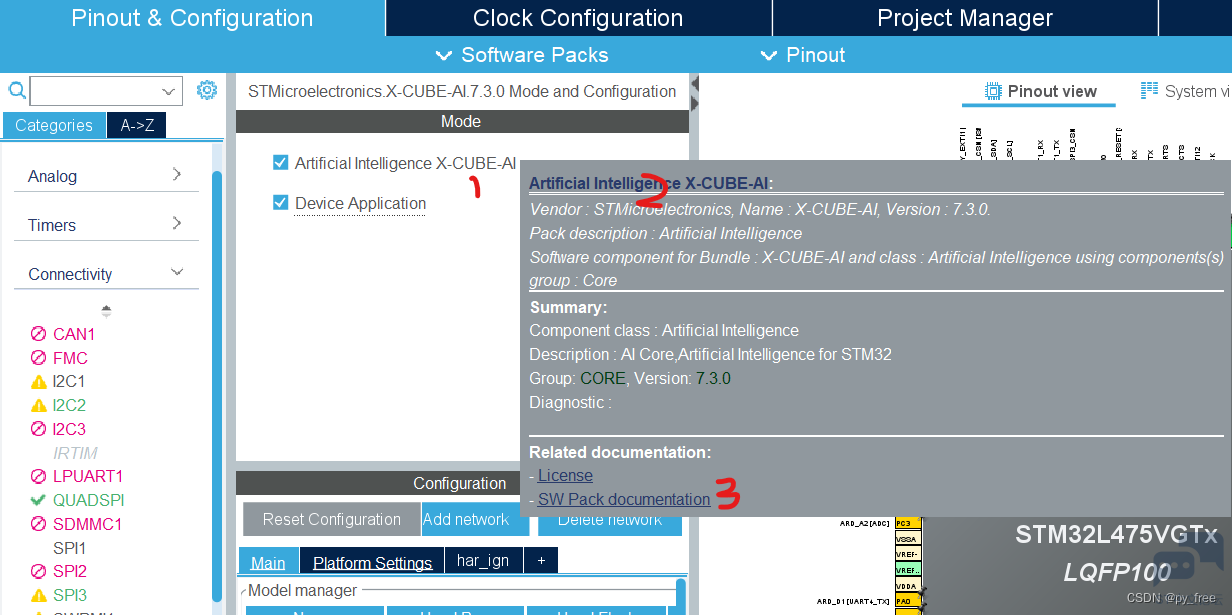

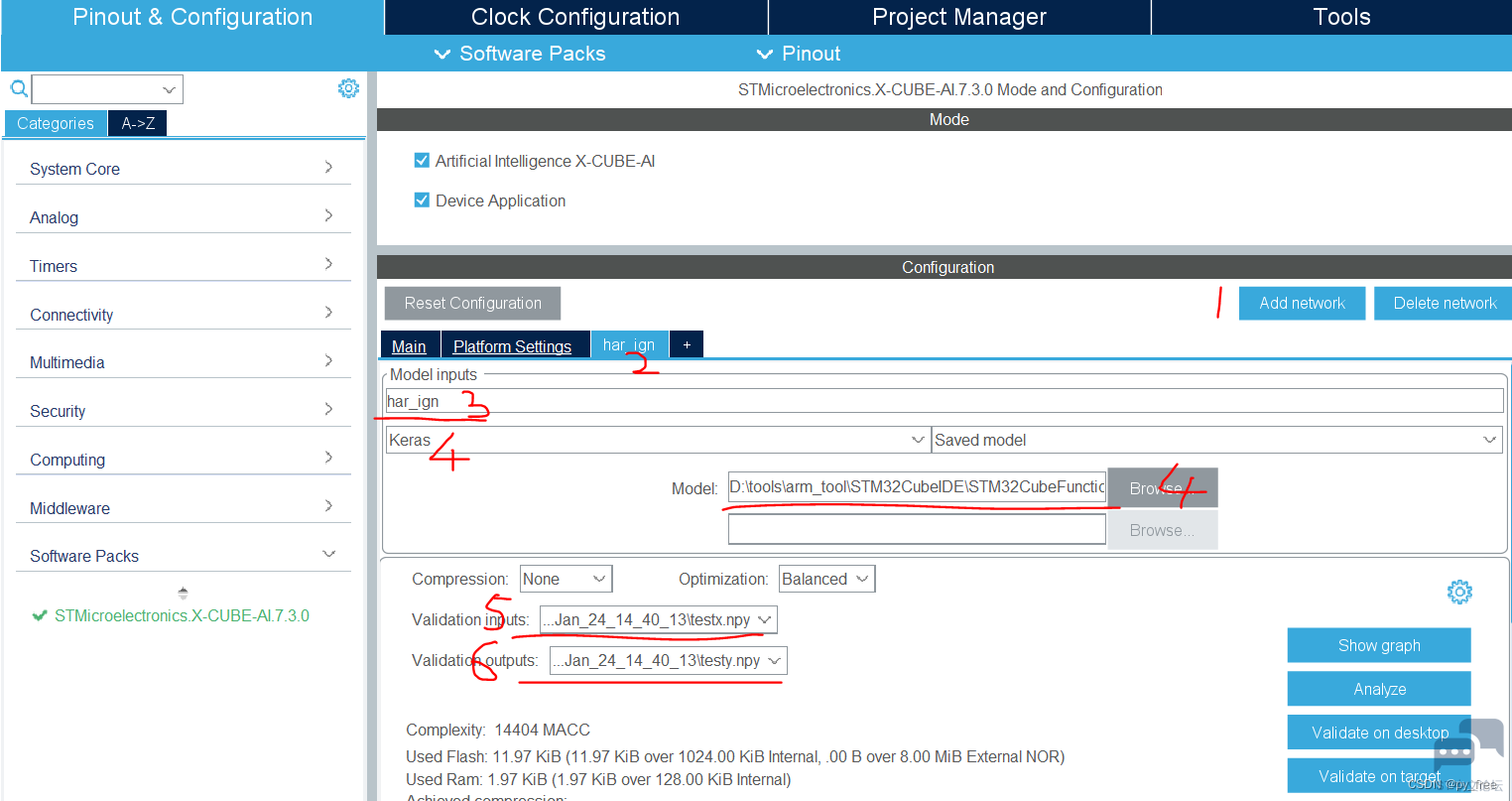

选择X-CUBE-AI包支持,回到主页面后,会多出software Packs栏及多出STMicroelectronics .X-CUBE-AI选项,进入该页面,勾选下图标识的2、3 项,在5中选择采用哪个串口支持程序及调试。- B4 R/ e7 g, I

1 f. f9 W$ k6 k. @. o9 g) h5 w/ c

8 W: ? Y" x8 b1 X1 V) S

8 W: ? Y" x8 b1 X1 V) S

1 O* P3 ~) m% H! ` 知识点,在X-CUBE-AI配置选项页面,停靠时,会出现说明框,快捷键“CTRL+D”会进一步出现X-CUBE-AI相关文档,

% O2 ^2 g( s, @( e

' ^" C8 v8 a$ d' j1 A: J

' ]3 ~3 U: D* c0 \: [6 l7 O0 ~. w, `: I6 Q

有详细的文档资料:

3 Z" Y$ a. ?4 z6 E- `

' z* n# i' @$ n7 |" F% Z9 t3 n, u

9 ]% d- @9 l7 ]5 b* ]

9 ]% d- @9 l7 ]5 b* ]

; B& M8 _3 m( j' O" b6 ^$ ? 或者也可以从cube.AI安装目录直接进入,例如:D:\workForSoftware\STM32CubeMX\Repository\Packs\STMicroelectronics\X-CUBE-AI\7.3.0\Documentation0 V+ p0 h6 l5 K' i" J F7 s

2 j' w8 a- F& B4 p% ]

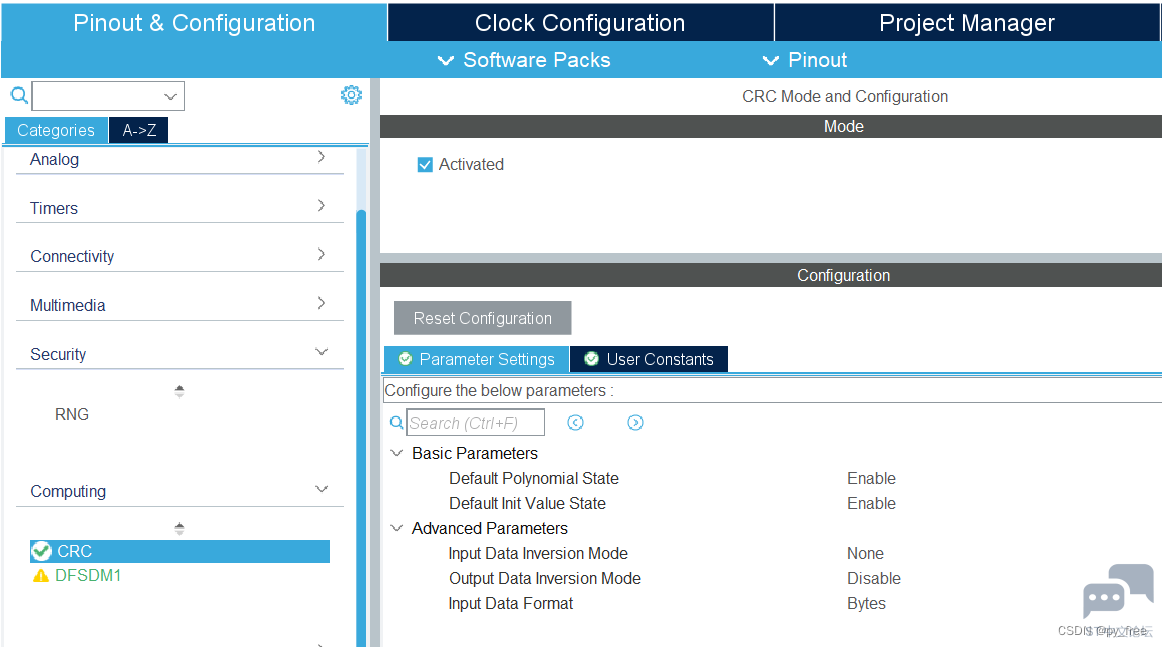

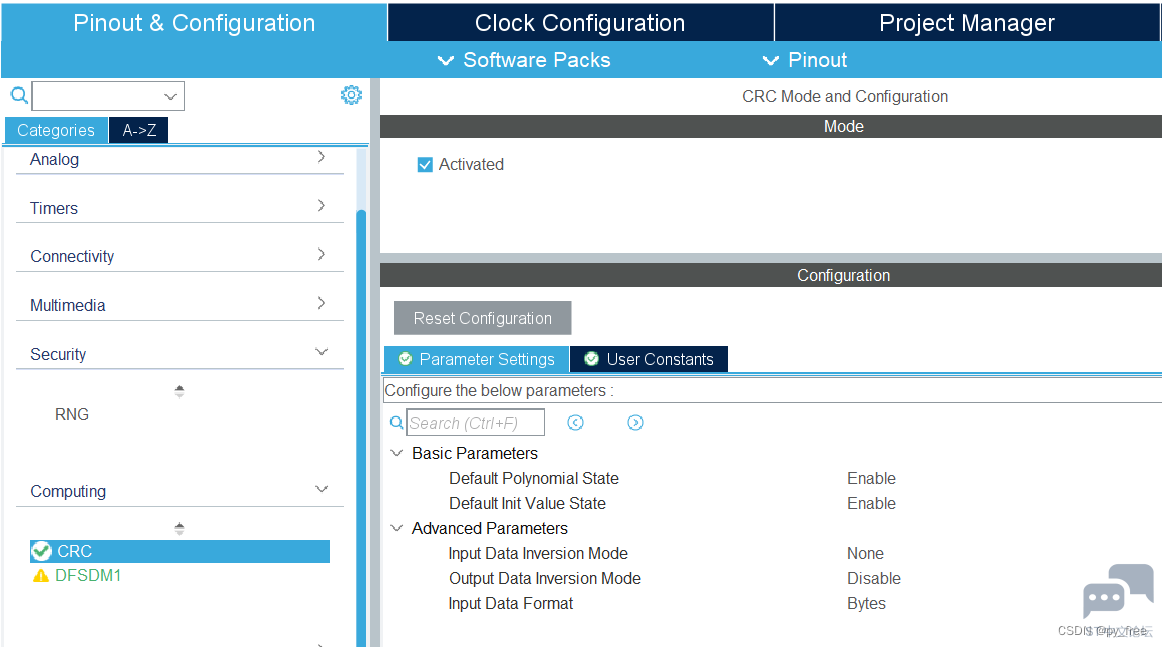

另外,需要注意,开启X-CUBE-AI支持后,其依赖CRC功能,会自动开启CRC。

/ A6 c. X2 h8 i8 R1 f8 J* r! k9 N5 W; I

% m7 d( b; j4 _

% m7 d( b; j4 _

1 u/ ^ y2 ]( }

6.3 模型分析与PC端验证

! }/ s$ H& s: z' K+ { 添加(add network)神经网络如下,在3中可以修改神经网络模型名称,在4中选择支持框架及选择模型文件,例如“STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_24_14_40_13\har_IGN.h5”,在5、6中,可以选择随机数据进行模型研制,也可以选择生成的研制数据进行验证(前面训练模型时,在RunMe.py文件后面加入语句,输出testx.npy、testy.npy文件):" v! G1 {& W( |, R- p

: G( ^3 M1 `& i, V% c- m7 b4 n4 B

8 o, K0 _ Z( }( b

8 o, K0 _ Z( }( b

- R* c- p* N: h% [' M( Q; S 可以点击设置按钮进入,在该页面下可以对神经网络进行更多设置和更详细信息查看,主要是以模型优化为主,本文先保持默认。

: q2 \# n; k7 p& x! @: p4 y6 o/ S o w) q5 N, Z* L

' W' I4 q# ^9 I/ |: b( u8 M

' W' I4 q# ^9 I/ |: b( u8 M

1 d& i* P5 A2 b% |: D6 X8 B 点击分析按钮(Analyze),输出该模型相关信息及部署模型需要的计算资源(ram、flash等): i4 b$ Q& M* w

; }1 S7 N9 ^6 o* X6 n* }-

) r" F3 M8 e3 n6 ]3 G7 P - Analyzing model ) h0 o+ `# E; m, f* X

- D:/workForSoftware/STM32CubeMX/Repository/Packs/STMicroelectronics/X-CUBE-AI/7.3.0/Utilities/windows/stm32ai analyze --name har_ign -m D:/tools/arm_tool/STM32CubeIDE/STM32CubeFunctionPack_SENSING1_V4.0.3/Utilities/AI_Ressources/Training Scripts/HAR/results/2023_Jan_11_17_50_03/har_IGN.h5 --type keras --compression none --verbosity 1 --workspace C:\Users\py_hp\AppData\Local\Temp\mxAI_workspace465785871649500151581099545474794 --output C:\Users\py_hp\.stm32cubemx\network_output --allocate-inputs --allocate-outputs . n6 [; O8 c4 i, y

- Neural Network Tools for STM32AI v1.6.0 (STM.ai v7.3.0-RC5)

3 \& t* `# B. s0 k. B* _# Q$ d/ G7 Z7 o -

$ t& b4 Y/ r- }5 R0 A- n9 m - Exec/report summary (analyze) 1 o' z5 j {5 M9 U

- --------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- . L7 S. k V) F9 j- w4 X# ?# n8 }0 Y

- model file : D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_11_17_50_03\har_IGN.h5 3 r W9 ~4 W; H" M' ^( R1 M' I0 r

- type : keras & T {# O# z2 w8 T+ o, o

- c_name : har_ign # H6 z5 v6 ?3 t+ F; F l

- compression : none - V$ `8 A- h8 g+ }

- options : allocate-inputs, allocate-outputs

1 ~( t6 \1 z( \( Z - optimization : balanced

6 |5 a0 Q. @; e" ~" p8 q, H - target/series : generic 1 W$ \4 T6 l3 I" O! S6 L

- workspace dir : C:\Users\py_hp\AppData\Local\Temp\mxAI_workspace465785871649500151581099545474794 . S9 |9 T: j) s# x4 D

- output dir : C:\Users\py_hp\.stm32cubemx\network_output

, h* Z3 E* u) {! v% N$ v3 Z - model_fmt : float

8 w( p1 c2 `7 a9 ? - model_name : har_IGN / B0 `2 u; m& f0 }

- model_hash : ff0080dbe395a3d8fd3f63243d2326d5

+ |" G; V5 \4 U. a* k2 {9 |& C4 T - params # : 3,064 items (11.97 KiB) - O( ]% k4 J6 @, E/ d }

- --------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- ; |# m @9 ? d4 X: }; j6 I) d4 p0 Y+ o+ J

- input 1/1 : 'input_0' (domain:activations/**default**) 2 P- H4 t+ k4 z/ B: x9 v# E( h

- : 72 items, 288 B, ai_float, float, (1,24,3,1)

+ o# }+ D5 y: o" t Z8 C - output 1/1 : 'dense_2' (domain:activations/**default**) 1 u5 m' @# Y) x1 ^. V. W$ r2 I& _$ d! x

- : 4 items, 16 B, ai_float, float, (1,1,1,4)

; G) D ^( Z& ]; X, E; h! c4 ? - macc : 14,404

3 D& f+ U1 T; `6 i$ W - weights (ro) : 12,256 B (11.97 KiB) (1 segment) 0 S& X) p0 W2 Y4 h) ?

- activations (rw) : 2,016 B (1.97 KiB) (1 segment) *

1 L# x% i; E/ @1 u# y* Y8 g - ram (total) : 2,016 B (1.97 KiB) = 2,016 + 0 + 0 6 q' }5 D* f( `& ~* v+ ~6 I

- --------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- " d4 N/ g, S6 J9 N

- (*) 'input'/'output' buffers can be used from the activations buffer

8 S! }7 {& q0 x# v5 e E' I - 5 I( f; W. H7 g4 K8 D7 c

- Model name - har_IGN ['input_0'] ['dense_2']

- G) M3 R8 I& r" P, y" J - ------------------------------------------------------------------------------------------------------ 7 V2 Q' B2 E8 @# i

- id layer (original) oshape param/size macc connected to

; o8 u: A' J5 h; J! D4 P - ------------------------------------------------------------------------------------------------------ & R6 x( H. p7 e+ @! n+ D% l

- 0 input_0 (None) [b:None,h:24,w:3,c:1] 9 F) |4 s8 p/ r

- conv2d_1_conv2d (Conv2D) [b:None,h:9,w:3,c:24] 408/1,632 10,392 input_0 ; L# V# o5 |6 l5 ]; ^

- conv2d_1 (Conv2D) [b:None,h:9,w:3,c:24] 648 conv2d_1_conv2d

5 N: q; z; {2 F5 j4 V6 J - ------------------------------------------------------------------------------------------------------

* h5 i* s! i$ I5 `8 Y5 o - 1 max_pooling2d_1 (MaxPooling2D) [b:None,h:3,w:3,c:24] 648 conv2d_1 ) J; l. Z- |$ S, a$ d6 _

- ------------------------------------------------------------------------------------------------------

# |8 [ ]$ g# @# x r% u" g; h7 ~ - 2 flatten_1 (Flatten) [b:None,c:216] max_pooling2d_1

; ]/ r& p' p7 H# v - ------------------------------------------------------------------------------------------------------

0 F8 q' E; d, V0 u* j/ o - 3 dense_1_dense (Dense) [b:None,c:12] 2,604/10,416 2,604 flatten_1

1 t9 Y: f, ]) f+ Q) s! z3 H7 u - ------------------------------------------------------------------------------------------------------

8 E" j4 H+ n& n/ b - 5 dense_2_dense (Dense) [b:None,c:4] 52/208 52 dense_1_dense

2 I7 T* \8 {' f: x2 c - dense_2 (Dense) [b:None,c:4] 60 dense_2_dense 1 ] R; n) ]3 D

- ------------------------------------------------------------------------------------------------------ 0 ^$ |; |5 k, D/ }% Q+ O2 |

- model/c-model: macc=14,404/14,404 weights=12,256/12,256 activations=--/2,016 io=--/0

: V1 _6 y$ x, ]& s) M - ) X1 L- J h: b7 C

- Number of operations per c-layer

, k; ?) ^0 b8 o2 L' o+ Y - ----------------------------------------------------------------------------------- & e1 o/ C4 m6 }1 Z' E

- c_id m_id name (type) #op (type) ; w5 k* d& m( ^& p- n1 h2 h

- -----------------------------------------------------------------------------------

- _5 x0 p/ [% r0 q - 0 1 conv2d_1_conv2d (optimized_conv2d) 11,688 (smul_f32_f32) 8 |4 p) i1 j$ `4 e2 }$ ~+ q3 }" J/ L G

- 1 3 dense_1_dense (dense) 2,604 (smul_f32_f32) * j, |3 Y$ `, o, _( L* U3 Q

- 2 5 dense_2_dense (dense) 52 (smul_f32_f32) : m3 a2 }! ^/ `( l! l

- 3 5 dense_2 (nl) 60 (op_f32_f32)

; e5 A, _, M3 } `2 m8 } - ----------------------------------------------------------------------------------- 5 \- p$ u/ b0 Y' M8 L

- total 14,404

) J$ q7 ?; N7 }8 o -

4 s8 l- g* j* D7 i0 t/ f n0 S - Number of operation types

/ T! a/ f/ B, e! J# v& ? - --------------------------------------------- * I) k4 ~ D l. l0 N3 L

- smul_f32_f32 14,344 99.6%

- ?/ X7 ^( V3 @. ] - op_f32_f32 60 0.4% / _" }( s9 k( ?% t- t

-

' b- `( X2 V' b# q& _5 ~# r; s - Complexity report (model) V; J: B- w- `6 W

- ------------------------------------------------------------------------------------

2 p7 Y! l9 _- k- @ s4 \ - m_id name c_macc c_rom c_id ( Q; U; o' ]; R$ ^# i( J X8 S

- ------------------------------------------------------------------------------------ ! H# k+ Q. t8 D5 c! Z

- 1 max_pooling2d_1 |||||||||||||||| 81.1% ||| 13.3% [0]

& Z5 `% o g8 K, b, x; s& [, l; Z# R - 3 dense_1_dense |||| 18.1% |||||||||||||||| 85.0% [1] : N& W/ K2 V3 f1 i, e+ U1 y

- 5 dense_2_dense | 0.8% | 1.7% [2, 3] 3 y# k* Y. A9 }

- ------------------------------------------------------------------------------------

" W6 {9 U9 A6 X( e: f; o" m. o- X - macc=14,404 weights=12,256 act=2,016 ram_io=0

3 R9 p d/ Y9 C7 u - Creating txt report file C:\Users\py_hp\.stm32cubemx\network_output\har_ign_analyze_report.txt + ^6 q% J, |9 K2 S" z; T

- elapsed time (analyze): 7.692s

, ]5 `. F( @: i6 ?0 D - Getting Flash and Ram size used by the library . o4 \2 x, {7 X, V" d

- Model file: har_IGN.h5 2 ^. N9 i3 C0 d; q+ W5 h n0 i$ X

- Total Flash: 29880 B (29.18 KiB) ) v8 r5 b9 U3 ^- |6 j

- Weights: 12256 B (11.97 KiB)

; Y( E ?) H. g5 x7 T! o - Library: 17624 B (17.21 KiB) 6 R4 n( ^3 R5 ^0 C! H, V$ T+ p

- Total Ram: 4000 B (3.91 KiB) k7 v2 F* U" ~" v% ^& K

- Activations: 2016 B (1.97 KiB) % L7 Q ?) Q6 e* b- _8 u

- Library: 1984 B (1.94 KiB) 4 g4 ^, S G. F( G y0 T/ t& ^

- Input: 288 B (included in Activations) 5 W/ e9 @9 O5 l' Y5 G

- Output: 16 B (included in Activations) / U2 K) Z9 V2 n+ u4 b) Y% Y

- Done

- w- y+ N+ d/ l% ^' A& R X - Analyze complete on AI model

点击PC桌面验证按钮(validation on desktop),对训练模型进行验证,主要是验证原始模型和转为c语言支持的模型时,验证前后计算资源、模型精度等差异情况,验证数据就是我们刚指定的testx.npy、testy.npy文件。

5 I8 B2 t- o3 J# \0 |- " n" u) A J# p) i; L% z

- Starting AI validation on desktop with custom dataset : D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_24_14_40_13\testx.npy... 9 h9 b& @# S( y! u" l7 _% s

- D:/workForSoftware/STM32CubeMX/Repository/Packs/STMicroelectronics/X-CUBE-AI/7.3.0/Utilities/windows/stm32ai validate --name har_ign -m D:/tools/arm_tool/STM32CubeIDE/STM32CubeFunctionPack_SENSING1_V4.0.3/Utilities/AI_Ressources/Training Scripts/HAR/results/2023_Jan_11_17_50_03/har_IGN.h5 --type keras --compression none --verbosity 1 --workspace C:\Users\py_hp\AppData\Local\Temp\mxAI_workspace46601041973700012072836595678733048 --output C:\Users\py_hp\.stm32cubemx\network_output --allocate-inputs --allocate-outputs --valoutput D:/tools/arm_tool/STM32CubeIDE/STM32CubeFunctionPack_SENSING1_V4.0.3/Utilities/AI_Ressources/Training Scripts/HAR/results/2023_Jan_24_14_40_13/testy.npy --valinput D:/tools/arm_tool/STM32CubeIDE/STM32CubeFunctionPack_SENSING1_V4.0.3/Utilities/AI_Ressources/Training Scripts/HAR/results/2023_Jan_24_14_40_13/testx.npy ; S+ r3 k' `: Y3 k @ j

- Neural Network Tools for STM32AI v1.6.0 (STM.ai v7.3.0-RC5) 1 x: W, L6 Q# Z& n6 d- H

- Copying the AI runtime files to the user workspace: C:\Users\py_hp\AppData\Local\Temp\mxAI_workspace46601041973700012072836595678733048\inspector_har_ign\workspace 0 W! i9 N" R. l0 u8 Z

-

: [) T. R% _# }7 W - Exec/report summary (validate) . ]" J1 ^# @1 z

- ---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

. x) H5 S9 W- R6 S - model file : D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_11_17_50_03\har_IGN.h5

N$ g4 K/ R* s9 M* p8 n( b1 S8 T1 o - type : keras & c. g! @& I. x4 T" A

- c_name : har_ign ) Z v' |: _ v) D5 O/ _8 {9 m

- compression : none

+ p' H# B; m: G! i+ }' z/ U - options : allocate-inputs, allocate-outputs 4 l+ l3 }2 T2 L4 N5 f

- optimization : balanced ! w; | I: I) P+ c

- target/series : generic 7 O! G& o* L4 @- I: a* `

- workspace dir : C:\Users\py_hp\AppData\Local\Temp\mxAI_workspace46601041973700012072836595678733048 , w9 O& {0 i, ?

- output dir : C:\Users\py_hp\.stm32cubemx\network_output

, I" \2 ^- G* F# ~# M: R( j# t4 u - vinput files : D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_24_14_40_13\testx.npy ; a3 m4 t. K: v4 ]5 Y0 G5 Q# v

- voutput files : D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_24_14_40_13\testy.npy

+ D3 Y( \% A6 u2 R: E5 r - model_fmt : float " O$ Q1 k; o" }& L3 D4 R+ J k4 y

- model_name : har_IGN

( j- h$ w& d7 s+ x5 f# z5 p) z - model_hash : ff0080dbe395a3d8fd3f63243d2326d5

- k ?- i# r0 q2 o0 G; Q - params # : 3,064 items (11.97 KiB)

8 Q! y1 K$ i# [0 p - ---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

0 S$ U' S* r2 b - input 1/1 : 'input_0' (domain:activations/**default**)

) x. U |: t- t# N% e - : 72 items, 288 B, ai_float, float, (1,24,3,1) & G( Z( P" y H! ]7 G! @

- output 1/1 : 'dense_2' (domain:activations/**default**) 4 k6 F5 y$ O' _+ g* Y

- : 4 items, 16 B, ai_float, float, (1,1,1,4)

, H1 T, G: g& x% M: g; ~ - macc : 14,404 ) r" O6 U- j+ C/ m8 T

- weights (ro) : 12,256 B (11.97 KiB) (1 segment) / g0 \2 R2 `# z1 z

- activations (rw) : 2,016 B (1.97 KiB) (1 segment) *

( \! M' V, _3 K9 [ - ram (total) : 2,016 B (1.97 KiB) = 2,016 + 0 + 0

2 s7 |% d( F" s, { - --------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- 3 a& N6 e1 h' h2 v8 L' p8 _- r

- (*) 'input'/'output' buffers can be used from the activations buffer 6 Y% j) P8 ~0 ^

- Setting validation data... : K% t+ F) K5 H

- loading file: D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_24_14_40_13\testx.npy

% a( q4 h0 w7 O4 [. g) S& k! q( U3 [ - - samples are reshaped: (12806, 24, 3, 1) -> (12806, 24, 3, 1) 3 q. U2 O1 }% I |& N3 Z- D' P6 V

- loading file: D:\tools\arm_tool\STM32CubeIDE\STM32CubeFunctionPack_SENSING1_V4.0.3\Utilities\AI_Ressources\Training Scripts\HAR\results\2023_Jan_24_14_40_13\testy.npy

% X& Z2 @8 ?+ u - - samples are reshaped: (12806, 4) -> (12806, 1, 1, 4) 9 O, H% [3 M9 d; v( \

- I[1]: (12806, 24, 3, 1)/float32, min/max=[-26.319, 32.844], mean/std=[0.075, 5.034], input_0

' r, i' J _3 _ B2 X* ` - O[1]: (12806, 1, 1, 4)/float32, min/max=[0.000, 1.000], mean/std=[0.250, 0.433], dense_2 : S- S+ I. B* Z5 m* i' o

- Running the STM AI c-model (AI RUNNER)...(name=har_ign, mode=x86)

' X2 |3 I+ Y1 ^& Q8 T; ^- A% L! P* F - X86 shared lib (C:\Users\py_hp\AppData\Local\Temp\mxAI_workspace46601041973700012072836595678733048\inspector_har_ign\workspace\lib\libai_har_ign.dll) ['har_ign']

6 ^. U# U" U) {0 I" W, h4 j. y - Summary "har_ign" - ['har_ign'] / f) \( `' r" g9 v' }& b

- -------------------------------------------------------------------------------- 8 C9 q) ~+ @; V

- inputs/outputs : 1/1

" U" @: u4 U) N - input_1 : (1,24,3,1), float32, 288 bytes, in activations buffer

; Z' D9 y" R0 g/ o! V - output_1 : (1,1,1,4), float32, 16 bytes, in activations buffer 9 F& j+ l8 F2 G2 P$ u/ w0 J1 C

- n_nodes : 4

! w1 o! \. r& @ - compile_datetime : Jan 25 2023 22:55:51 (Wed Jan 25 22:55:47 2023) & T. U5 \- V1 c$ ?; X

- activations : 2016 0 c1 v, _* E4 X: E0 o: X

- weights : 12256

6 Z" e* @$ V; s# \; i' ] - macc : 14404 # e0 g) o3 _$ v0 z1 q/ q( f6 `

- -------------------------------------------------------------------------------- % a3 A9 b4 G( H% q

- runtime : STM.AI 7.3.0 (Tools 7.3.0) ! e! C5 R% }' K7 F- R7 a; L, }

- capabilities : ['IO_ONLY', 'PER_LAYER', 'PER_LAYER_WITH_DATA'] 6 d, N% ~5 ~% s9 L# P

- device : AMD64 Intel64 Family 6 Model 158 Stepping 9, GenuineIntel (Windows) % t' r8 s' a& X8 G) J8 _

- -------------------------------------------------------------------------------- ; L% ]) |4 e' j! a9 z v" o

- STM.IO: 0%| | 0/12806 [00:00<?, ?it/s] ! a& d8 D9 l- Y' w- n

- STM.IO: 11%|█ | 1424/12806 [00:00<00:00, 14136.31it/s]

/ O& u5 r, U0 U2 e$ {2 U - STM.IO: 14%|█▍ | 1849/12806 [00:00<00:04, 2293.62it/s]

9 C' V8 ~( u) { - STM.IO: 17%|█▋ | 2170/12806 [00:00<00:05, 1774.74it/s]

; f8 Z4 Y# B3 u r2 h1 d" b4 ] - STM.IO: 19%|█▉ | 2429/12806 [00:01<00:06, 1520.26it/s]

+ p1 I( A! J; w, b! w* J6 m - STM.IO: 21%|██ | 2645/12806 [00:01<00:07, 1348.30it/s]

% S7 e2 ^3 S8 `# X. N0 r - STM.IO: 22%|██▏ | 2828/12806 [00:01<00:07, 1291.67it/s] & J4 `; Z6 j, S

- STM.IO: 23%|██▎ | 2992/12806 [00:01<00:07, 1245.52it/s]

7 v( p9 W; ^; Z7 ], ^; V# v - STM.IO: 25%|██▍ | 3141/12806 [00:01<00:08, 1194.67it/s]

5 s }" J% N7 i& P - STM.IO: 26%|██▌ | 3278/12806 [00:01<00:08, 1107.82it/s] ; ]. F4 }8 J& L

- STM.IO: 27%|██▋ | 3407/12806 [00:02<00:08, 1154.55it/s] 0 [; D0 Q/ G; ?; V1 ]: S+ z

- STM.IO: 28%|██▊ | 3548/12806 [00:02<00:07, 1218.70it/s]

: ^2 V5 S8 }9 D, Y3 K6 k) q# I - STM.IO: 29%|██▊ | 3678/12806 [00:02<00:07, 1175.60it/s] : q, a$ n) U: V3 Y: m* [& m' E

- STM.IO: 30%|██▉ | 3811/12806 [00:02<00:07, 1215.67it/s]

' ^0 Q% N8 ?9 O! z- B - STM.IO: 31%|███ | 3938/12806 [00:02<00:07, 1139.58it/s] & I# V( N' L0 T( r3 R7 m7 a* \

- STM.IO: 32%|███▏ | 4075/12806 [00:02<00:07, 1197.83it/s]

& S! e/ p! ]$ E5 \ - STM.IO: 33%|███▎ | 4199/12806 [00:02<00:07, 1207.70it/s]

: W& B- v0 R. ~: d& T* y# Z - STM.IO: 34%|███▍ | 4323/12806 [00:02<00:07, 1078.59it/s] , z( J1 [) H& D- i$ i

- STM.IO: 35%|███▍ | 4451/12806 [00:02<00:07, 1129.92it/s] # T2 a% F9 v3 o3 \$ K3 Q

- STM.IO: 36%|███▌ | 4590/12806 [00:03<00:06, 1194.76it/s] . m- w7 t% P, L8 C) q, b

- STM.IO: 37%|███▋ | 4718/12806 [00:03<00:06, 1216.59it/s] 6 w+ U" j; W5 Z

- STM.IO: 38%|███▊ | 4843/12806 [00:03<00:06, 1195.77it/s]

2 M+ x' v# e0 K' y9 z) Z - STM.IO: 39%|███▉ | 4965/12806 [00:03<00:06, 1159.48it/s]

/ J Z* f; n+ n. c( u; h0 p! n - STM.IO: 40%|███▉ | 5083/12806 [00:03<00:06, 1116.81it/s] & O: o( U! P( l' o) X$ E _+ X( ~

- STM.IO: 41%|████ | 5197/12806 [00:03<00:06, 1095.57it/s]

' t+ k- |' o% r. n - STM.IO: 41%|████▏ | 5308/12806 [00:03<00:06, 1078.25it/s] 1 b: |% D5 \( T6 y9 ]

- STM.IO: 42%|████▏ | 5433/12806 [00:03<00:06, 1122.47it/s]

9 [3 i$ Z; A5 B - STM.IO: 43%|████▎ | 5547/12806 [00:03<00:06, 1056.59it/s] . G& V1 _- K; z* s, l0 ]/ K0 d* Z: ]

- STM.IO: 44%|████▍ | 5655/12806 [00:04<00:06, 1055.01it/s]

* B, e9 l4 Y- p; B" K - STM.IO: 45%|████▍ | 5762/12806 [00:04<00:06, 1035.74it/s] 3 i$ L. W4 N, ?

- STM.IO: 46%|████▌ | 5867/12806 [00:04<00:06, 1022.60it/s]

5 B |+ y9 g4 c8 ^ c! F& u - STM.IO: 47%|████▋ | 5981/12806 [00:04<00:06, 1053.06it/s]

0 K+ K: M8 T' {/ `% J - STM.IO: 48%|████▊ | 6098/12806 [00:04<00:06, 1083.31it/s]

* x8 w6 b' `: T1 B4 ?" j2 d - STM.IO: 48%|████▊ | 6208/12806 [00:04<00:06, 1025.35it/s]

3 V# g$ J& j( A8 Y" F8 a - STM.IO: 49%|████▉ | 6312/12806 [00:04<00:06, 952.27it/s]

2 E0 k/ E7 m7 x Q - STM.IO: 50%|█████ | 6410/12806 [00:04<00:07, 910.42it/s] " G" k4 P7 Q8 ]3 k6 d

- STM.IO: 51%|█████ | 6509/12806 [00:04<00:06, 930.92it/s]

" p4 |4 |6 n, t: r, M# g - STM.IO: 52%|█████▏ | 6620/12806 [00:04<00:06, 976.37it/s] d$ O9 \; N3 { M3 s8 Z3 c

- STM.IO: 52%|█████▏ | 6720/12806 [00:05<00:06, 926.81it/s]

; a$ n0 e1 v# e2 X: \ - STM.IO: 53%|█████▎ | 6818/12806 [00:05<00:06, 940.17it/s] ( U% c7 z) n* {* y; Z$ Y! L+ ?

- STM.IO: 54%|█████▍ | 6914/12806 [00:05<00:06, 930.36it/s]

' Z+ A: x" d+ `7 }; H& e, O; E5 v - STM.IO: 55%|█████▍ | 7008/12806 [00:05<00:06, 852.84it/s]

e- q p* V9 w" B - STM.IO: 55%|█████▌ | 7106/12806 [00:05<00:06, 885.63it/s] 9 P2 w# |( f6 ^) U8 a- l6 h

- STM.IO: 56%|█████▌ | 7197/12806 [00:05<00:06, 805.83it/s] 7 J. @$ Z3 o9 C4 e# J; |! u; l$ g

- STM.IO: 57%|█████▋ | 7299/12806 [00:05<00:06, 858.49it/s] ! p+ f: x& n3 C( h0 x3 L

- STM.IO: 58%|█████▊ | 7388/12806 [00:05<00:07, 744.49it/s]

! {. w: {. l& d1 \$ `2 C - STM.IO: 58%|█████▊ | 7473/12806 [00:06<00:07, 755.34it/s]

" v, Y. S& ]" ~* d% g- x2 r - STM.IO: 59%|█████▉ | 7560/12806 [00:06<00:06, 785.88it/s]

/ m' S! F" Y+ r - STM.IO: 60%|█████▉ | 7642/12806 [00:06<00:06, 782.78it/s] 8 T2 H; B4 |# Q; K; Y. C+ o

- STM.IO: 60%|██████ | 7723/12806 [00:06<00:06, 768.90it/s] ! O/ [! z6 q* v' {

- STM.IO: 61%|██████ | 7825/12806 [00:06<00:06, 828.66it/s] - f! B6 D8 {# I) W; E9 E' s, ]+ ]

- STM.IO: 62%|██████▏ | 7937/12806 [00:06<00:05, 897.30it/s]

; }2 t* L9 l* R( _& I! E - STM.IO: 63%|██████▎ | 8033/12806 [00:06<00:05, 913.23it/s]

; v' K! `4 H/ b" w7 X( t" f0 Z - STM.IO: 63%|██████▎ | 8127/12806 [00:06<00:05, 913.79it/s] 3 M' ~' c& \6 i" u1 v

- STM.IO: 64%|██████▍ | 8254/12806 [00:06<00:04, 994.44it/s]

. n1 s3 \4 C' L# u; D' A7 l+ C# u - STM.IO: 65%|██████▌ | 8358/12806 [00:06<00:04, 1005.50it/s] 2 a0 j2 S" @' ?

- STM.IO: 66%|██████▌ | 8466/12806 [00:07<00:04, 1024.62it/s]

# T, i& \# s" R, x - STM.IO: 67%|██████▋ | 8579/12806 [00:07<00:04, 1052.03it/s]

0 B: C; v1 o7 \: g h0 `1 | - STM.IO: 68%|██████▊ | 8712/12806 [00:07<00:03, 1111.93it/s]

, z0 f" o' K: O% V7 K - STM.IO: 69%|██████▉ | 8826/12806 [00:07<00:03, 1044.19it/s]

' d3 L1 q o4 ~5 p - STM.IO: 70%|██████▉ | 8933/12806 [00:07<00:03, 1005.29it/s] ( Z) G' ?+ B( R' n6 {* D% Y

- STM.IO: 71%|███████ | 9036/12806 [00:07<00:03, 1010.21it/s]

# } E6 h) B' k3 n# Q9 L+ ]$ o - STM.IO: 71%|███████▏ | 9150/12806 [00:07<00:03, 1043.83it/s] 7 X e( G& ^9 t% O! L: A" W/ X

- STM.IO: 72%|███████▏ | 9277/12806 [00:07<00:03, 1100.57it/s]

# @6 m" i4 C: i3 H2 J$ O - STM.IO: 73%|███████▎ | 9404/12806 [00:07<00:02, 1144.16it/s] 3 l' J. B1 q. Z2 W' s

- STM.IO: 74%|███████▍ | 9521/12806 [00:08<00:02, 1135.98it/s]

4 t0 k+ f3 R) n$ j7 R. g - STM.IO: 75%|███████▌ | 9648/12806 [00:08<00:02, 1170.75it/s]

: t' W7 |1 f. j( [ - STM.IO: 76%|███████▋ | 9780/12806 [00:08<00:02, 1209.41it/s]

) K+ z! [0 H+ s- d - STM.IO: 77%|███████▋ | 9903/12806 [00:08<00:02, 1184.92it/s] * @/ T7 D5 }. Z: L* t1 O4 @8 e" {

- STM.IO: 78%|███████▊ | 10032/12806 [00:08<00:02, 1212.12it/s]

! z( X3 r3 S* N ?2 Z - STM.IO: 79%|███████▉ | 10155/12806 [00:08<00:02, 1214.79it/s]

F. H$ y B( |+ |2 Z3 \ - STM.IO: 80%|████████ | 10278/12806 [00:08<00:02, 1096.01it/s]

6 k/ M& R$ v1 \, H8 E4 Y - STM.IO: 81%|████████ | 10391/12806 [00:08<00:02, 1100.40it/s] ' a! g! \6 H1 I

- STM.IO: 82%|████████▏ | 10506/12806 [00:08<00:02, 1112.34it/s]

" K9 z+ S$ ?: V3 K J - STM.IO: 83%|████████▎ | 10619/12806 [00:09<00:02, 1035.66it/s] $ F' D0 t' h" o. a

- STM.IO: 84%|████████▎ | 10725/12806 [00:09<00:02, 914.43it/s]

% w% e1 M) @( H$ ]: U/ { - STM.IO: 84%|████████▍ | 10821/12806 [00:09<00:02, 889.74it/s]

* N, j0 Y6 E4 y& ~, A - STM.IO: 85%|████████▌ | 10920/12806 [00:09<00:02, 915.76it/s]

* w9 J; R% b% c# Z - STM.IO: 86%|████████▌ | 11014/12806 [00:09<00:02, 819.91it/s] ; Y( @) G& H5 p$ M: Q) X7 N

- STM.IO: 87%|████████▋ | 11100/12806 [00:09<00:02, 738.28it/s] 2 Z( J# ]; c# Z5 l! `3 ~/ o

- STM.IO: 87%|████████▋ | 11178/12806 [00:09<00:02, 740.24it/s]

4 T" z& W( \7 J) T2 p* }0 h. G - STM.IO: 88%|████████▊ | 11255/12806 [00:09<00:02, 657.58it/s]

: p! k& j( h+ e$ r; D7 a6 Q( u+ u$ t - STM.IO: 89%|████████▊ | 11364/12806 [00:10<00:02, 702.16it/s] 4 S! N2 @# H/ p

- STM.IO: 89%|████████▉ | 11455/12806 [00:10<00:01, 752.49it/s]

! |7 O5 R N( }, V( u. y6 P - STM.IO: 90%|█████████ | 11548/12806 [00:10<00:01, 794.66it/s] 6 [2 ]# B# N. i( I6 i) Y& O

- STM.IO: 91%|█████████ | 11631/12806 [00:10<00:01, 796.56it/s]

# {3 A9 I4 x- q( X - STM.IO: 92%|█████████▏| 11748/12806 [00:10<00:01, 879.46it/s] 6 }- j, `6 M: }2 u$ A

- STM.IO: 93%|█████████▎| 11853/12806 [00:10<00:01, 922.73it/s]

3 y$ m2 d( g: Z- E5 Z' Q& I+ T. |/ A - STM.IO: 93%|█████████▎| 11949/12806 [00:10<00:00, 895.23it/s] , E" ]( n6 z" ~3 j0 N

- STM.IO: 94%|█████████▍| 12049/12806 [00:10<00:00, 922.41it/s] " q; Q0 v% U# N" {1 |! y

- STM.IO: 95%|█████████▍| 12163/12806 [00:10<00:00, 976.60it/s]

# w, Z( ^8 k8 x. K: C+ ^) y - STM.IO: 96%|█████████▌| 12280/12806 [00:10<00:00, 1025.50it/s]

+ B5 z. W* h, T8 B- w3 l - STM.IO: 97%|█████████▋| 12412/12806 [00:11<00:00, 1096.80it/s] - l; U( [$ ?4 N6 `+ u$ q. |& \+ g5 O

- STM.IO: 98%|█████████▊| 12525/12806 [00:11<00:00, 1072.91it/s] + s7 H- \3 L4 q* }7 x5 W

- STM.IO: 99%|█████████▉| 12663/12806 [00:11<00:00, 1147.57it/s] K5 B+ F+ ?$ v& r

- STM.IO: 100%|█████████▉| 12781/12806 [00:11<00:00, 1118.51it/s]

( p! `& a1 P9 s3 L, t1 S. z4 ~* w- { - Results for 12806 inference(s) - average per inference

+ H5 W2 p# d! F# l - device : AMD64 Intel64 Family 6 Model 158 Stepping 9, GenuineIntel (Windows) 2 k) v. ^/ v- X4 M

- duration : 0.057ms

% D) _0 d3 c% [8 S z% L - c_nodes : 4 ; }7 t; \! U5 E, y& _) C2 }

- c_id m_id desc output ms % + W1 c$ e0 O% l8 l8 x

- ------------------------------------------------------------------------------- ; a3 s/ ^% |6 p8 O- n

- 0 1 Conv2dPool (0x109) (1,3,3,24)/float32/864B 0.049 86.5% " K; f& v3 Z: E9 `; W, \; n; H1 h! x

- 1 3 Dense (0x104) (1,1,1,12)/float32/48B 0.005 9.1% 3 G9 F/ V4 e& T$ t) q

- 2 5 Dense (0x104) (1,1,1,4)/float32/16B 0.001 1.8% " M4 ]. |0 O6 j1 D

- 3 5 NL (0x107) (1,1,1,4)/float32/16B 0.001 2.5% 8 |0 o; p; A: `/ @8 j; A

- ------------------------------------------------------------------------------- . {$ t- O1 B; d4 U/ F4 @, |/ ~

- 0.057 ms 4 u( \9 k: X+ I' U

- NOTE: duration and exec time per layer is just an indication. They are dependent of the HOST-machine work-load. / `5 ~7 s! g" c/ ]# _# `

- Running the Keras model... 7 U3 |- Y' J5 u. x! _% L

- Saving validation data...

7 W& j/ r) ?+ t" i' ]& W - output directory: C:\Users\py_hp\.stm32cubemx\network_output 5 l1 V8 g8 w& q# \* o# y/ Z5 _, A

- creating C:\Users\py_hp\.stm32cubemx\network_output\har_ign_val_io.npz

, N! v" [ q+ @& J9 Y s |8 ` - m_outputs_1: (12806, 1, 1, 4)/float32, min/max=[0.000, 1.000], mean/std=[0.250, 0.376], dense_2 9 V/ z+ @+ l2 a Q

- c_outputs_1: (12806, 1, 1, 4)/float32, min/max=[0.000, 1.000], mean/std=[0.250, 0.376], dense_2

, m: J6 ^+ B1 e) S( ] - Computing the metrics... % }! G: c- r* b5 N

- Accuracy report #1 for the generated x86 C-model 9 T9 p. ?1 a6 `* q5 ^4 S: v. a

- ---------------------------------------------------------------------------------------------------- 5 k" I: w* C/ J: I; G. N

- notes: - computed against the provided ground truth values

$ L$ h# a4 t9 f* |( c/ y3 E& m% o - - 12806 samples (4 items per sample)

, x$ A8 F& d4 Y+ g% v - acc=86.72%, rmse=0.224433631, mae=0.096160948, l2r=0.496649474, nse=73.14%

( e' i; A2 O4 ] - 4 classes (12806 samples) % m- a2 Z P" T5 K" T

- ----------------------------

. q, }- [9 y9 ]3 \1 d; }0 _4 z* \ - C0 3678 . 62 41

4 C1 S1 g% T j1 U - C1 . 1124 14 .

$ \" Z) D+ w3 ^! P5 x - C2 254 10 1806 662

, Q, j! v3 i) Z( b, J - C3 66 . 592 4497

# n- G d8 h/ [+ K- [! G - Accuracy report #1 for the reference model 8 x5 B4 V9 c/ P6 S% V- c

- ----------------------------------------------------------------------------------------------------

5 ^$ ]5 ~7 V4 x6 V( p - notes: - computed against the provided ground truth values $ z9 n% o4 J; I$ v t0 V. x

- - 12806 samples (4 items per sample)

: P. s9 v; | d' @# ?# i0 _4 V2 s - acc=86.72%, rmse=0.224433631, mae=0.096160948, l2r=0.496649474, nse=73.14%

% w( m$ y$ ~5 k& i( @$ m& C - 4 classes (12806 samples)

) m$ D: B& E* _; N5 J5 p! I - ---------------------------- . t# m! R/ u" _+ F( Z- Q

- C0 3678 . 62 41 2 }0 R6 a+ _# f( S6 d

- C1 . 1124 14 . + ]& N8 `0 B6 ~ x/ u

- C2 254 10 1806 662 / b. j( Y! I2 ^

- C3 66 . 592 4497

: e" [9 J& z% ~. i - Cross accuracy report #1 (reference vs C-model)

' Q5 K7 E8 z! c) L" z3 C( N+ d' o - ----------------------------------------------------------------------------------------------------

) }9 K' @, f; [* R5 R8 G3 D - notes: - the output of the reference model is used as ground truth/reference value

5 I( _/ \ m+ L% R6 _; R - - 12806 samples (4 items per sample) 3 J# Y' `) f6 {, f' k: n1 O

- acc=100.00%, rmse=0.000000063, mae=0.000000024, l2r=0.000000139, nse=100.00%

6 K8 ~- B3 {4 ?1 O - 4 classes (12806 samples) % K/ w$ E z. D, A9 H3 w

- ----------------------------

# T5 S5 n! i3 S3 W - C0 3998 . . .

6 }$ `% E% P+ Y v: [0 u - C1 . 1134 . .

: }* G$ z+ \: e! A - C2 . . 2474 . 0 _; m! Q/ b: l+ t! r$ X% K& Y6 R: D

- C3 . . . 5200

+ A5 Z3 c5 E5 |1 q, R9 \+ t -

4 m+ @5 b& ?7 C5 A7 a" z - Evaluation report (summary) 5 H; {0 @' v! V6 t- c

- ---------------------------------------------------------------------------------------------------------------------------------------------------------- " k) S4 D+ u( m& q

- Output acc rmse mae l2r mean std nse tensor

+ g3 ~2 [: u4 a O8 T0 g2 U# m - ---------------------------------------------------------------------------------------------------------------------------------------------------------- 5 g% g. c" K2 }. O& ~

- x86 c-model #1 86.72% 0.224433631 0.096160948 0.496649474 -0.000000000 0.224435821 0.731362987 dense_2, ai_float, (1,1,1,4), m_id=[5] 4 }* u- L4 `* R8 J

- original model #1 86.72% 0.224433631 0.096160948 0.496649474 -0.000000001 0.224435821 0.731362987 dense_2, ai_float, (1,1,1,4), m_id=[5]

: |7 q3 R$ a' q" G @; e: b+ ] - X-cross #1 100.00% 0.000000063 0.000000024 0.000000139 0.000000000 0.000000063 1.000000000 dense_2, ai_float, (1,1,1,4), m_id=[5]

4 Y0 S" A1 s( k0 [' C. U0 |% k6 P - ----------------------------------------------------------------------------------------------------------------------------------------------------------

$ n. ~3 w% [6 X: X/ K - : l$ w8 D' O! N9 p* M) H

- rmse : Root Mean Squared Error

5 |6 B P! W" V - mae : Mean Absolute Error

4 v0 t( P9 k- u* E# l6 m: Q - l2r : L2 relative error

. h2 E, w6 O+ ?3 _! ~1 m9 [( V6 Q - nse : Nash-Sutcliffe efficiency criteria

[9 c+ C) j5 G W( | r - Creating txt report file C:\Users\py_hp\.stm32cubemx\network_output\har_ign_validate_report.txt

$ g6 N& X @7 @% s - elapsed time (validate): 26.458s

8 ~2 T& S7 i I' r& ?& b% @ - Validation

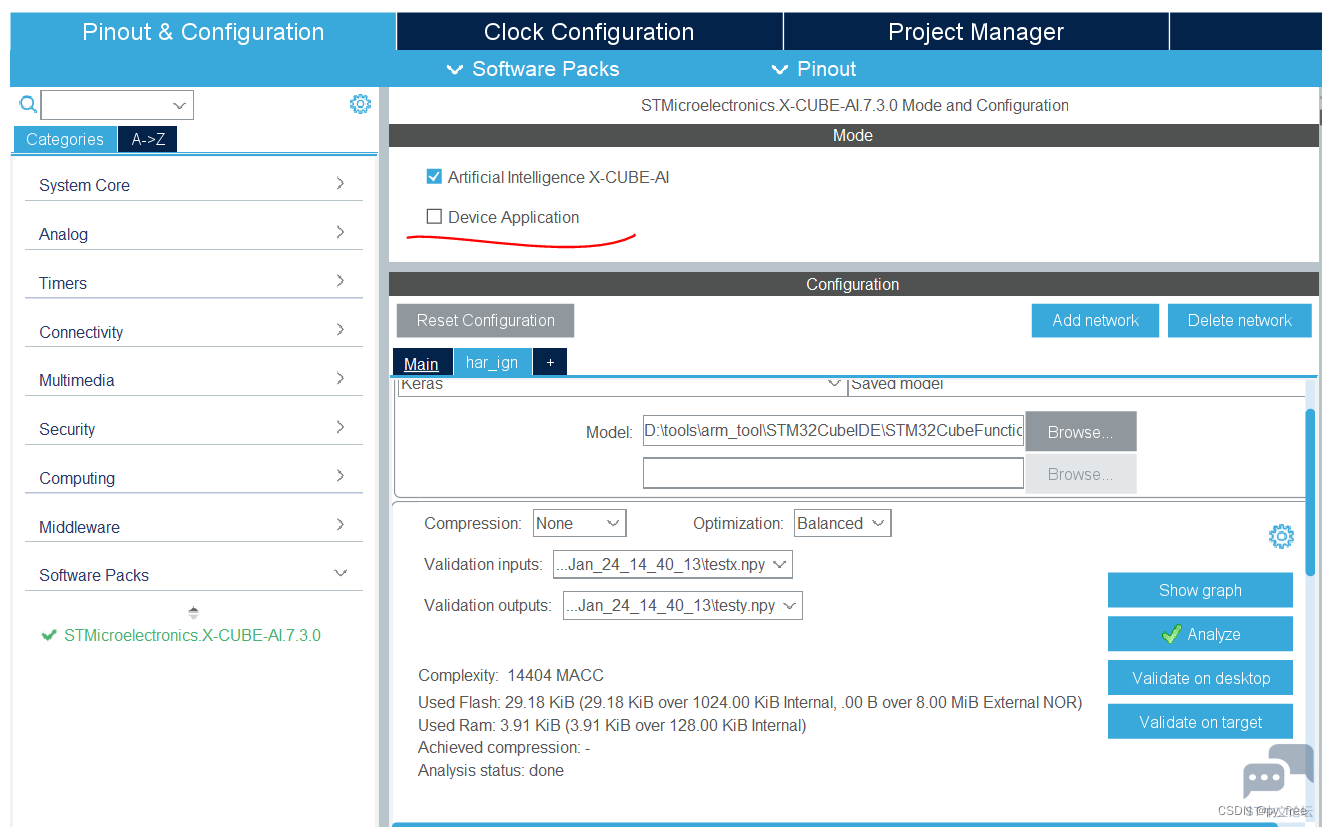

% F v2 y q& y. I! F/ v7 q 6.4 c语言神经网络模型生成及源码输出

, U" q5 `* j5 \6 l 将开发板重新选择ST-LINK连接(5-6跳线帽拔出,插入1-2跳线中)4 h$ X+ @; f! e: E! Y4 E+ @

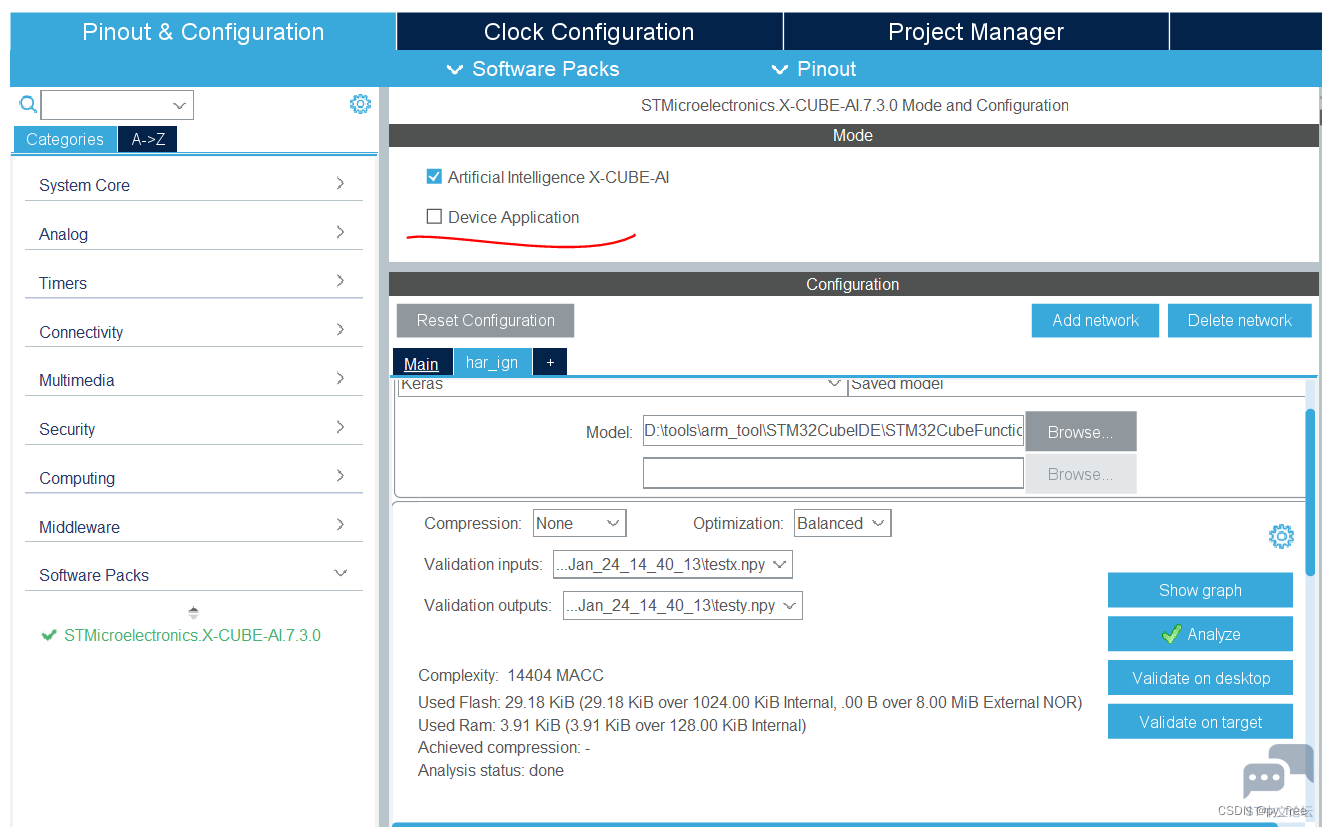

& P0 }( n i: a& f* H2 _1 T 为了后续源码讲解方便,只生产c语言的神经网络模型源码,不输出应用示例程序(有个弊端就是在新建程序加载到开发板后,validation on target功能无法使用),如下图所示。* U! M$ I7 |% X9 Y

u0 w0 {6 ^) }5 }- v; F

% W& O3 v b$ @* p( Q" D& N

% W& O3 v b$ @* p( Q" D& N

. J+ I! K. W4 ]0 p: w4 R0 u% O

配置输出工程

- H5 \2 J2 s; x4 K" \: h6 z# X6 }* j9 q# W; g' _

, g' J/ B& T1 h# P! ^6 I

, g' J/ B& T1 h# P! ^6 I

, A( l' k( x# Y/ O/ j

七、c语言神经网络模型使用

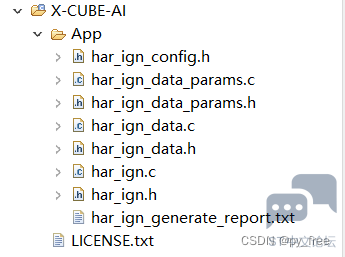

5 C5 v0 X6 S; R1 ^! u# B 7.1 C语言神经网络模型源文件

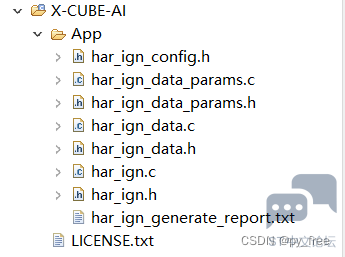

. W0 H) {/ ~, v0 F 在cubeMX配置神经网络模型时,指明了名称是har_ign,会生成如下文件har_ign.h/c、har_ign_data.h/c、har_ign_data_params.h/c、har_ign_config.h这些源码文件就是转换后的c语言神经网络模型,提供了一系列的API,这些API通过调用cube.AI软件包的内置功能,工程实现了神经网络计算功能:8 x. h, h# ]7 r0 f% p6 Y9 R" O

3 p, e; g' p5 y! y; x8 U

7 T. S% }3 Z" z M) [

7 T. S% }3 Z" z M) [

其中har_ign_generate_report.txt文件是生成c语言神经网络模型的过程记录。

) ]. l0 a. ~# M, Q/ A4 n

0 D+ ]- y* F" W2 x

3 v, `" }2 ] z- S3 ?+ o4 ]2 Q' f# D

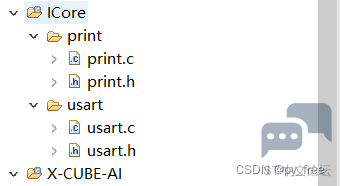

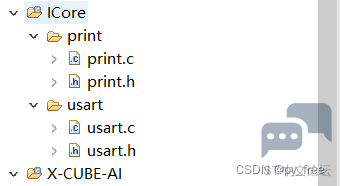

7.2 串口功能自定义实现

; E- ]1 V$ k/ T i 由于本文没有选择生成配套的应用程序代码,因此串口功能还需要自己实现,因此我移植了串口功能代码,在工程目录下,创建了ICore源目录,并创建print、usart子目录,分别在两个子目录加入print.h/c和usart.h/c源码。& x9 O2 y% t& y/ H. T

1 O( T+ A, G5 B/ X, X" U

1 [9 M: O; ~( f

1 [9 M: O; ~( f

' m) j1 E) I( f" Q# n( L

print.h如下:3 U4 Y: O2 r% V; I5 ]3 j

- #ifndef INC_RETARGET_H_/ \% U1 @$ U* x0 j$ I2 k+ K

- #define INC_RETARGET_H_1 f, v2 K' N' [: k/ B# I6 R" m

-

9 ?: g- I4 F% D5 C& n4 U - #include "stm32l4xx_hal.h"

3 L$ A9 h" N" m$ n6 b' T - #include "stdio.h"//用于printf函数串口重映射

/ H. D9 V9 P4 f, H0 [4 @+ N5 P W - #include <sys/stat.h>

/ y6 o6 }3 r$ }/ {1 G - j) A1 \( s' h3 |1 M

- void ResetPrintInit(UART_HandleTypeDef *huart);* A' \0 V( r/ t+ g& R D7 H

-

2 y" P& U9 G8 U { v; C- p - int _isatty(int fd);

' i/ n: [) q! J$ M9 u - int _write(int fd, char* ptr, int len);: |* |" ]+ Q. Y# w* M. H: b

- int _close(int fd);# N& m3 i- i2 S

- int _lseek(int fd, int ptr, int dir);( v+ L) q) R, P) E7 J6 b, w

- int _read(int fd, char* ptr, int len);

3 W" r: P- e9 E4 [# h - int _fstat(int fd, struct stat* st);% h4 }/ g; j" G( b: A' b0 `7 i

- ' _+ \$ N+ v, t7 X0 E2 d# S( x$ J

- #endif /* INC_RETARGET_H_ */

print.c如下:

) `; g' D1 u1 j- #include <_ansi.h>. I3 |2 v0 |% m$ R T

- #include <_syslist.h>0 A/ T; U9 @) ?& U- L

- #include <errno.h>) k' t, J: I3 c& n& U& `1 S' S

- #include <sys/time.h>

, r2 B9 T; u7 o$ ^9 u - #include <sys/times.h>

. M- }9 e5 @/ o8 v6 ~" W) { - #include <limits.h>

" R6 E2 f+ B- b7 J& U: o - #include <signal.h>0 O3 Z% x1 v& P5 ?! t8 {2 d1 b

- #include <stdint.h>: f2 d: F! t4 S ]

- #include <stdio.h>

+ |/ p3 ?: l, p0 f+ S. d - / C0 E4 }4 A# I( I* M9 x8 J9 I T

- #include "print.h"# i5 [& B/ O6 W6 J& I

- ) J2 L- F1 o) e. ~( X* D1 R& p

- #if !defined(OS_USE_SEMIHOSTING)9 ?! }7 G2 w5 x. M2 F$ a

- #define STDIN_FILENO 0

# k' N3 G! d# E! r l# e' I, j - #define STDOUT_FILENO 1- M. f8 u' m4 F$ z1 i$ o

- #define STDERR_FILENO 2; u" G: J* e9 C$ A4 I

- * P" h; i2 Z% q0 z( i- p; |2 h# t

- UART_HandleTypeDef *gHuart;

% W9 R9 f$ q$ `& V - ( Z, h5 | W0 ~) P8 u2 k8 J

- void ResetPrintInit(UART_HandleTypeDef *huart) {, G* C/ w3 d. A3 Q% w% V; r* Q: \

- gHuart = huart;+ H! L: q9 y( |0 u; T

- /* Disable I/O buffering for STDOUT stream, so that

2 J$ J) r) r' K" \5 _- \/ I& g* B - * chars are sent out as soon as they are printed. */

9 @6 e2 G* M/ t( e - setvbuf(stdout, NULL, _IONBF, 0);

; u" H& S+ [. D* V1 w/ s# p - }

: _( D' k1 Z) @4 v9 M! l6 D g7 y5 g - int _isatty(int fd) {

9 e% a) |8 B! l+ Y' o7 j - if (fd >= STDIN_FILENO && fd <= STDERR_FILENO)% v) b" b/ v* M" m

- return 1;( O! S8 Z- K6 l5 ?/ S1 E1 T

- errno = EBADF;/ I4 g P) u1 N6 y/ l: U+ i

- return 0;8 m2 l& v) Q& w. a7 p6 @

- }1 Y; `" K+ P A- n3 d" b

- int _write(int fd, char* ptr, int len) {3 e, F2 h$ X- J8 M# M! I

- HAL_StatusTypeDef hstatus;

' y: A3 g* L/ b4 [- d( u - if (fd == STDOUT_FILENO || fd == STDERR_FILENO) {+ D6 l- A+ T0 h5 m8 @

- hstatus = HAL_UART_Transmit(gHuart, (uint8_t *) ptr, len, HAL_MAX_DELAY);$ T" r( h, e' \# [

- if (hstatus == HAL_OK)

8 x5 N) f J0 L& e" V - return len; X: ?; y8 O4 o0 D/ |" ~! W) [

- else

4 C6 d' B1 l G/ G9 E; l - return EIO;

7 Q/ t1 ~& b* n; Y - }+ g% {8 W# J) z8 d8 O

- errno = EBADF; {9 k; _) _5 y+ E2 Q9 X% Z8 C' i

- return -1;

, s( `+ b. E0 t: e - }

+ n# x w2 l' U# O# G - int _close(int fd) {

* l7 K: I D. B, E4 U; L& O# f- x - if (fd >= STDIN_FILENO && fd <= STDERR_FILENO)

9 Q- q4 [. F0 x& y - return 0;" N: M5 Y( T# y* @1 Z9 n3 N

- errno = EBADF;- S' M$ H4 }; \! H$ G$ t. s

- return -1;

! K3 s7 A# F7 ]( S: h+ Q0 n - }/ k3 I% y& Y! G& v1 {

- int _lseek(int fd, int ptr, int dir) {

i6 [) {# y( r6 {1 u8 G/ i( _ - (void) fd;

9 [& g9 A+ B2 u9 }$ W( z - (void) ptr;

$ v7 ~" | I t; b! l - (void) dir;: [# a: y+ S4 Z0 q0 i' M2 Z1 S* _; D

- errno = EBADF;

( F; U3 {8 [1 ]7 r) ^ - return -1;

3 F2 x6 G- X. o7 ]' \' [ - }

9 e2 Z% r: s4 b* Q - int _read(int fd, char* ptr, int len) {

. o' p' [9 y% N3 G% V - HAL_StatusTypeDef hstatus; d) ~" w @7 V" v# H4 f3 a

- if (fd == STDIN_FILENO) {

! B2 ?* [# Z2 a- F - hstatus = HAL_UART_Receive(gHuart, (uint8_t *) ptr, 1, HAL_MAX_DELAY);

* a3 T O( @ V - if (hstatus == HAL_OK)" J% [) i& x8 j! z( p* L

- return 1;# B9 ^) R- ~, u3 Q7 G

- else

3 h4 _/ q$ ?- G, l H6 {4 p4 e - return EIO;% L7 K* G! C0 Q

- }# h7 s5 |% S; Z( _& d7 ]

- errno = EBADF;

" R- f' k- E( ^' P - return -1;

5 w6 Y Y" Y U* l - }

8 \- p% Y; t/ F( f A; C! H - int _fstat(int fd, struct stat* st) {

% d" ^8 G4 w/ `( l: I1 X - if (fd >= STDIN_FILENO && fd <= STDERR_FILENO) {6 t2 o* E0 o6 r" {$ p; c$ C

- st->st_mode = S_IFCHR;

9 c3 @7 p( u5 A# z H - return 0;

: u) J, a \" B# @, L+ I. r - }

/ Z( M( d# Y D9 W, o9 c - errno = EBADF;, y1 h* H2 C. m* F" K2 J5 w- T

- return 0;0 y4 t0 S' m+ M: ]

- }0 o L' g2 K9 P& s) q, [% h3 _5 W; \

-

/ |+ m4 Y4 x# T - #endif //#if !defined(OS_USE_SEMIHOSTING)

6 w8 e/ C, B! s usart.h( U3 @' J! w) u/ F9 x

- #ifndef INC_USART_H_

$ h c1 o) S9 l3 Y' C. K! ?; t - #define INC_USART_H_

' v( i! t, z0 _% `; L -

$ t6 t1 Y# l2 e - #include "stm32l4xx_hal.h" //HAL库文件声明

8 z4 z# x8 K2 U6 d, ?$ y. ~7 p - #include <string.h>//用于字符串处理的库! ^/ B; k$ F4 ?9 ?2 c0 V

- #include "../print/print.h"//用于printf函数串口重映射6 w) X/ V- S* |9 u

-

6 B+ A: `$ N0 D. @' g2 U - extern UART_HandleTypeDef huart1;//声明LPUSART的HAL库结构体

$ l0 k' i6 {/ k- l! l -

( q% K- }" ]7 E f, Y' l2 E - #define USART_REC_LEN 256//定义LPUSART最大接收字节数

# Z9 A( C' g( T9 b -

; a. q4 V3 t: Y5 b - extern uint8_t USART_RX_BUF[USART_REC_LEN];//接收缓冲,最大USART_REC_LEN个字节.末字节为换行符

% d9 \2 X0 U2 V3 A7 H; y7 @ V" t, O - extern uint16_t USART_RX_STA;//接收状态标记

6 \1 P6 V& t. W9 ^& \1 G$ t - extern uint8_t USART_NewData;//当前串口中断接收的1个字节数据的缓存* r- A5 p: ~# @8 _* f. G: ?

-

9 k+ z- N1 p7 L, `$ R& K9 g3 ^ -

( r5 _6 X6 h1 Z# s" C - void HAL_UART_RxCpltCallback(UART_HandleTypeDef *huart);//串口中断回调函数声明. g8 I% M( i2 F2 {7 V8 @

-

~ h0 Y) L+ F0 o1 j( ^) D - #endif /* INC_USART_H_ */

- i/ T) T' T0 t7 C usart.c如下:9 P1 Y% G* O) ?7 F5 g2 `

- #include "usart.h"

. }7 A' G2 o) U& |3 r: w -

- Q- |1 m$ H8 V0 W: x( F - uint8_t USART_RX_BUF[USART_REC_LEN];//接收缓冲,最大USART_REC_LEN个字节.末字节为换行符

' |3 Z+ R% g! O P! q# r; a: e - /*

+ q# y# b: {8 q" L - * bit15:接收到回车(0x0d)时设置HLPUSART_RX_STA|=0x8000;$ X) z; e: E+ Q2 \

- * bit14:接收溢出标志,数据超出缓存长度时,设置HLPUSART_RX_STA|=0x4000;! e/ s7 X( f! |- Y3 `1 l3 J! Y) y

- * bit13:预留

( @# H" y$ p# N, t' W - * bit12:预留8 F+ u+ x% t# o% R4 A j

- * bit11~0:接收到的有效字节数目(0~4095)

+ C/ n2 }! a# _7 k1 s3 ^; V - */' r: C5 R$ Q2 O4 n5 W

- uint16_t USART_RX_STA=0;接收状态标记//bit15:接收完成标志,bit14:接收到回车(0x0d),bit13~0:接收到的有效字节数目% x: h0 U5 j6 O5 Y

- uint8_t USART_NewData;//当前串口中断接收的1个字节数据的缓存

; F/ ?! I' \8 A% Y: d4 v, l- K6 P - 6 R/ W3 [( I& S4 Q5 ?3 d0 y6 l

- void HAL_UART_RxCpltCallback(UART_HandleTypeDef *huart)//串口中断回调函数

8 L6 r0 }, V# L3 T4 B$ J, u! Q6 K - {% X$ F# ~% f6 K4 S& j' {

- if(huart ==&huart1)//判断中断来源(串口1:USB转串口)' H% w/ i4 X: x9 D& ?0 l+ D- ` D

- {6 a8 c9 N5 h- ]

- if(USART_NewData==0x0d){//回车标记( r' ]4 ]7 {* B0 w: ?, s' t" w

- USART_RX_STA|=0x8000;//标记接到回车

4 P' @; ?% o6 e; o - }else{: {( ]- e. @3 l C: ^7 r8 J# |) t" N6 M, M

- if((USART_RX_STA&0X0FFF)<USART_REC_LEN){6 O: k* a5 t- s( M! B# A n

- USART_RX_BUF[USART_RX_STA&0X0FFF]=USART_NewData; //将收到的数据放入数组( N8 Q- S: _4 y& X* N b( q$ ]8 E

- USART_RX_STA++; //数据长度计数加1

i/ N* c2 g4 \ - }else{- c& J! Z/ J7 g( E% K( [

- USART_RX_STA|=0x4000;//数据超出缓存长度,标记溢出

+ V6 x% o7 t0 P* e9 j) v - }

3 D; ]6 l' i8 t - }

2 p0 D9 i: w/ B3 l - HAL_UART_Receive_IT(&huart1,(uint8_t *)&USART_NewData,1); //再开启接收中断, q( I/ A$ L* C) r

- }

) z) ]" ~& B6 k$ g2 S - }

7.3 c语言神经网络模型API使用

! o: g: W E6 ?# B2 x' x 先不管底层机理,本文给下面代码,看看如何实现这些API调用的,在main.c文件中,通过aiInit函数,实现har_ign模型初始化,并打印模型相关信息。在主函数循环体中,通过串口输入信息,获得数据生成因子,调用acquire_and_process_data进行输入数据生成,然后调用aiRun,并传入生成数据及输出缓存,进行神经网络模型调用。然后调用post_process打印输出信息。2 f" S; Q0 E% |, o! M2 a; D5 {

- /* USER CODE END Header */

, ?7 d; J9 R& l7 U" [ - /* Includes ------------------------------------------------------------------*/- \# \) t: A9 d7 U

- #include "main.h"

$ `$ W+ q! q. }& [1 G, u - #include "crc.h"; R3 f3 h1 w* ^7 B! k6 \

- #include "dfsdm.h"

" C; Y8 a' a0 P. A( I/ O - #include "i2c.h"3 b: j4 Z7 q0 L' i+ x$ |3 L' v

- #include "quadspi.h"7 N& \' V6 l- c3 Q' d$ e6 y* ^( V8 B

- #include "spi.h"( K- }+ b- `5 S0 B2 p1 ?+ L

- #include "usart.h"& e3 R: k/ v7 V/ ]) w

- #include "usb_otg.h"7 ^ V% f! S0 |4 X# d9 @- Q

- #include "gpio.h"! W8 D! x( K. A% v# p; b

- 0 }3 }. z: @* q5 b; v

- /* Private includes ----------------------------------------------------------*/

. G3 z8 h1 x* T/ L: X/ f - /* USER CODE BEGIN Includes */' t1 f. s/ I$ l! B

- #include "../../ICore/print/print.h"6 ~! ~/ D8 W, G, y) w. w

- #include "../../ICore/usart/usart.h"

3 x# w$ c# X( K6 B$ z - #include "../../X-CUBE-AI/app/har_ign.h"& @8 [; l- @* i& L4 w

- #include "../../X-CUBE-AI/app/har_ign_data.h"

" M) Y. Z y$ | n0 @8 L - /* USER CODE END Includes */0 u0 i3 B* I! H0 L8 B6 R2 i( p

- 9 i& w* N7 W) H/ I

- /* Private typedef -----------------------------------------------------------*/

3 _3 i3 e) h# p1 z" x: L: N - /* USER CODE BEGIN PTD */

) @+ c- j7 z8 h5 A* I; k - 3 @& e2 `/ j8 ~; a9 s* ]& o

- /* USER CODE END PTD */

1 E, Q# ]2 C. \ -

" z7 `+ ~6 ]- J0 N; k4 K/ o - /* Private define ------------------------------------------------------------*/

' e7 d* | S% G' i# K" j, I W - /* USER CODE BEGIN PD */

" J; Y* O) h; u) H - /* USER CODE END PD */8 ^8 I7 R' H: J8 y: _& F

-

/ y( V: @3 X. v# t7 |" M - /* Private macro -------------------------------------------------------------*/- j* S$ b! T1 F

- /* USER CODE BEGIN PM */

# y$ e8 k1 i# O* b! g) B - 9 t7 O1 T+ E# Q- M# v% T: d; Q

- /* USER CODE END PM */

6 T/ X1 @0 }& {$ F+ L) Y4 l8 j- t! r - ' ]! z% O- N0 |2 i. n

- /* Private variables ---------------------------------------------------------*/. { m/ R0 b8 y* Y# F) u6 Z0 v4 U

-

' B. S! Z: ?6 x G( c \ - /* USER CODE BEGIN PV */

4 N4 W$ K; z, ~ - / ?5 P3 V& |' H. ^) l

- /* USER CODE END PV */

4 J, r+ Y+ u( {8 S% M9 k9 G - 3 e7 X* Q! X0 w4 ]9 b9 e! c1 f- Q5 V5 o

- /* Private function prototypes -----------------------------------------------*/) A/ X' s, e8 Y% U

- void SystemClock_Config(void);, x& f0 J" e8 a) y3 D

- /* USER CODE BEGIN PFP */

2 a$ w1 L a- v) @: F9 K -

6 Y! A% a$ W' _ - /* USER CODE END PFP */9 @+ P3 r/ t3 u4 m1 T! r

- F2 i+ r3 G2 R, h2 ?

- /* Private user code ---------------------------------------------------------*/: K7 {9 |& S3 i, g8 n

- /* USER CODE BEGIN 0 */) T7 L8 H' A4 v. }6 y: L

- /* Global handle to reference the instantiated C-model */8 N, M- \5 ^. o" u5 D

- static ai_handle network = AI_HANDLE_NULL;

/ O; Z, y4 p% X -

' H( R; E$ V3 o" z( v - /* Global c-array to handle the activations buffer */# A0 H: L# N- z

- AI_ALIGNED(32)3 C3 J8 B( {# I' B7 J$ y6 u

- static ai_u8 activations[AI_HAR_IGN_DATA_ACTIVATIONS_SIZE];: D% S7 I+ d- b7 a/ i K4 \0 d% t

-

4 f A0 M) V- L% G' h - /* Array to store the data of the input tensor */) u& i8 F. |) E# I

- AI_ALIGNED(32)

+ X; _2 }4 e4 _% q( r - static ai_float in_data[AI_HAR_IGN_IN_1_SIZE]; _# J( d% J" W" e8 ?; ?0 B5 y

- /* or static ai_u8 in_data[AI_HAR_IGN_IN_1_SIZE_BYTES]; */

& v5 w! a7 V: x0 z# D u - % I/ w2 Q7 j2 b5 N/ ] {9 i+ S

- /* c-array to store the data of the output tensor */

# z' S, C' z7 G9 j. k% O' F - AI_ALIGNED(32)

. {- [. h" x- b2 M5 M. A - static ai_float out_data[AI_HAR_IGN_OUT_1_SIZE];

7 Z, s5 x/ \7 F( ^ - /* static ai_u8 out_data[AI_HAR_IGN_OUT_1_SIZE_BYTES]; */

; Y2 z4 Y. s7 M% g! g$ T -

1 P- }+ P; R8 R; j( X/ s, _ - /* Array of pointer to manage the model's input/output tensors */

9 |! J* |! o9 D" Q" Y3 O# q, V" c5 ` - static ai_buffer *ai_input;/ M( a( y4 y/ K! j

- static ai_buffer *ai_output;

4 Z" c* D- z t9 q5 W0 U - static ai_buffer_format fmt_input;

. l0 w7 d; }2 d - static ai_buffer_format fmt_output;

6 V, {. u0 I& j- k% T- s: U* b, O - % L7 J# {) `- W" t3 {

- void buf_print(void)

3 _( _1 s, N1 }- M: c6 V5 m - {

! U& O) {7 m# `% l) |+ c - printf("in_data:");; @" O7 T: |5 q' |7 ~

- for (int i=0; i<AI_HAR_IGN_IN_1_SIZE; i++)* q5 ~2 [& k2 n" U2 z5 d

- {

; @0 w0 t1 B: } - printf("%f ",((ai_float*)in_data)[i]);6 b/ f% {5 L/ I6 e5 |! u: ]

- }

% c8 w3 W K) l7 r+ O! t - printf("\n");

% \0 B3 K$ C* P* R- ^ - printf("out_data:");

0 i1 C% I; l/ Y1 v+ d: S6 Z - for (int i=0; i<AI_HAR_IGN_OUT_1_SIZE; i++)

% r# D, o+ h* X* D$ V& c - {$ U+ M4 I; ?9 D! P$ b: l

- printf("%f ",((ai_float*)out_data)[i]);

; X- f2 L# z' ]/ A - }! u) @; t& b6 n3 J

- printf("\n");

6 r2 M4 J9 T( ` - }. o- V- \# Z9 C) f/ C0 q

- - B% ]4 ~4 o4 ]* s/ T

- void aiPrintBufInfo(const ai_buffer *buffer). F, u0 |* F A9 I+ F" z9 T

- {" r1 Y Y7 ?3 Q9 ^" w

- printf("(%lu, %lu, %lu, %lu)", AI_BUFFER_SHAPE_ELEM(buffer, AI_SHAPE_BATCH),

4 x+ D8 G. @# i& u - AI_BUFFER_SHAPE_ELEM(buffer, AI_SHAPE_HEIGHT),

% l& p8 e! N# l7 y7 ? - AI_BUFFER_SHAPE_ELEM(buffer, AI_SHAPE_WIDTH)," r- v6 ^5 B) s" G# l

- AI_BUFFER_SHAPE_ELEM(buffer, AI_SHAPE_CHANNEL));

: r1 `+ m8 j3 {: O) f6 j9 | - printf(" buffer_size:%d ", (int)AI_BUFFER_SIZE(buffer));& p$ s5 Q& F9 j/ G2 e! y

- }" L3 h R% T. Q& K, A* x

- ( N3 O( I$ N: F' N2 V

- void aiPrintDataType(const ai_buffer_format fmt)3 U' D( b' k3 U, j4 }0 e

- {

# o! R0 r; j, E/ \+ P- F - if (AI_BUFFER_FMT_GET_TYPE(fmt) == AI_BUFFER_FMT_TYPE_FLOAT)

: X- i4 i4 h" M# Y5 z! V+ r - printf("float%d ", (int)AI_BUFFER_FMT_GET_BITS(fmt));

! }& ^, @2 g1 o& b) v - else if (AI_BUFFER_FMT_GET_TYPE(fmt) == AI_BUFFER_FMT_TYPE_BOOL) {6 P: S$ ]2 h2 W% s

- printf("bool%d ", (int)AI_BUFFER_FMT_GET_BITS(fmt));

0 V! ~( O: K5 F - } else { /* integer type */; y1 M" O$ J: I! O, v0 f1 k3 |

- printf("%s%d ", AI_BUFFER_FMT_GET_SIGN(fmt)?"i":"u", B7 j/ w- |$ t2 N

- (int)AI_BUFFER_FMT_GET_BITS(fmt));

; x( r3 d; C( [ - }1 M( E4 M# J \# H& h2 l# D6 Y" D

- }6 p8 G) q. z8 e+ g( n* H

-

3 W K( K+ b; ~" N, ~) s - void aiPrintDataInfo(const ai_buffer *buffer,const ai_buffer_format fmt)

* F2 L+ v! w6 z, t0 r - {; Y3 q, F8 R; T, b: U

- if (buffer->data)3 G$ i& w! S7 D9 Z: p% s

- printf(" @0x%X/%d \n",! x+ M0 }; N% W

- (int)buffer->data,6 c# \& x6 U% \ K, @: Z

- (int)AI_BUFFER_BYTE_SIZE(AI_BUFFER_SIZE(buffer), fmt)$ {' |5 ]" o9 k) \: J1 m: Z

- ); A9 r( G, z8 B0 Q7 ?. f

- else

) q& D2 e; ?% ~ S4 c( m - printf(" (User Domain)/%d \n",

$ P* I& Y% h. L1 Y4 _& @ - (int)AI_BUFFER_BYTE_SIZE(AI_BUFFER_SIZE(buffer), fmt)

( s9 B1 q5 H" g/ W2 V5 _: W: G: b - );

7 ?3 z$ ^6 A2 A; ^2 C - }$ S" K9 k2 ^7 \% N" \" S) v

- * q3 u1 n7 ]; V2 G) x$ N- Z8 e0 U

- void aiPrintNetworkInfo(const ai_network_report report)) u: O0 c' |5 k" w# g

- {

. l% `3 Y& g2 @1 j - printf("Model name : %s\n", report.model_name);

5 {9 d/ z" f0 D5 [$ F; [6 X; U - printf(" model signature : %s\n", report.model_signature);

* q l) P) G9 M3 p6 I5 @ - printf(" model datetime : %s\r\n", report.model_datetime);

/ M, D- d3 t$ S - printf(" compile datetime : %s\r\n", report.compile_datetime);

/ X; n" b9 p! s* P' e$ I - printf(" runtime version : %d.%d.%d\r\n",: ~( ?. O. H% p* v

- report.runtime_version.major,, E( Q2 u1 N3 t1 P

- report.runtime_version.minor,

- P) z6 f/ U6 K! i6 F+ O7 g& ] - report.runtime_version.micro);$ ]% D3 O5 F; Z( c

- if (report.tool_revision[0])

* g3 Z+ R. _' c6 j1 R7 O5 M7 L - printf(" Tool revision : %s\r\n", (report.tool_revision[0])?report.tool_revision:"");

$ W5 W$ H4 a" q: b' i; t3 Y" P - printf(" tools version : %d.%d.%d\r\n",

3 K( A0 D& ~+ A) X% [' N - report.tool_version.major,- O: _8 P. e7 \8 m

- report.tool_version.minor,

6 K9 F) p4 C, c( F% Y3 j - report.tool_version.micro);: Q% z! u* I$ g

- printf(" complexity : %lu MACC\r\n", (unsigned long)report.n_macc);

( K5 z" Y: W' c3 h: b! l9 S - printf(" c-nodes : %d\r\n", (int)report.n_nodes);

% O2 Q# T- v- t2 Q+ Q" N - : B* E: g: f2 h2 u

- printf(" map_activations : %d\r\n", report.map_activations.size);& A7 C- W) i& ]7 P& C' B

- for (int idx=0; idx<report.map_activations.size;idx++) {6 U4 c2 `7 }; u& C+ B

- const ai_buffer *buffer = &report.map_activations.buffer[idx];

/ F$ z+ B( h0 [9 v - printf(" [%d] ", idx);

" N9 b+ C* M3 D* I0 B2 ? - aiPrintBufInfo(buffer);

" M; R0 G: } d& J - printf("\r\n");% k/ H; z) m: h% v) L2 s1 J, l" x. S

- }

% V$ l* s: s' x! J7 S; w8 X, D) @& O - 5 \9 t+ N; B( x O; t$ d3 ~# h

- printf(" map_weights : %d\r\n", report.map_weights.size);/ N7 w# g1 \: S7 l

- for (int idx=0; idx<report.map_weights.size;idx++) {

: |( N' t; L4 N9 X - const ai_buffer *buffer = &report.map_weights.buffer[idx];$ B" u3 G/ H6 {, l% Z! {3 z0 W* W

- printf(" [%d] ", idx);

9 k2 ^/ f) r7 a% J - aiPrintBufInfo(buffer);

1 j; R4 f4 b# G9 Q - printf("\r\n");

$ `" y) L! @! X# v - }6 r* \+ j E9 c1 }9 d8 Y

- }3 U+ J; s2 W6 R" B+ ^

- * e% e* J1 @3 s- W5 y* k

- /*/ t. w4 H) Z. ?* |9 t

- * Bootstrap. j9 j. D! M. w, _3 D

- */

% J& L, N3 n5 l& | - int aiInit(void) {' d7 u( I/ s0 J: }: B

- ai_error err;6 R5 v, \. b8 e6 D' O

- 6 v5 M/ r7 {6 | _( f* Q1 [' B5 {& Q

- /* Create and initialize the c-model *// O" j) P& d0 h3 b/ o; E( d

- const ai_handle acts[] = { activations };

( E: Q2 i. y. v8 T6 M) W+ O' a) R - err = ai_har_ign_create_and_init(&network, acts, NULL);+ b6 \* b& b% C w

- if (err.type != AI_ERROR_NONE) {* m% E! w. G5 T! k! R' N

- printf("ai_error_type:%d,ai_error_code:%d\r\n",err.type,err.code);

$ {: `6 I0 u& ^; A* K) H" U) D) d - };

6 h6 L8 K3 G# M0 j9 A) u - 8 p+ C, C& F/ c" Q

- ai_network_report report;

2 f! |% d& z2 q7 t% `3 @" r" e - if (ai_har_ign_get_report(network, &report) != true) {

5 p4 [' u% Z7 q" p, R4 A1 y7 d - printf("ai get report error\n");

5 j9 v# C+ D$ }9 N5 c: N - return -1;

/ S; A8 @ s2 B - }

! T9 e4 K8 j! z - ! c) Z- B$ I7 w; @% ?/ B3 R8 n% a

- aiPrintNetworkInfo(report);

. L, Z$ f3 s6 f4 D |. l; K4 E* N - 7 L* j" @, F6 I! ~# g2 Q" h' X

- /* Reteive pointers to the model's input/output tensors */

* x% }+ G% O5 B2 @& Y% A7 n0 w - ai_input = ai_har_ign_inputs_get(network, NULL);/ U' L+ d9 H! w+ B8 x# N

- ai_output = ai_har_ign_outputs_get(network, NULL);) ^- O) d# e3 K( \0 [

- //+ v# l: F' t& ]& @! v

- fmt_input = AI_BUFFER_FORMAT(ai_input);# O& F. c: N1 j; l8 q9 u& j- x

- fmt_output = AI_BUFFER_FORMAT(ai_output);4 e, Z- X4 g+ U( x% w/ |, r

- 2 l* h" |* `, A, |" r# U J# f

- printf(" n_inputs/n_outputs : %u/%u\r\n", report.n_inputs,& V1 @; n) S0 S$ G# z6 z, a( d: q

- report.n_outputs);

7 ^- |2 b" @. S* D" Y+ [& R5 r& A - printf("input :");

6 J1 j, ^5 a5 O - aiPrintBufInfo(ai_input);

/ ^$ p4 j( ^- \- ~; L+ s- S+ e, g$ I - aiPrintDataType(fmt_input);

# @5 S! A+ U$ n+ u - aiPrintDataInfo(ai_input, fmt_input);! {7 b7 F% n/ b3 H

- //

( Z6 l& q$ U2 N3 i/ X - printf("output :");

2 S: B! s0 ~6 X _! K - aiPrintBufInfo(ai_output);

& N2 Z/ h6 f- O1 E; q - aiPrintDataType(fmt_output);5 T* S4 N- Y- @& D* h

- aiPrintDataInfo(ai_output, fmt_output);" V% m! B0 P% r- T/ H$ j

- return 0;

9 K- }' j# I, i( Y - }* O0 P. X0 b+ G8 D. D* s

-

: a1 ~6 |9 Z. b, Q2 \ - int acquire_and_process_data(void *in_data,int factor)6 P" @4 ~$ b g) V) e0 d& _

- {

' u$ K- G E$ h - printf("in_data:");- V, E0 e6 Y& C

- for (int i=0; i<AI_HAR_IGN_IN_1_SIZE; i++)

* X Y ?4 o5 q0 p( b3 p m; J' s$ ? - {5 g, [' P2 y$ p3 V( B6 I2 i8 y

- switch(i%3){

8 @: O, v g$ Q& F - case 0:

5 v- ?% P) U, F0 G - ((ai_float*)in_data)[i] = -175+(ai_float)(i*factor*1.2)/10.0;, |; j$ F0 |5 H5 @, `5 }

- break;- Q/ ^8 x2 i. N/ }( M4 Q) m

- case 1:

9 a, v1 [9 c5 z s - ((ai_float*)in_data)[i] = 50+(ai_float)(i*factor*0.6)/100.0;

; A |, X+ C# f' K" @ - break;

Y6 T$ c9 ^- X {5 Y; G9 \4 f - case 2:

; ]* J- |% q$ }4 d; t/ X6 j - ((ai_float*)in_data)[i] = 975-(ai_float)(i*factor*1.8)/100.0;

) A; H0 D: X } - break;

4 j' ] {. }. w; d2 c* j - default:

# A3 i% Y7 M+ N5 h, ]. c' z) K - break;

! V6 X/ a8 k9 m8 n5 d3 r; M3 D! I - }

@/ m2 I$ e: J1 ` - printf("%f ",((ai_float*)in_data)[i]);