|

【嵌入式AI入门日记】将 AI 模型移植到 RT-Thread 上 & [7 P8 h+ [( g* o以下文章来源于RTThread物联网操作系统 ,作者lebhoryi&summer

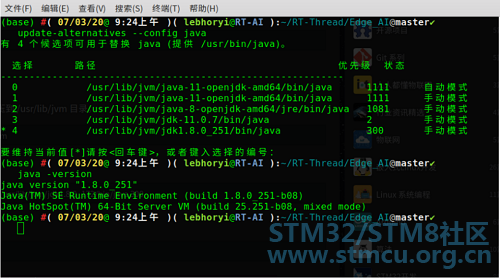

“本期我们分享的主题是如何将 AI 模型部署到嵌入式系统中。” 嵌入式关联 AI AI落地一直是一个很红火的前景和朝阳行业。我的好奇心也比较旺盛,所以关于任何嵌入式和 AI 相关的都是想尝一尝。本系列文章将带你一步一步把 AI 模型部署在嵌入式平台,移植到 RT-Thread 操作系统上,实现你从菜鸟到起飞的第一步甚至第 n 步! 开发环境: 后续开发过程将基于 STM32H743ZI-Nucleo 开发板,并且使用 STM32CubeMX.AI 工具。它可以基于训练好的 AI Model (仅限 Keras/TF-Lite),自动生成嵌入式项目工程(包括但是不局限于 MDK、STM32CubeIDE 等)。该工具易于上手,适合嵌入式 AI 入门开发。 STM32CubeMX 是 ST 公司推出的一种自动创建单片机工程及初始化代码的工具,适用于旗下所有 STM32 系列产品,现在其 AI 组件可以提供 AI 模型到嵌入式 C 代码的转换功能。 9 x- Z, c; s( R1 l; w0 x. D4 {" r2 B 1. 准备工作 1.1 安装开发环境 笔者用的操作系统是 Ubuntu 18.04。本次实验要用到如下开发工具,软件的安装过程很简单,网上都有很成熟的教程,在此不再赘述。该篇教程同样适用于 Windows 环境,实验步骤完全相同。 STM32CubeMx STM32CubeIDE STM32CubeProgrammer 1# Oracle 官网中下载 JavaSE JDK 压缩包 2$ sudo tar zxvf jdk-8u172-linux-x64.tar.gz -C /usr/lib/jvm" Q4 x. I1 C' V3 Z. a+ A 3# 将下载的JDK注册到系统中0 \- Q3 [ ?8 C, g8 O6 \1 ?9 A 4$ sudo update-alternatives --install /usr/bin/java java /usr/lib/jvm/jdk1.8.0_172/bin/java 300 5# 切换JDK 6$ sudo update-alternatives --config java 7# 查看JDK 版本- ?- I$ e# E" p4 B! \ 8$ java -version

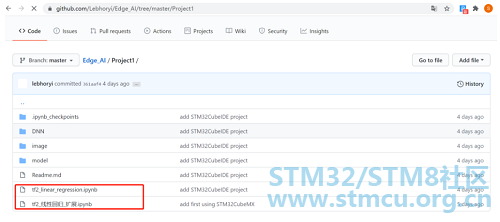

1.2 在 PC 端搭建极简神经网络 首先将如下开源仓库克隆到本地: M& E; U: v B3 A' J) g

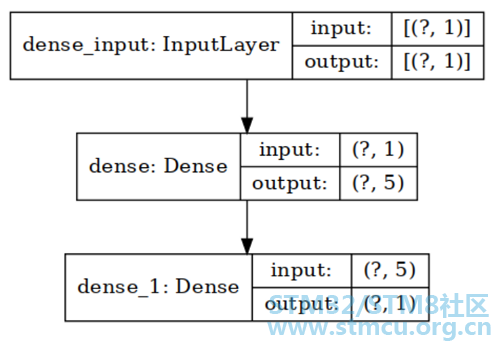

在本次实验中我选择了最简单的一个线性回归( Linear Regression)Tensor Flow2 Demo 作为示例,模型相关源文件说明如下: · tf2_linear_regression.ipynb 内含三种不同方式搭建网络结构 · tf2_线性回归_扩展.ipynb 内含不同方式训练模型 其中,在模型搭建的时候,重新温习了一下,有三种方式(各个方式的优缺点已经放在参考文章当中,感兴趣的同学自行查阅): · Sequence · 函数式 API · 子类 后面将 AI 模型导入到 CubeMx的过程中,如果使用后两种方式生成的网络模型,将会遇到如下报错: 1INVALID MODEL: Couldn't load Keras model /home/lebhoryi/RT-Thread/Edge_AI/Project1/keras_model.h5, 3 b% d$ T/ v# Z, E + }) i* N+ e4 r$ T# @2error: Unknown layer: Functional 暂时的解决方式是采用Sequence 方式搭建神经网络,训练好的 AI Model 会被保存为 Keras 格式,后缀为 .h5,例如 keras_model.h5。 示例模型我已经保存好了,大家可以直接下载该模型进行实验,下载地址如下: 3 L- @- U: J2 y8 d: v本次示例所训练的神经网络模型结构如下: 0 ^7 F2 K) Q8 Q1 _

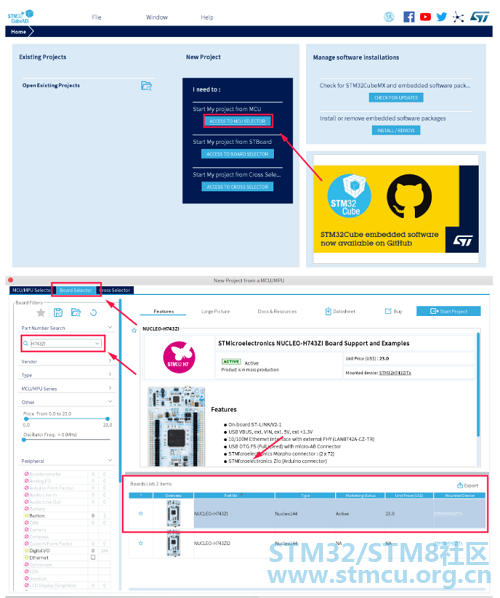

2. 使用 CubeMX AI 生成工程 在 CubeMX 中选择STM32H743ZI Nucleo 开发板,这里其实不限制开发板型号,常见的 + \* }5 ^4 H% w" a 2.1 打开 CubeMX

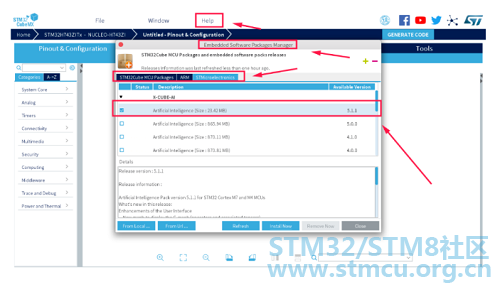

2.2 安装 CUBE-AI 软件包 打开菜单栏中的 Help,选择Embedded Software Packages Manager,然后在STMicroelectronics 一栏中选择 X-CUBE-AI 插件的最新版本,安装好之后点击右下角的 Close。 在工程中导入 X-CUBE-AI 插件:

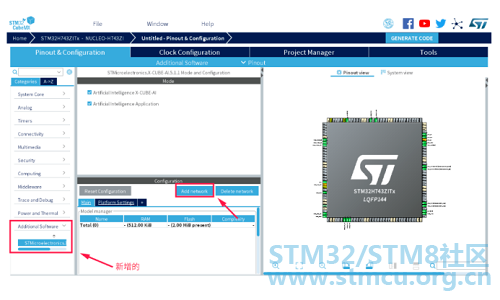

会出现如下界面: 4 Q$ q& S5 U& w( c" F h9 @

接下来选择用于通信的串口,这里选择串口 3,因为该串口被用于 STlink 的虚拟串口。 ( ^4 o) W" H- b! w

2.3 导入 AI 模型到工程中

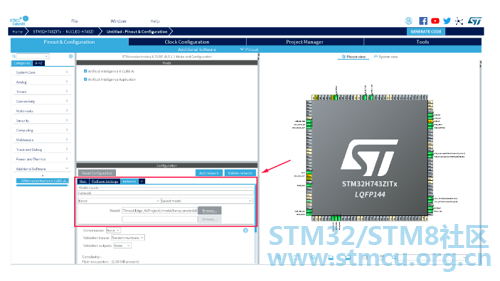

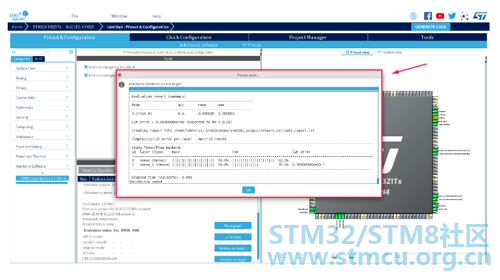

将 AI 模型烧录到开发板前,需要先分析 Model,检查其是否可以被正常转换为嵌入式工程,本次实验使用的模型比较简单,分析起来也也比较快,结果如下所示: ) v1 \5 A* r4 ~% u$ G/ G- G

接下来我们要在开发板上验证转换后的嵌入式工程,在这个过程中 CubeMX AI 工具会根据你导入的 AI 模型,自动生成嵌入式工程,并且将编译后的可执行文件烧录到开发板中,并通过STlink 的虚拟串口验证运行的结果。我的系统是 Ubuntu,不支持 MDK,所以在这里选择自动生成 STM32CubeIDE 工程。

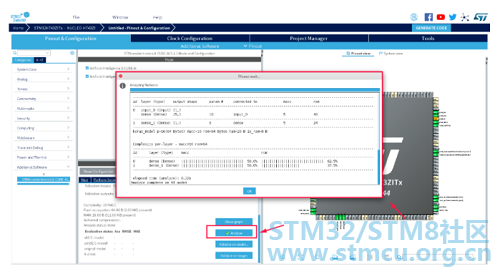

验证成功界面如下所示:

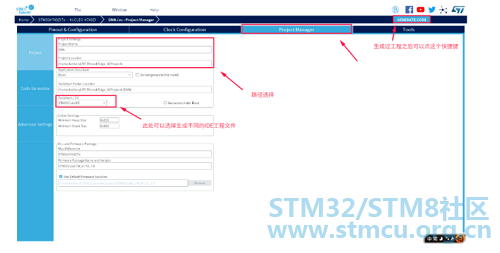

2.4 生成项目工程 上一步我们只是进行了项目结果的验证,但是并没有生成项目源代码,接下来我们将生成项目工程,如下图所示:

生成后的 Project 文件夹树如下所示: 1(base) #( 07/03/20@10:51上午 )( lebhoryi@RT-AI ):~/RT-Thread/Edge_AI@master✗✗✗ 2 tree -L 2 ./Project1 3./Project1 4├── DNN # CubeMX 生成工程路径 5│ ├── DNN.ioc # CubeMX 类型文件 6│ ├── Drivers- K6 f9 `, F1 s- u3 y 7│ ├── Inc* Z/ l2 x) J' n5 q 8│ ├── Middlewares0 e' g' F# _+ F, S 9│ ├── network_generate_report.txt& \7 } o6 v: ], P( q8 g5 t( z 10│ ├── Src# T# ]: ?( [% [) F5 I" q$ v 11│ ├── Startup4 n9 a+ @$ I0 m& \" J2 s$ `9 e% M 12│ ├── STM32CubeIDE( n. a6 r! _, }+ K4 h* s 13│ ├── STM32H743ZITX_FLASH.ld4 H, z( p! s8 o" H. j8 h" i/ f 14│ └── STM32H743ZITX_RAM.ld 15├── image # 相关图片保存文件夹4 {1 {: Q! D |6 u9 _( S. E7 W0 o4 ] 16│ ├── mymodel1.png # model 17│ └── STM32H743.jpg # H743+ `) M8 e/ l8 O 18├── model # model 保存路径 19│ └── keras_model.h5+ I, i7 j l) p! l+ W( ? 20├── Readme.md 21├── tf2_linear_regression.ipynb1 A: J- g4 Z4 P2 n( J/ { 22└── tf2_线性回归_扩展.ipynb 至此,神功练成了一大半,剩下的就是代码调试的工作了。 3. 代码调试 关于 STM32CubeIDE 的初步认识:基础说明与开发流程:http://blog.csdn.net/Naisu_kun/article/details/95935283 3.1 导入工程 选择 File 选项 -->import:

选择先前导出工程的路径: 0 n+ f8 s: u, P+ p- x5 a7 c

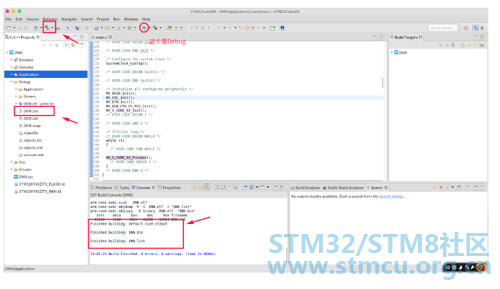

导入成功的界面如下所示: 6 O9 X. w0 E) t7 b/ Y7 t1 m" T

接下来就可以使用 STM32Cube IDE 来调试生成的工程了。 ' @* x! D, F+ q 3.2 生成 bin 文件 在编译的过程中还会自动生成相应的 bin 文件,后续可以通过 stm32cubeProgramer 工具将 bin 文件烧录到开发板中。 : ]9 I# P6 _, w/ o& Z y# P

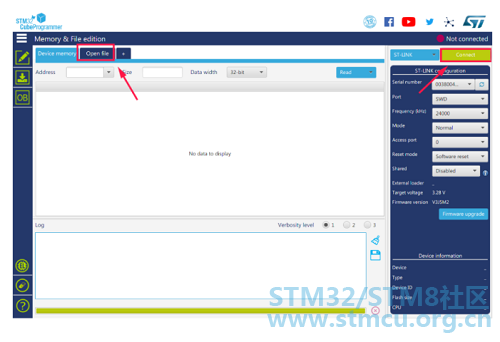

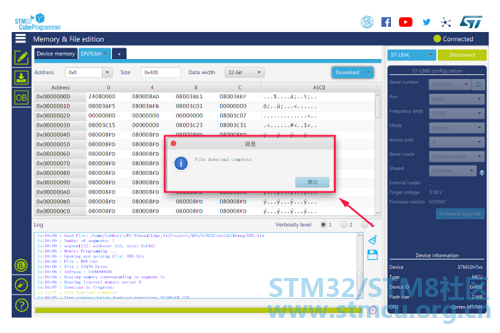

3.3 烧录 .bin 文件 打开STM32CubeProgramming,点击右上角connect,然后选择Open file,选择要打开的.bin 文件。 ( G, ^3 [6 y6 r( O. \+ p0 P

烧录成功的界面: ' Q$ ~ M( L" d/ d, t" B, D( i

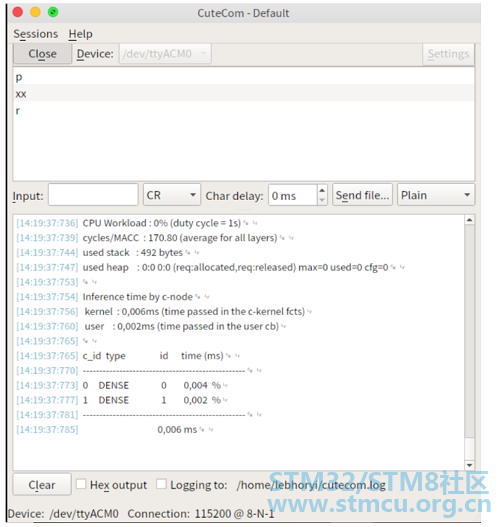

3.4 Other 在 ubuntu 系统中我们可以使用串口工具cutecom 来查看最终程序的运行结果,程序运行结果如下: 在使用 cutecom 连接串口前,记得断开 STM32Programer 和开发板的连接,否则会出现串口打开错误的情况。 # S B) S+ N" ?. b% m' I$ n. a7 }; U

可以看到我们的 AI 模型已经在开发板上欢快地跑了起来 ,奥里给!!! z+ n: p" x' X) l2 j6 ~: ~& ] p 4. 参考文章 $ f9 a2 o' y( E- ?. u. ^$ KSTM32CubeMX系列教程 Tensorflow 2.0 中模型构建的三种方式: |

| 为什么图片这么模糊 |

| 赞一个 |

| 学习学习 |

| 我想问一下,我打算把运行成功的AI程序移植到我其他的程序里,发现新移植好的程序陷入了汇编指令B,也就是死循环,程序是运行到ai_platform_network_create这个创建网络的函数死了,应该是无法执行到这个函数,请问这个是什么问题呢 |

| 还要看运算速度如何。 |

【STM32N6570-DK评测】1.开箱测评

【STM32N6570-DK评测】1.你好N6

实战经验 | STM32 AI Model Zoo 的安装及实例介绍

【STM32H7S78-DK评测】移植AI框架TensorFlow【DSP指令加速篇】

【STM32H7S78-DK评测】移植AI框架TensorFlow【下篇】

【STM32H7S78-DK评测】移植AI框架TensorFlow Lite【上篇】

【STM32H7S78-DK评测】移植边缘AI推理框架——TFLM(TensorFlow Lite for Microcontrollers)上篇

破解边缘AI硬件与软件挑战,意法半导体解读三大创新要点

意法半导体助力企业产品智能化,加快边缘人工智能应用

STM32不至于芯,2023济南站研讨会

微信公众号

微信公众号

手机版

手机版