.png) 奇迹

发布时间:2022-10-31 11:43

奇迹

发布时间:2022-10-31 11:43

|

在经历完各种准备工作后,现在终于来到了正主。直接部署Tensorflow Lite Micro那一套玩意确实没啥问题,但是太麻烦,要添加一大堆文件,还得用它家训练生成模型,然后转换,麻烦的很,在ST平台,怎么能不提到用ST自家工具去部署模型,方便快捷,简单实用。 拿出之前准备的工程,选取ai开发需要支持的软件包cue-ai,在software packs点select components

在X-CUBE-AI行下core勾选,点OK完成

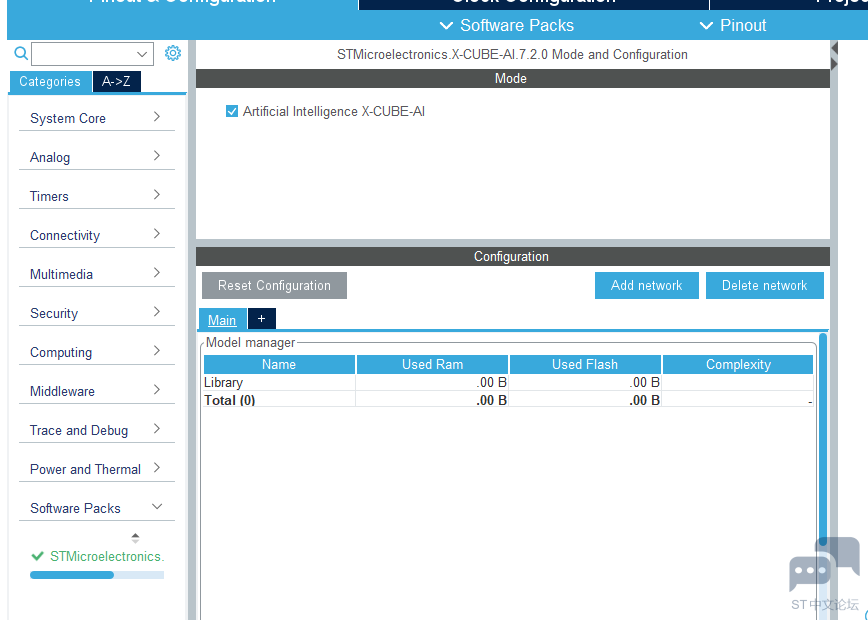

回到引脚配置页面,最下方就是上面导入的CUBE-AI工具包

点击+添加,这里要根据自己使用的模型,以及模型特点选择,如下图选择的是原始模型

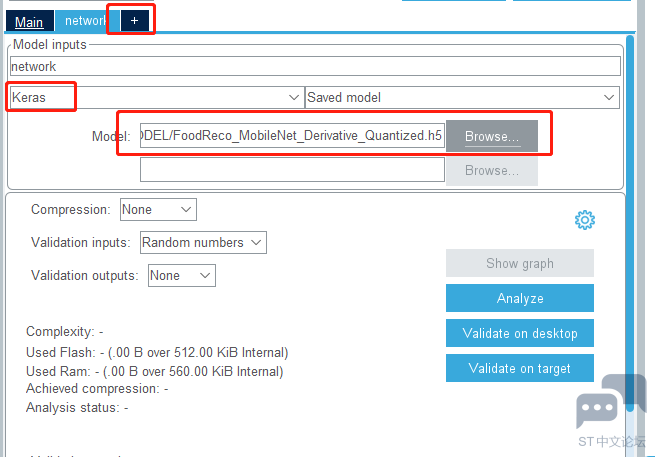

这里选择的是量化后的模型(量化可以减少模型的要求,但是精度会下降),点击分析

分析中

分析完成会显示是否可以部署到设备上,以及资源使用情况。

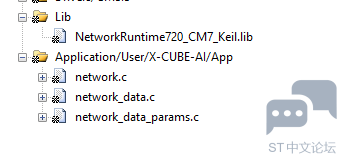

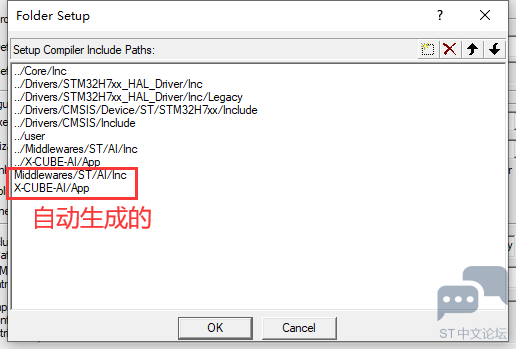

回到工程,有个小bug(使用的STM32CubeMX版本为6.6.1,X-CUBE-AI版本为7.2.0),下图的几个文件路径老是生成错

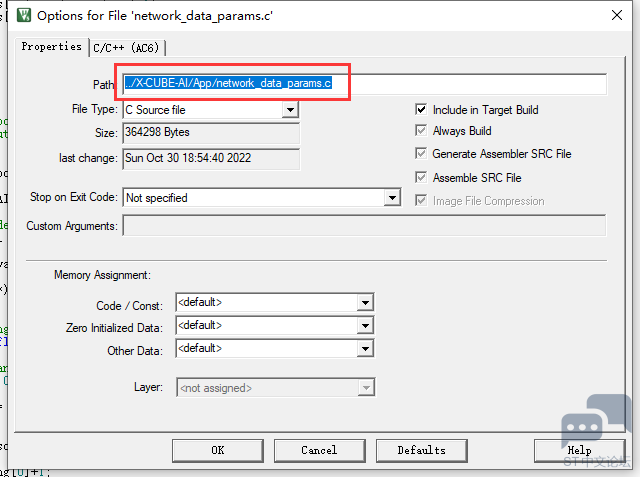

右键文件打开设置,修改一下路径就行

头文件路径也有一样的问题

初始化模型

运行模型

图像接收处理,这个模型要求输入224*224的RGB888的图像,把数据转换一下。

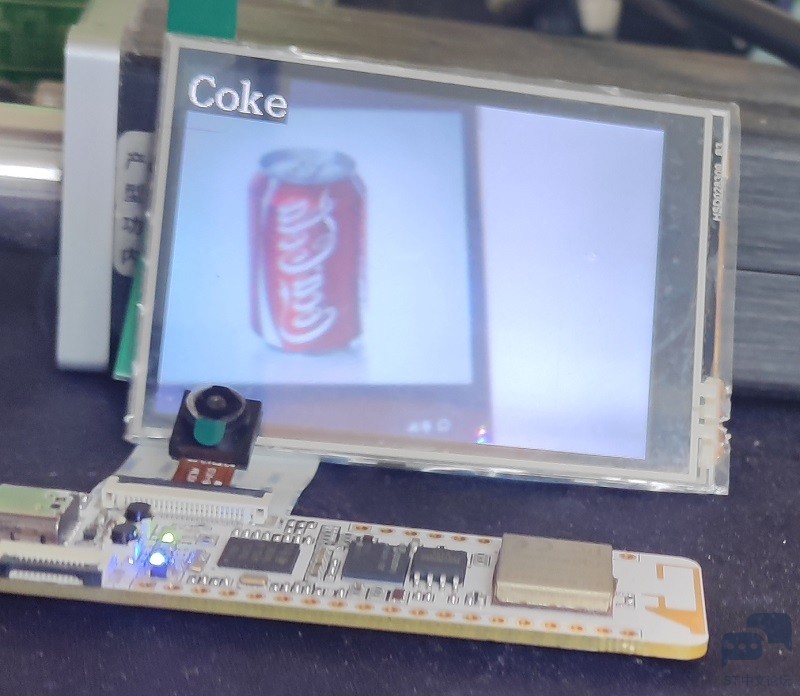

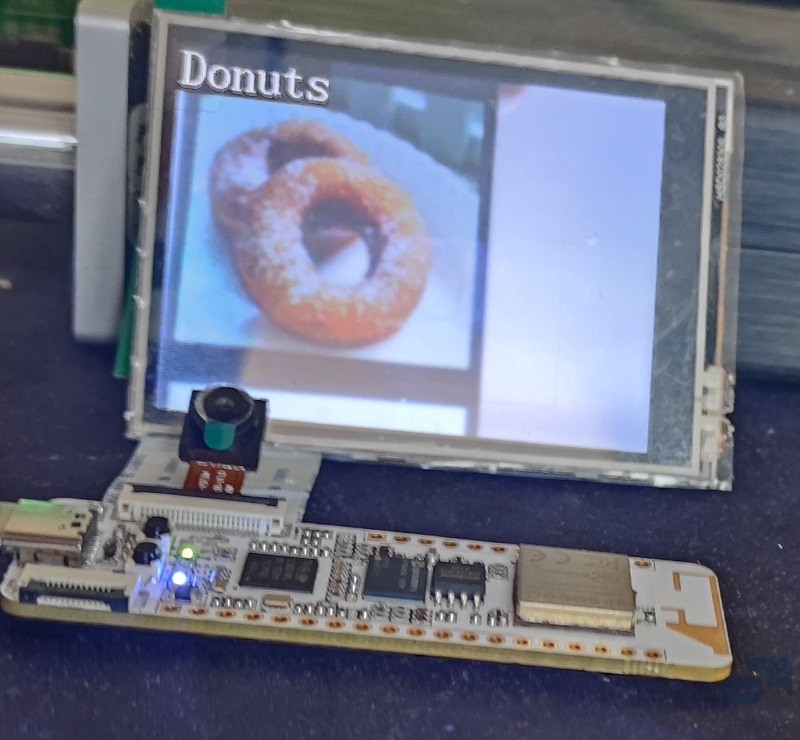

运行效果(一共能识别18种食物,这里选了几个看看) 空

可乐

甜甜圈

汉堡包

薯条

小结:STM32Cube.AI工具真的太香了,这里仅仅演示了模型的部署,其实可以快速验证AI模型在目标板上的运行情况,只用串口连接,直接把输入发送到单片机,然后运行完后把结果返回来,全部都集成到了一起,快速验证模型运行情况。很是方便(本文未涉及,有需要的可以在X-CUBE-AI行下勾选时,application里面选择validation,回到配置界面后设置通信接口即可) Wio Lite AI视觉开发套件确实是开发AI的很好的选择之一,板子虽小五脏俱全,拿来做单片机视觉绰绰有余,但是不得不吐槽的一点是资料支持太差了,原理图,代码全都藏起来,前期调驱动花了很长的时间,后来管管给了一个例程后好转了一些(但是已经晚了。。。),Ai在单片机上应用已经有很多厂商都推出类似的解决方案了,ST这一个环境很优秀,就是如果相关的培训跟资料再多一点就好了。 |

经验分享 | STM32H723 SPI 通讯异常排查:实时观察窗口的 “隐形干扰” 解决方案

经验分享 | STM32H7 SPI NSS 脉冲模式灵活应用:解决外置 ADC 通信干扰问题

经验分享 | STM32H7 双核调试配置:STM32CubeIDE 下 M7+M4 协同调试实操

经验分享 | STM32H7 TouchGFX 花屏速解:更换 HyperRAM 后 latency 值适配实操

经验分享 | STM32H743 BDMA+LPTIM+LPUART应用演示

经验分享 | STM32H7Sx MCE 加密解密:外部存储安全防护全解析

如何在STM32和Arduino上实现卷积神经网络

详解STM32单片机的堆栈

兔哥心中的ST中文论坛

STM32 开发者指南:ST.com 全新 MCU 产品阵容视觉布局深度解析

微信公众号

微信公众号

手机版

手机版

up有没有原理图资料~

求求了

[md]好久之前做的了,资料都忘了放哪里了。。。你可以在网上找找,或者找卖家要

up 有更详细一点的建文件工程的教程吗? 还有模型怎么弄上去, 求解

按这个文章操作就行