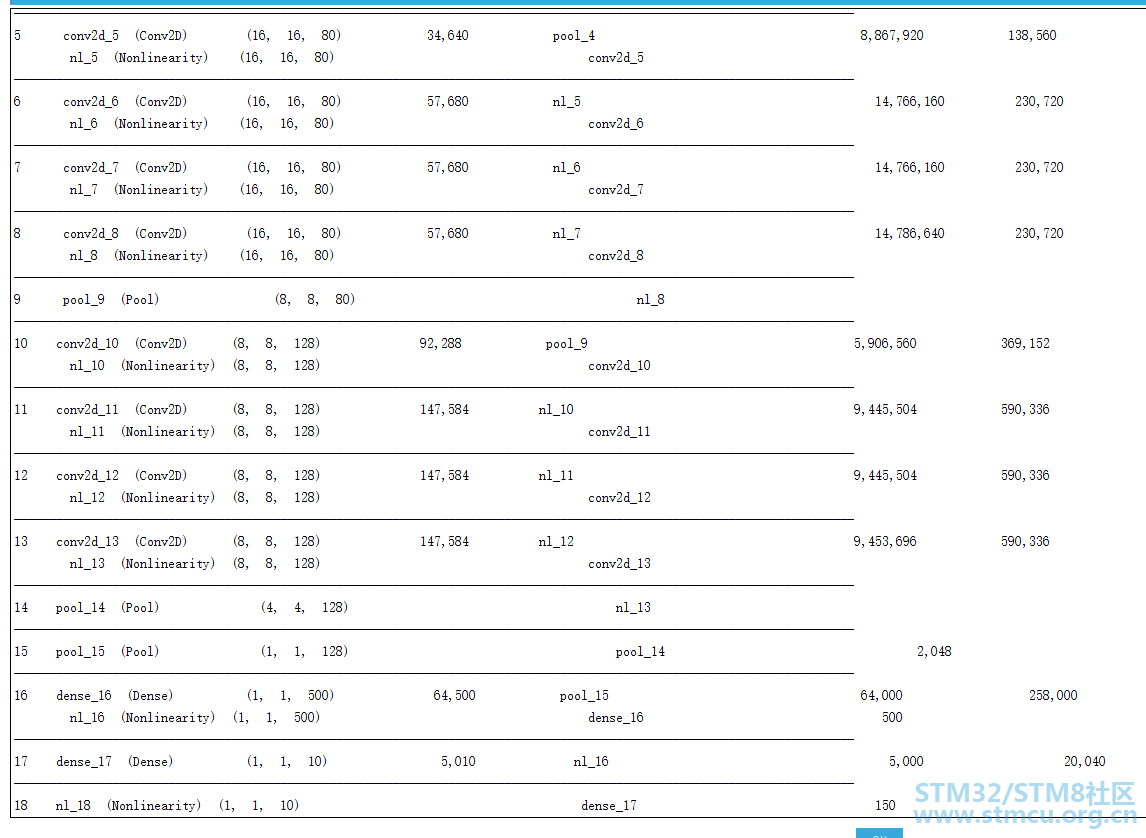

希望论坛支持 一下markdown,我的很多程序readme都是markdown写的。 最近ST弄了个创意大赛,我参加了AI组,今天特意分享了我的测试流程。markdown写的,所以凑合看。希望各位参加比赛的顺利完成,我在疫区所以官方H7-DISCO板子收不到,等 ,有什么问题的话论坛私信我不能及时回复,可以在我别的帖子找我的联系方式。 ,有什么问题的话论坛私信我不能及时回复,可以在我别的帖子找我的联系方式。测试记录,不详细描述怎么做的,一是我觉得手把手教别人怎么做,简直是害了别人,特别是学生,二是深度学习确实所需要知识点比较多,没办法展开。 板子玩的开心就行!!! # cifar10 在 nucleo STM32F767 平台的 测试 ## 软件配置 ### win10 1. cubeMX 5.6.0 2. MDK 5.29a 3. cubemx扩展包--cube.AI 5.0.0 ### ubuntu16.04 1. tensorflow 2.1.0 (内含keras) 2. python 2.7 (ubuntu16.04 自带) 3. cifar10 训练数据 ## 硬件配置 1. nucleo F767 2. 自制扩展板 3. SD卡 4. 扩展板 连接 ST-Link RX TX 引脚的杜邦线 ## 测试步骤 * 在 ubuntu16.04 的操作不叙述 * 直接将转换的模型(模型约4MB),利用cubemx转换,暂称为STM32_AI_Model。

* 模型参数存储在W25Q128中,系统初始化时,QSPI进行内存映射,方便STM32_AI_Model读取模型参数。 * SD卡中读取29张测试图片均来自互联网,利用bmpconvST转换并缩小至32*32分辨率。 * RGB每个通道需要进行预处理,即R/255 G/255 B/255 * 图片在STM32_AI_Model的模型输入数据组织应为: | R1 | G1 | B1 | R2 | G2 | B2 | ... | * 循环从SD卡读取BMPt图片,显示在LTCD驱动的屏幕上,经过STM32_AI_Model推理后的结果,串口打印出来。 推理结果的数据组织为: | C1 | C2 | C3 | C4 | ... | C10 |,每一哥数据代表对应种类的可能性。 * 可能性最大的即为推理最有可能的种类,cifar10即十种。 ## 测试结果 ### 串口打印: sd_card_mount_ok airplane: 1.000 * airplane: 1.000 * automobile: 0.998 * automobile: 1.000 * airplane: 1.000 x dog: 0.584 x bird: 1.000 * dog: 0.999 x dog: 0.874 x frog: 1.000 x cat: 0.993 * dog: 0.764 x deer: 1.000 * airplane: 0.906 x dog: 1.000 * dog: 0.999 * deer: 0.810 x bird: 1.000 x frog: 0.688 * frog: 1.000 * horse: 1.000 * horse: 1.000 * horse: 1.000 * ship: 0.664 * ship: 1.000 * ship: 1.000 * truck: 1.000 * ship: 0.658 x truck: 1.000 *

### 测试准确率 * 19/29*100%=65.5% ### 测试总结 * 图片中比较常见的东西模型很容易辨认,图片第二行第三个是青蛙头上有一个蜗牛,辨认错了,还有四只猫居然只对了一只,其余的比较正常,毕竟图片分辨率不高。 * 由于我是用的深度学习模型是cifar10测试准确率比较高的,所以模型比较大,计算复杂,STM32F7推理时间约四五秒。 |

经验分享 | STM32 AFCI 方案 TensorBoard 使用指南:AI 模型调优可视化终极方案

STM32F334运行超轻量级神经网络推理框架TinyMaxi进行端侧推理

【DIY-STM32N6570-DK-MINI板子功耗测试】

兔哥的边缘AI【001】——DIY-STM32N6全IO扩展板

实战经验 | STM32 AFCI方案TensorBoard的使用介绍

【STM32N6570-DK评测】1.你好N6

【STM32N6570-DK评测】1.开箱测评

实战经验 | STM32 AI Model Zoo 的安装及实例介绍

【STM32H7S78-DK评测】移植AI框架TensorFlow【DSP指令加速篇】

【STM32H7S78-DK评测】移植AI框架TensorFlow【下篇】

微信公众号

微信公众号

手机版

手机版

@楼主,只是想告知一下Markdown的编辑器已经就位,欢迎楼主输出更多关于AI方面的见解

两年了,很少逛论坛了

哈哈, 欢迎多回来逛逛,提提宝贵意见